Search the Community

Showing results for tags 'esxi'.

-

Hallo zusammen, hier ist eine Anleitung zum Update des Boot Loaders auf Jun's Bootloader V 1.02b.Basiert auf Synology DS3615xs und VMware ESXi v6.5. Upgrade des Jun's Bootloaders von V1.01 auf V.1.02b, damit man DSM 6.1.x (i.d.F. 6.1.5-15254 Update 1) installieren kann. 1. Vorher DSM ausschalten und die betroffene VM mit DSM bzw. Xpenology vom ESXi-Datastore auf lokale Festplatte sichern. Im Falle eines Problem ist somit für Backup vorgesorgt 2. In der gesicherten VM-Ordner befindet sich ein synoboot.img. Diese Datei entpacken und in der "grub.cfg" -Datei (synoboot\boot\grub\grub.cfg) nachschauen, welche Einstellungen aktuell hinterlegt sind. Dieser Textbereich ist relevant: set vid=0x058f set pid=0x6387 set sn=B3Lxxxxx (Eure SN-Nummer!) set mac1=011xxxxxxx (Eure MAC-Adresse!) set rootdev=/dev/md0 set netif_num=1 set extra_args_3615='' 3. Die aktuelle Jun's Bootloader (synoboot.img) in der aktuellen Version (derzeit V.1.02b) für DS3615xs hierüber herunterladen. 4. Die heruntergeladene synoboot.img mit der OSF-Mount Software mounten. Dabei beachten, dass beim Mounten die Optionen " Mount All Volumes" angehackt und "Read Only drive" nicht ausgewählt ist 5. Danach im Windows-Explorer in das gemountete Laufwerk navigieren. In der "grub.cfg" der gemounteten synoboot.img-Datei (\boot\grub\grub.cfg) die Informationen(MAC-Adresse, SN-Nummer usw.) von der alten "grub.cfg" -Datei übernehmen bzw. überschreiben und die Änderungen speichern. Danach die zuvor gemountete Datei wieder über OSF-Mount dismounten (Dismount All & Exit) 6. Die Alte "synoboot.iso" Datei auf dem VMware-ESXi Datastore löschen und durch die aktuelle synoboot.img ersetzen (hochladen) 7. Danach die VM mit DSM bzw. Xpenology auf dem ESXi wieder starten. Wichtig: Über die VMware Konsole unmittelbar nach dem Start mit der Tastatur "Jun's Bootloader for ESXi" auswählen und mit ENTER bestätigen 8. Im Web-Browser "find.synology.com" und mit ENTER bestätigen. Synology Web Assistant sucht jetzt nach der DSM und zeigt den Status als "migrierbar" an. Dort auf "Verbinden" klicken und auf die DSM verbinden. Dort steht jetzt: "Wir haben festgestellt, dass die Festplatten Ihres aktuellen DS3615xs aus einem vorhergehenden DS3615xs entnommen wurden. Bevor Sie fortfahren, müssen Sie einen neueren DSM installieren." 9. Nun kann man die .pat-Datei (DSM-Firmware) hinzufügen und manuell installieren lassen aber oder automatisch die neueste DSM Version vom Synology-Server (online) installieren lassen. Ich empfehle euch die manuelle Installation, da es keine Garantien gibt ob die aktuellste DSM-Version vom Synology-Server (online) mit eurem Xpenology Boot Looder funktiert. Ich habe meine (diese) Installation mit der DSM Version "6.1.5-15254 Update 1" erfolgreich hingekriegt. Hier könnt ihr diese Version herunterladen: DSM_DS3615xs_15254.pat 10. Nun auf "Installieren" anklicken und danach "Migration: Meine Dateien und die meisten Einstellungen behalten" auswählen. Auf "Weiter" und "Jetzt installieren" anklicken 11. DSM wird nun auf dem neuen Jun's Boot Loader installiert (dauert ca. 10 Minuten) 12. Nach der Installation im DSM anmelden und die durch den DHCP-zugewiesenen IP nach Wunsch wieder anpassen bzw. ändern Fertig.

-

(извините много букв, прошу разъяснить про виртуальные машины новичку) я изначально использовал xpenology на голом железе в hp microserver gen8 (стоковый celeron 4+8 Гб ram). пара первых рейдов с ext4 организованных самой xpenlogy были, ssd-кэш для чтения пробовал делать. c btrfs экспериментов не проводил. в целом всё выглядело вполне надёжно: загрузчик на sd-карточке, с неё грузился, в случае чего, карточка менялась, на неё залилвался такой же загрузчик. сама xpenology получалась какбы размазана по всем hdd, то есть если какой-то выходил из строя, то даже установленные пакеты не переставали функционировать после устранения неполадки. недавно был заменён процессор на xeon 1270v2. с установкой нового процессора решил расширить горизонты своих познаний и перейти на esxi. для этого у hp есть даже спец образ. его прекрасно установил на sd-карточку, с которой система загружается. не то чтобы сразу, но всё что хотелось реализовать получилось: крутится xpenology, рядом пара debian'ов. с rdm и прочими толстыми виртуальными дисками кое-как разобрался. в производительности hdd немного сомневаюсь, но для текущих нужд пока это не критично. usb 3.0 не работает - вот это засада, но пользуюсь им не часто, поэтому пока не обращаю внимание на это (хотя когда надо, хочется, конечно, чтобы "оно" побыстрее копировалось). так вот вопрос: я понимаю, общественность утверждает что esxi в отличие от proxmox больше заточена под установку на sd-карточки. но всё же, сдохнет карточка, ну не через месяц, но через полгода точно. и что меня ждёт? как-то можно снимать образы с этой карточки, чтобы в случае чего восстановить всё "как было"? тут конечно кто-то скажет, что можно нагородить рейд для esxi, но в моём случае это слишком расточительно. и я размышляю дальше. есть ведь virtual machine manager. который synology, позиционируют как гипервизор. судя по всему там имеют место проблемы с динамическим распределением ресурсов оперативной памяти. но если прикинуть, так, на вскидку, если завести это дело на raid1 с btrfs на текущем железе (3,5 ггц 4 ядра, 8 потоков, 12 гб озу) и крутить там 3-4 виртуальных машины на линуксе для домашних экспериментов, хватит ведь ресурсов (им ведь будет выдаваться отдельные ip роутером? свобод докера, кажется, мне не хватает)? в целом я конечно склоняюсь к xpenology на чистом железе, но сомневаюсь из-за поверхностных знаний. спасибо за внимание.

-

Hello folks, I have search on the forum and internet and I can't find an information on how to do it. There is some tutorial to do it without esxi but not with it. Currently, I don't have enough space on other disk to save everything and make a fresh install. So I would like to update without loosing any data. Does someone already did it ? For my understanding, I should select Jun's mod 1.02b vmdk file and start it as a primary drive. But will it update or overwrite the current xpenology? Thx, David

-

Turned my trusty HP54L off over the Christmas period for a few days when I wasn't using it. Came home, booted it and Esxi won't boot. While trying to boot, it gives: error loading /s.v00 fatal error: 6 (Buffer too small) This sounded to me like a RAM issue. 2GB RAM is successfully detected upon boot. When I initially installed Esxi years ago, I followed a guide to hack the Esxi install to allow 2GB RAM. I took the RAM out, gave it a technical blow, put it back into the other RAM slot. Re-booted and same error. Again, 2GB RAM is successfully detected. Any suggestions on how to troubleshoot further?

-

Hi ya all, I'm new to ESXi and XPEnology and mabe someone here can help me out with my problem. I have the problem that none of my harddisks are vissable in XPEnology Storage Manager. The SATA controller is setup as passthrough in ESXi 6.5 This is my setup: 2x Xeon L5640 @ 2.27GHz 64GB 1333MHz RAM 2x 250GB SanDisk NGFF SSD LSI SAS9201-16i 16-Port SAS/SATA controller (the card is set passthrough in ESXi) Software = ESXi 6.1 Update-1 XPEnology 6.1 DS3615xs 6.1 Jun's Mod V1.02-alpha Is there something I have to do to make XPEnology recognise all de harddisks that are connected to the SATA controller? Could it be that it is driver related, however I have read that my SATA controller 9201-16i is compatible http://xpenology.me/compatible/ Any help on this is greatly appriciated. Thanks in advance!

-

Bonjour, je suis dans un environnement vmware esxi 6.5 je me pose la question suivante: si je mets une vm 3615xs, est-ce que si je lui affecte 4 vCPU les 4 seront utilisés? ou suis-je obligé de passer par la vm 3617xs étant donné que le 3617xs est un model avec un proc 4 cœurs contrairement au 3615xs qui est model avec un proc 2 cœurs. mog

-

Ich habe hier auf zwei HP Microserver ESXi 6.5u1 laufen. Auf beiden habe ich zusätzlich ein vSwitch ohne NIC mit 9000er MTU erstellt. Auf beiden ESXi Host habe ich jeweils ein DS3617sx 1.02b mit folgender Konfig: - Nic1 ist auf vSwitch0 (mit pysikalischer NIC, MTU 1500) - Nic2 ist auf vSwitch1 (ohne pysikalischer NIC, MTU 9000) Bei einem von beiden Hosts, ist DSM nach der Umstellung von Nic2 auf MTU 9000 über kein Interface mehr erreichbar, so als wenn generell auf MTU9000 umgestellt würde. Bei dem anderen Hosts funktioniert das Ganze interessanterweise problemlos. In beiden Fällen handelt es sich um eine ehemalge DS3615sx 1.01 installation, die auf DS3617sx mit "Daten behalten" migriert wurde. Ich hab einfach das img genommen und die grub.cfg angepasst, mit StarWind V2V Image Converter zu einer ESXi Server vmdk umgewandelt, diese in den Datastore hochgeladen und dann die Bootfestplatte in der VM-Konfig ausgetauscht. Um die DS3617sx wieder zum leben zu erwecken, habe ich wieder die alte Bootplatte von DS3615sx genommen, gestartet und neu migriert. Dann VM gestopped und wieder die DS3617sx Bootplatte zu verwenden und erneut zu migrieren. Sprich: ich bin wieder auf dem Stand vor der MTU9000 Umstellung. Hat jemand eine Idee warum die Umstellung von Nic2 auf MTU9000 auch die MTU von Nic1 berührt hat?

-

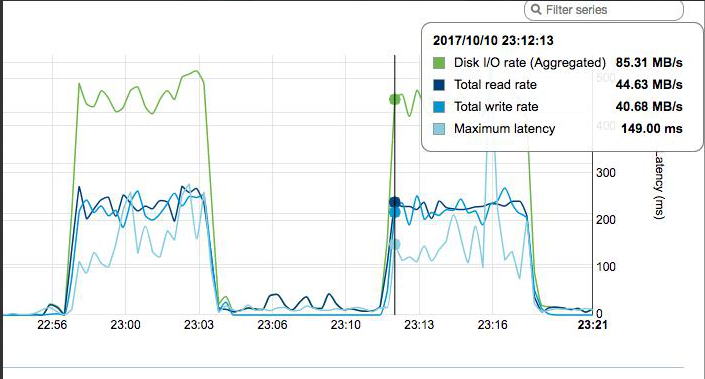

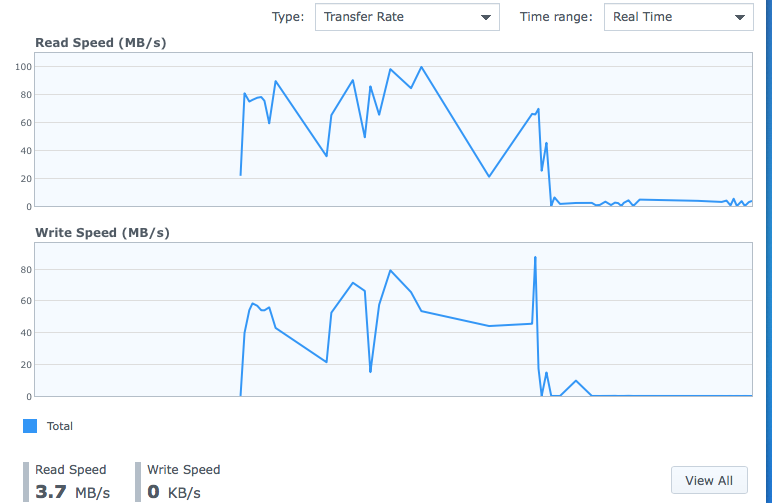

Всем привет. Столкнулся с проблемой вопроизведения фильмов в Video Station. DSM установлена на esxi 6.0. Сервер Supermicro, Adaptec Raid, диск WD 3Tb Green просто как Volume. Ресурсов нормально, Диски в DSM подцеплены как vmdk-ашки, полный проброс не могу себе позволить, живут еще виртуалки) Смотрю фильмы с iPad и ТВ-приставки на Android. Жил довольно долго на DSM 5.2, но сломались обложки, обновился на 6.0, какое-то время тоже было хорошо. Где-то месяц назад стал замечать, что пошли лаги (долго открывается, перематывать вообще не реально, некоторые видосики вообще не играет). Единственное что стояло, так это авто-обновление Пакетов. Соответственно обновился Video Station. Первое - подумал хард, проверил - ок. Дальше пробовал ставить более старые версии VS. Пробовал включать Video Conversion for Mobile Devices, проц грузит, толку нет. Обновил на 6.1, картина не изменилась. Собственно само странное поведение выражается тем, что сначала загрузка по 80Мбит, через минут 5 падает до загрузки равной битрейту (например в 20мбит), Причем странно, что как на чтение, так и на запись идет нагрузка. Если фильм остановить и начать играть заново, картина повторяется. Вот собственно скрин. Начал играть в 22:56 до 23:12, потом заново. Если смотреть это же фильм, но через DLNA или через SMB, все летает. Но так удобна эта чертова Video Station, что не хочу отказываться. Спасибо за любые советы. UPD, выяснилось, что такое происходит только с mkv.

-

I have one ITX box and two SO-DIMM rams on J3455 but J3455 graph card not support pass-through in ESXI I'm searching ITX board and graph card with these features: 1. ITX board with 2 SO-DIMM slot, 4 SATA slot, 1 PCI-E 16x slot, support VT-D, support USB & SATA pass-through on ESXI 2. graph card support pass-through on ESXI I'm not sure whether ASROCK H110M-ITX can do so and it have 2 DIMM slot. Is that possible? Thanks.

- 12 replies

-

- pass-through

- htpc

-

(and 1 more)

Tagged with:

-

Hello, I have a nice N54L running 6.0.2 bare metal and I'm wondering if I should migrate to ESXi hypervisor. I know not much about ESXi, but would it be possible to make xpenology "see" an intel processor instead of an amd ? (would make 6.1.3 migration easier) Is there anything special to know about the migration ? Is this even possible without wiping all data ? (have 4x4 To in AHCI RAID 5) Regards

- 1 reply

-

- esxi

- bare metal

-

(and 1 more)

Tagged with:

-

Hello I install xpenology 6.1.3 with bootloader 1.03b on esxi6.5 I want to attach physical disk to xpenology, so I mount disk as RDM. First I set disk like this but I fall in DSM install loop. So I made 8GB virtual disk in my ssd and attach it it like this. Than the installation process was find but when I made RAID group and volume and reboot my vm, all the RAID group and volumes are gone. I'm dealing this problem around 12hr but I don't know what the problem is...... Plz help me

-

Hello all, Unfortunately, I was unable to install 1.02b on esxi 6.0 Update 3 by following different guides throughout the forum. So after a few hours of testing, I wrote myself a guide for future use. I tested these situations: 1. DS3615 baremetal in basic disk -> VM 2. DS3615 baremetal in raid 1 disk -> VM 3. DS3617 baremetal in basic disk -> VM 4. DS3617 baremetal in raid 1 disk -> VM 5. VMs back to baremetal in both basic and raid 1 disk without losing any data. My personal guide is attached as a PDF. Install on ESXi 6.0U3.pdf

-

Im running ESXi 6.5 on a HP Proliant MicroServer G8. I managed successfully to run the latest XPEnology on a new VM and I attached a couple of virtual disk on it for testing before I transfer my data. Everything looks fine until I tried to mount my USB Disk which will store my MacBook's Time Machine Backups. The same disk can be mounted on my Win Server VM but, not on the XPEnology one. I even tried to hard mount it via SSH without any luck. I installed vmware tools but nothing again. I tried both USB2 and USB3 ports. What else would you advised me to try in order to mount that disk?

-

Hey guys, I hope anybody can help me, because I've already tried nearly everything. I'm running XPEnology 6.1 Update 4 with Juns Loader 1.02b on a ESXi 6.0 VM. The ESXi Host is a HP Microserver Gen8 and i'm already using the hpvsa-5.5.0-88OEM driver. I've created 3 basic volumes, all on a seperate disk. If i move a file from one disk to another on the DSM interface, the transmission is really quick (more then 100mb/s). If I write a file on one of the shares from a Windows-VM on the same ESXi-Host, it is also quick (about 70mb/s). But if read a file on the SMB share, it starts at 6-7mb/s and gets a bit faster, but not more than 20mb/s. I have created a new XPE-VM, changed the network-card of the VM, gave the VMs more RAM, but nothing helped. Does anyone have an idea, why it is working perfect in one direction but so bad in the other?! I've found some threads, where the people wrote, that it works nicely on a baremetal installation. But i really need the Windows-vm on that machine and I also like ESXi very much.

- 15 replies

-

- esxi

- performance

-

(and 2 more)

Tagged with:

-

I'm out of ideas of how to debug this, but perhaps someone else knows what's going on. This is probably not an Xpenology specific issue, but I'm sure others here have experience using the LSI 9211-8i and ESXi together. I recently did a new build for my NAS with the following hardware: Ryzen 5 1600 ASRock B350 Pro 4 Mobo WD Green m.2 SATA SSD (used as VM datastore only) LSI 9211-8i SAS Controller I am running ESXi 6.5u1 on this setup which was perfectly stable until I added the LSI 9211-8i SAS Controller, since adding this card the system crashes if left idle for more than 30 minutes. Timeline of events: Initially using a LSI 3081E-R controller in pass-thru mode (with test drives since I didn't realise >2TB drives were not supported when I picked up the card for $30.) Online - Several weeks without issue until my LSI 9211-8i controller arrived. Added LSI 9211-8i controller to DSM VM in pass-thru mode with 4x 4TB WD RED HDDs Did disk parity check performed on new SHR array. Took about 8 hours. Offline - Less than an hour after parity check completed the system 'hard locks'. Thought it might be a one-off incident. Rebooted the system, did another parity check to make sure everything was ok. Offline - Again, less than an hour after parity check completed the system 'hard locks'. Updated the firmware on the LSI 9211-8i to v20 using IT mode. Thinking the problem was solved as I was now using ESXi supported firmware, started a data transfer task of 8TB of data, this took about 18 hours and the system stayed online the entire time without a hitch. Data transfer finishes, feeling pretty confident the firmware upgrade has worked since it's been online for this long, spend a few hours doing benchmarks and setting things up. System was online for over 24 hours. Offline - An hour or so after I stop 'doing stuff' with the system, it's hard locked again. Thinking the issue might be IOMMU pass-thru support, I disabled pass-thru mode, installed the official driver from the vmware site for the LSI 9211-8i and mounted the disks into the DSM using ESXi Raw Disk Mappings. Offline - An hour or so after I stop 'doing stuff' with the system, it's hard locked again. Realised it's only crashing when the system is 'idle'. Looked into power saving modes, disabled "C-State" and "Cool 'n' Quiet" in the host bios. Also disabled all power saving features in ESXi. Offline - An hour or so after I stop 'doing stuff' with the system, it's hard locked again. This morning I hooked up a screen to the host in an attempt to see if there was a PSOD or any message before it locks, there was not - just a black screen. System not responsive to short-press power button or keyboard. Offline - less than 40 minutes after sitting idle from boot, it's hard locked again. In addition to the steps taken above, I have tried to find a reason for the lock ups in the ESXi logs, there is seemingly nothing, one minute it's working fine, then nothing until it's booting up again after I power cycle the system. There are no core dumps. Each time nothing was displayed on the screen of the host . It just seems odd the system would crash only when sitting idle - it would make more sense if it was crashing under load. Now these issues only started to occur once I added the LSI 9211-8i to the mix, the LSI 3081E-R did not cause these same issues. Do I just have a dodgy card? I don't want to buy another LSI 9211-8i if I'm going to have the same issues. Is there another card I should get instead? Are there any other settings I should try to make this system stable?

-

Bonjour, je voudrais savoir comment faire pour créer une sur vmware en partant du loader en .img ? soit avec ce loader ou bien celui ci D'avance merci

-

I have installed multiple XPEnology DS3617 on ESXi server, and setup file sync using DSM's "Shared Folder Sync". Recently, there has problem in "Shared Folder Sync", an error of "Operation failed" is prompted when I press the [Create] or [Edit] button in the task list. This feature should works before, I'm not sure if any recent update in package center cause this issue. Recently, I have updated the "File Station" in package center, and a new version DSM 6.1.3-15152 Update 3 is ready to update, but I have not update yet. Anyone here encounter such problem in "Shared Folder Sync"? Is there any thing I can do to solve this issue? Thanks in advance.

-

Bonjour, Je suis actuellement en pleine migration de serveur. J'était sur un ESXi en 5.5. J'avais un DSM 5.x. Aujourd'hui je passe sur un ESXi 6.5, cependant j'aimerais profiter de cette migration pour passer sur du DSM 6.x. J'ai essayé pas mal de choses que j'ai vu sur le net, ici et ailleurs. Rien n'abouti, VM qui de démarre pas et j'en passe. J'aimerais repartir de 0 en suivant vos conseil, vos lien de qualité. Merci d'avance pour votre aide.

-

A little help for everyone who struggles a little bit with enabling the serial console in ESXi. This manual works 1:1: https://www.juniper.net/documentation/en_US/vmx15.1f4/topics/task/configuration/vmx-vm-connecting-vmware.html in short: # at ESXi: open Firewall for serial Console # at VM: add Serial Port 1 - Use Network - Connect at Power - Direction: Server - Port URI: telnet://:8601 In PuTTY the connection will be made as: Type: Telnet Hostname: IP-of-your-ESXi-Host Port: The-port-you-entered-in-the-config-of-the-VM (e.g. 8601) With this you have at every time contact to the Xpenology-VM-Console even a driver wont be load with a upgrade (like in Loader 1.02a).

- 13 replies

-

- 4

-

-

-

- vm

- serial port

-

(and 1 more)

Tagged with:

-

Hi, for quite a while I'm trying to find out why hard disks do not spin down after the set time with DSM 6.x and ESXi Hypervisor (6.0 or 6.5) using Jun's loader. Hard disks are connected to a passthrough SATA Controller (onboard, also tried PCIe). Exactly one and the same setup is working bare metal, also with DSM 5.2 on ESXi. I even tried using a boot iso (as with DSM 5.2) that uses the passthrough USB boot stick (like with bare metal) instead of synoboot.vmdk/synoboot.img combination. No spindown, hdparm -y does a spindown, however disks wake up at once again. I can't see any differences in the logs between running bare metal or on ESXi. Would appreciate any further ideas.

-

Как оказалось, у новичков возникают сложности с инсталляцией Хренологии на ESXI. поэтому решил написать краткий мануал, призванный облегчить жизнь. дополнения и уточнения приветствуются. 1. подключаемся к ESXI и создаем на датасторе директорию 2. далее в созданную директорию копируем 3 файла вот от сюда 3. после окончания копирования регистрируем нашу машину в ESXI указав на наш .vmx файл собственно доходим до финиша и жмем его все! машина установлена. но ее необходимо настроить перед запуском. 4. в настройках рекомендую задать необходимые параметры процессора и памяти, и обязательно указать размер резервируемой памяти. при недостаточном объеме зарезервированной памяти машина может не запуститься. далее необходимо создать виртуальный жесткий диск и указать его объем. после чего можно перейти на вкладку VM Options и поменять название машины на то которое нравится вам в принципе наша машина уже работоспособна. это простейший способ создания виртуальной машины. Лично я поступил немного иначе: можно или пробросить целиком дисковый контроллер в вашу виртуальную машину и подключить диски к контроллеру поставив крыжик и нажав на Toggle Passthrough после перезагрузки добавив в настройках новый PCI девайс. если у вас нет возможности пробросить целиком контроллер, можно подключить целиком физические диски, не пробрасывая весь контроллер называется это pRDM, как это делается подробно расписано здесь. данный способ хорош еще и тем, что диски целиком можно выдернуть и вставить в физическую машину, без лишних плясок с бубном, если вдруг ваши планы изменятся, а данные скопировать не куда. 5. запускаем машину. при первом запуске говорим: "я скопировал это" после чего стараемся успеть выбрать правильную загрузку далее выжидаем пару минут и начинаем искать свою машину в сети или через сервис http://find.synology.com, если вдруг сервис машину не найдет, то не паникуем и ищем через Синолоджи Ассистента. далее подключаемся к найденной машине и устанавливаем ОС просто нажав на Install Now и спокойно наблюдаем за процессом вводим свои данные, и желательно отключаем крыжик на следующем окне в самом низу говорим "пропустить данный шаг" вот и все, заходим в панель управления и в диспечере хранения радостно видим свои диски. ну и думаем как рачительно распорядиться этим богатством ну и в конце рекомендую установить vm-tools вопросов ввода серийного номера и МАК адреса касаться не стал, все это многократно расписано на форуме можете кидаться тапками, спасибами, кому что нравится.