Orphée

Contributor-

Posts

1,372 -

Joined

-

Last visited

-

Days Won

49

Everything posted by Orphée

-

If you really need to have a Windows VM with an iGPU and you know Proxmox... Don't bother with VMM... https://community.synology.com/enu/forum/1/post/135055

-

Just switch to DS918+ loader... it is genuine supported with your iGPU. Why do you want to hack DS3622xs+ when DS918+ is working just fine as long as you know how to iGPU passthrough ? You expect to passtrough the iGPU from DSM to a Windows VM using VMM from Synology ? I don't know if VMM is able to do it.

-

Pour moi, ARC pose un soucis de légalité avec ces "arc-patch" ... C'est le loader le plus "en risque" vis à vis de Synology...

-

S'il ne t'affiche pas de message te demander de "récupérer/migrer/conserver" tes données, tu annules tout et tu stoppes l'installation... et ensuite tu communiques pour comprendre.

-

Develop and refine the DVA1622 loader

Orphée replied to pocopico's topic in Developer Discussion Room

Not related to DVA1622 loader, you should check dedicated Nvidia custom library module topic (there is already one somewere, search for it). -

Develop and refine the DVA1622 loader

Orphée replied to pocopico's topic in Developer Discussion Room

Can't be clearer : -

En théorie oui, tant que tu le paramètres correctement et qu'il détecte les disques de la même façon que ARPL. Mais ça vaut également vers/depuis TCRP (avec ou sans m-shell) Tous les loader sont logiquement cross-compatibles. La seule importance, c'est ce qui est stocké sur ton/tes disques durs.

-

Well calm down, we are lucky to have alternatives. @Peter Suh and @pocopico are doing a great job too, and it is a good thing to not have only one choice. I also really like ARPL like loaders, but I really appreciate their effort with TCRP (M-shell) I also test it quite often to see the progress done with it.

-

It should not happen.

-

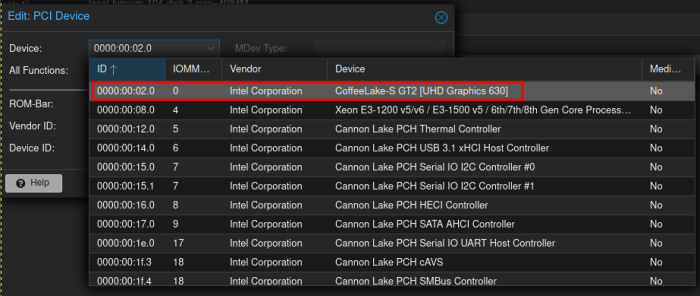

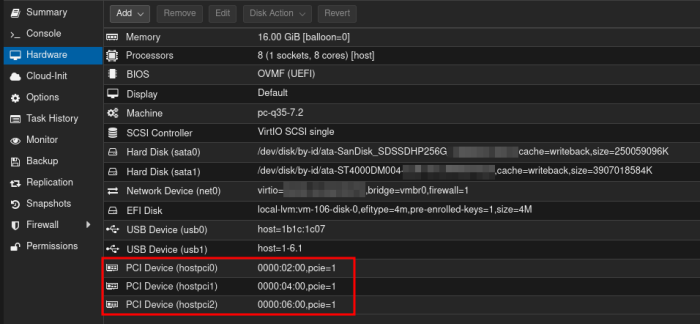

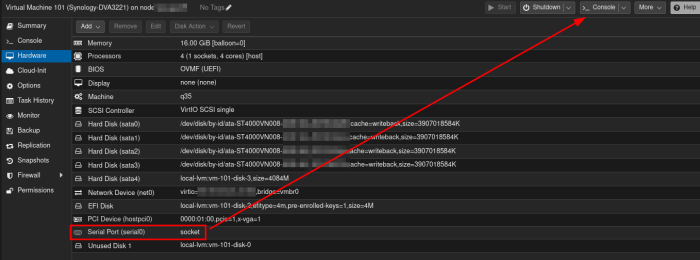

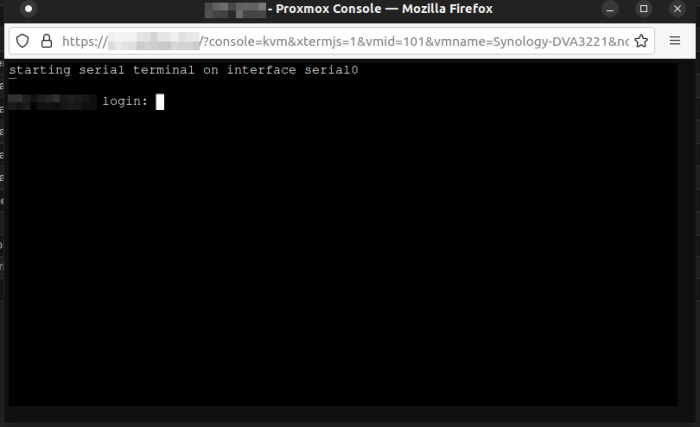

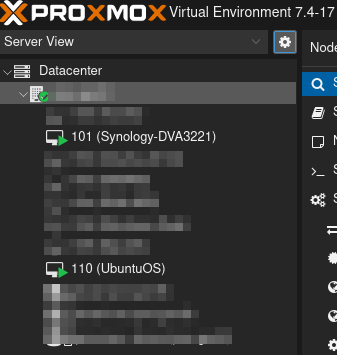

Alors je suis passé de VMWare ESXi à Proxmox. Et je dois dire que pour un usage perso, je ne reviendrai pas en arrière. Comme impératif, la carte mère doit être capable de faire du IOMMU (VT-d) mais c'est déjà vrai aussi pour ESXi. Il faut configurer le grub de Proxmox pour activer le passthrough. Pour ma part j'ai du également activer le ACS override pour isoler dans des groupes IOMMU séparé chaque composant PCIe. Je n'ai pas étudié la faisabilité avec AMD, je n'utilise que du Intel. C'est assez bien détaillé : https://pve.proxmox.com/wiki/PCI_Passthrough Ma ligne grub ressemble à ça : GRUB_CMDLINE_LINUX_DEFAULT="quiet intel_iommu=on iommu=pt pcie_acs_override=downstream,multifunction initcall_blacklist=sysfb_init" Il y a un petit script bash qui permet de voir les groupes IOMMU : #!/bin/bash shopt -s nullglob for g in $(find /sys/kernel/iommu_groups/* -maxdepth 0 -type d | sort -V); do echo "IOMMU Group ${g##*/}:" for d in $g/devices/*; do echo -e "\t$(lspci -nns ${d##*/})" done; done; En gros, quand tu décides de passthrough un composant, tous les composants associés au même groupe IOMMU doivent être passthrough dans le même package... C'est pour ça que j'ai du activer le pcie_acs_override. Sans ça mes 2 cartes graphiques étaient dans le même groupe et je ne pouvais pas les séparer (obligé donc de les passthrough les 2 dans la même VM...) Mais une fois que tous les prérequis sont "OK", c'est assez simple... Tu ajoutes simplement un nouveau périphériques PCI depuis l'IHM Proxmox dans la config hardware. Ce que j'ai surtout trouvé génial avec Proxmox, c'est la gestion du port série, et l'affichage via HTML5. Pour débug Xpenology, c'est le feu, pas besoin de putty, ni de galérer avec l'ouverture de ports spécifiques depuis ESXi... Il suffit simplement d'ajouter un "Serial Port" depuis l'IHM, puis quand on clique sur "Console" : Ca ouvre directement la console en HTML5 : Et du coup ça marche de n'importe où, même depuis l'extérieur (si t'as ouvert l'accès web vers proxmox), puisque ça passe par l'accès web proxmox. Et c'est officiellement gratuit/opensource... pas besoin de trouver une licence sur le web pour accéder aux fonctions "premium" (comme l'accès au serial port via TCP par exemple...) Et accessoirement, OVH propose des template Proxmox parmi les choix possible quand on loue un serveur chez eux, du coup on est pas dépaysé pour se monter une config dans le cloud. Et just for fun :

-

Corsair HX1000i ├── VRM temperature 49.8 °C ├── Case temperature 42.2 °C ├── Fan speed 0 rpm ├── Input voltage 230.00 V ├── +12V output voltage 12.05 V ├── +12V output current 8.25 A ├── +12V output power 96.00 W ├── +5V output voltage 5.00 V ├── +5V output current 3.19 A ├── +5V output power 15.50 W ├── +3.3V output voltage 3.30 V ├── +3.3V output current 1.50 A ├── +3.3V output power 4.50 W ├── Total power output 158.00 W ├── Estimated input power 173.00 W └── Estimated efficiency 91 % A mon avis ça consommera toujours moins qu'une machine dédiée au DVA3221. Edit : Techniquement je peux même passer l'iGPU du Core i9 dans une 3ième VM (déjà testé)

-

Tout à fait ! J'ai une carte audio SoundBlaster PCIe dédiée en passthrough Une carte USB PCIe également dédiée en passthrough (clavier, souris, etc...) La carte graphique GTX980 avec le moniteur branché dessus. Dès que la VM démarre, l'écran s'allume et c'est comme si j'étais sur un PC fixe baremetal. La GTX1650 elle est en passthrough sur Xpenology, sans écran. (pour la carte son et la carte USB j'étais pas obligé, mais c'était dans un soucis de performance/fiabilité)

-

C'est pour ça qu'historiquement, ayant un HP Gen8 incompatible, j'avais trouvé une tour HP avec un core I5 récent et la GTX1650... Ca me faisait tourner 2 machines, plus ma tour perso... Le Gen8 comme NAS principal La tour GTX1650 pour Surveillance Station (la carte mère pourrie n'avait aucun port SATA addtionnel, impossible de placer 4 disques pour remplacer le Gen8) Et ma tour perso avec un Core I7-4790k / GTX980... J'ai tout benné, j'ai gardé tous les disques, et les cartes graphiques. Et j'ai monté une nouvelle machine avec une carte mère Supermicro X11SCA-F (je voulais garder l'IPMI équivalent à l'accès distant KVM du Gen8), un Core I9-9900K, 96Gb RAM (64 suffiraient largement, probablement même 32...). Et j'ai installé dessus un Proxmox, et j'ai tout virtualisé. Les disques de ma tour perso + la GTX980 en passthrough sur ma VM "perso" Et les 4 disques du NAS Gen8 + la GTX1650 dans une nouvelle VM DVA3221... J'étais sous Windows et ça fonctionnait très bien, mais j'ai récemment migré sur une VM Ubuntu.

-

New Nvidia GPU/vGPU Driver for x86 Synology

Orphée replied to pdbear's topic in Packages & DSM Features

Nothing related to to XPenology. Passthrough issue. -

TinyCore RedPill Loader Build Support Tool ( M-Shell )

Orphée replied to Peter Suh's topic in Software Modding

Nice ! Just need the same mount tutorial for Linux users 😝😘 -

J'ai tout expliqué dans mon précédent post. Tu as tous les éléments en main pour comprendre où ce situe ton problème.

-

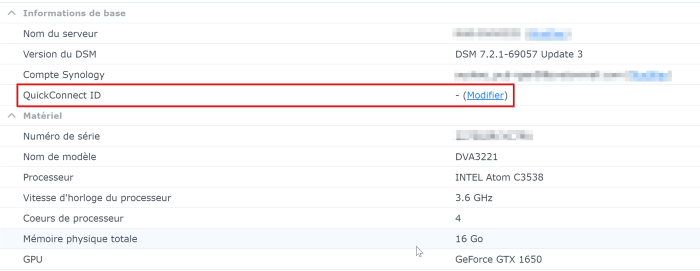

Un DDNS n'a rien à voir avec quickconnect. Avec quickconnect, il n'y a pas besoin d'ouvrir de ports, grace à une liaison entre le NAS Snology et les services chez Synology. Avec un DDNS (que ce soit proposé par Synology ou n'importe qui d'autre) il faut ouvrir les ports (sur la box / routeur) permettant de se connecter au Synology depuis l'extérieur. Les ports par défaut pour DSM sont le 5000 en HTTP et le 5001 en HTTPS. il me semble que depuis DSM7 le port 443 fonctionne aussi pour le HTTPS. La configuration de Quickconnect c'est ici : Que ce soit pour quickconnect ou DDNS, si c'est fourni par Synology, il faut un SN/MAC valide. L'accès via quickconnect se fait via https://[ID_quickconnect].quickconnect.to/ L'accès via DDNS ce fait via ce que tu as défini toi même dans DDNS (http(s)://corsicatrucmuch.synology.me)

-

@RedCat it has nothing to do with the loader ARPL/RR itself but with a DSM issue. You should create a "help" thread dedicated to your issue. Here it will be lost between other answers as it is offtopic.

-

Thanks for your hard work. I already saw a big improvement in performances with SA6400 compared with DS3622XS+ on the exact same Proxmox VM environment. I guess it is because of newer kernel version. ---- Merci pour ce dur travail. J'ai vu une net amélioration des performances avec SA6400 comparé au DS3622XS+ sur la même machine Proxmox. Je suppose que c'est à cause du kernel plus récent.

-

Yep j'ai fait un ticket sur github, instant closed.

-

Merci ! Peu actif ici donc

-

Je veux bien que tu test avec le SA6400, moi c'est échec direct, il ne télécharge rien, et plante derrière. J'ai pas testé d'autres loader... mais essai peu concluant en l'état. A côté de ça j'ai pas eu de soucis à build avec le loader M-Shell de @Peter Suh Edit 2 : par curiosité, savez vous qui est le dev de Arc ? est-il inscrit sur Xpenology ? Il ne me semble pas l'avoir identifié.

-

So you did not understand my point. No matter what driver will actually work. He could make latest 4090 RTX works on NAS system. As long as you/he/anyoned do not rebuild Surveillance Station SPK to accept these cards, you will only use these drivers to have HW transcoding capabilities for software like plex etc... but never for Surveillance Station AI features. No matter if nvidia-smi detect your card. if it is the same as DVA1622, Surveillance Station will generate some dump/core crash files on the filesystem in loop. If you are lucky, DVA3221 Surveillance Station SPK is not hardcoded like DVA1622 is... and then my point is irrelevant.

-

From who ? Synology ? Why would they add support to any other card than GTX1650 ? Unless they release a new DVA product with some new card, don't expect it.