vinceg77

-

Posts

15 -

Joined

-

Last visited

Posts posted by vinceg77

-

-

1 hour ago, JacquesF said:

La plupart des options de configurations des applications se trouvent dans le dossier de l'application et éventuellement le dossier avec un @ devant.

Ceci sous-entend que si on réinstalle les applications, il faut les placer dans le même volume, à moins de rechercher les paramètres dans les fichiers de configuration (un "grep -R "chemin/vers/appli" *" lancé depuis le dossier de l'application devrait permettre de trouver les fichiers concernés).

Mais HyperBackup pourra aider ensuite s'il devait y avoir une prochaine fois.

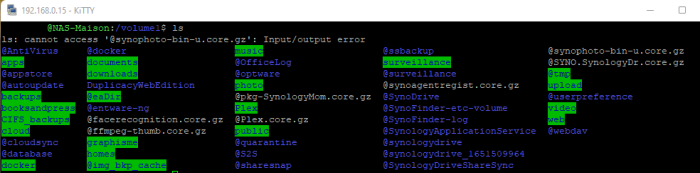

Parmi ces répertoires/fichiers la ?

Pour le reste je suis toujours en train de sauvegarder ... C'est long, mais je suis tellement content d'être en mesure de pouvoir le faire, j'ai jamais été aussi heureux de faire des copies de fichiers !!!

-

39 minutes ago, renegadeBE said:

Tu peux sauvegarder une partie via Le Panneau de configuration -> Mise à jour et Restauration -> Onglet "Sauvegarde de configuration". Tu pourras par la suite les restaurer.

Le paquet HyperBackup te permet lui aussi de les sauvegarder et ce, de façon plus approfondie (à condition de l'avoir installé auparavant).Non ca c'est mort pour moi car je suis désormais sur une installe en DSM 7.1 toute neuve (ce n'est pas une migration de mon ancien DSM 6.2 puisqu'il avait planté). Je n'ai donc aucune application installée ni configurée dessus. Enfin c'est pas grave , je reconfigurerai tout ca, ce qui compte c'est mes données !

-

Merci @JacquesF

3 hours ago, JacquesF said:1) sauvegarder tout ce qui peut l'être

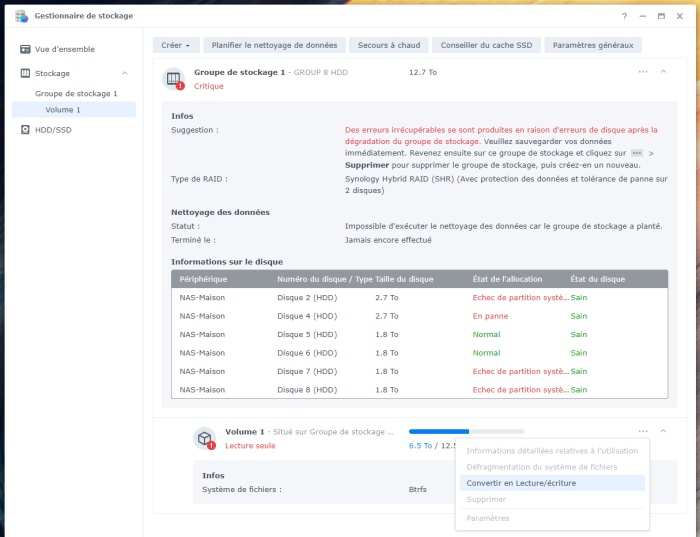

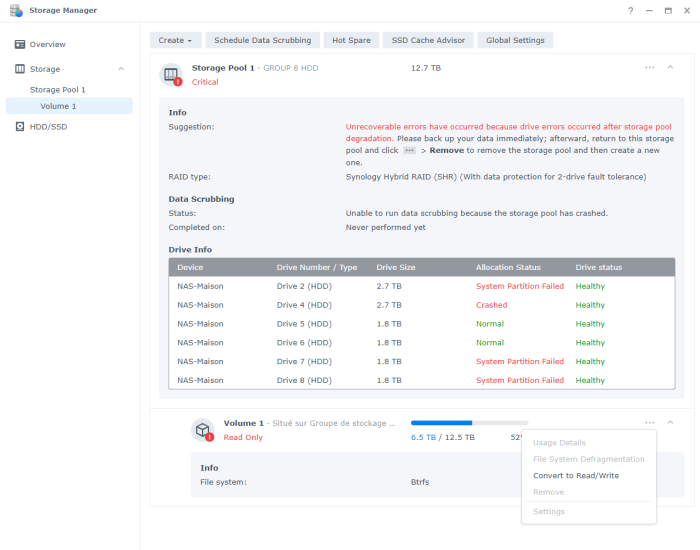

J'ai quand même essayé de changer l'ordre des disques en intervertissant certaines nappes SATA et effectivement ce n'a pas changé grand chose à l'état du Volume qui est toujours en lecture seule, avec les mêmes problèmes d'échec de partition système, les mêmes disques en état 'normal', juste les baies du NAS qui ont changé. Je n'ai plus non plus d'erreurs de sorties I/O en masse sur l'un des disque de 1.8To sur le dsmsg proxmox !

PAR CONTRE la lecture des fichiers du volume fonctionne à nouveau correctement 🤩 (alors qu'il bloquait jusque la toutes les 3s, empêchant de sauvegarder quoi que ce soit).Je suis donc effectivement en train de sortir toutes les données pour les sauvegarder sur des disques externes au NAS

3 hours ago, JacquesF said:3) remplacer le ou les disques trouvés douteux par SMART

4) selon la configuration du ou des disques changés, laisser le raid se réparer ou si ce n'est pas possible, réinstaller le tout, recréer les volumes nécessaires et réinstaller les sauvegardes.

Je rachèterai un disque pour remplacer celui qui affichait des erreurs I/O

Je réintégrerai celui qui devrait revenir de garantie

et je recréerai un volume tout propre pour y réintégrer les données !

SURTOUT : je remettrai en place un process de backup probablement composé d'un HDD externe + solution de backup en ligne pour les données les plus sensibles !

3 hours ago, JacquesF said:Attention, le DSM ne présente pas tous les dossiers via SMB ou NFS (entre autres ceux contenant la configuration des applications). S'il faut tout réinstaller, prendre la précaution avant de bien sauvegarder tous les dossiers utiles.

Tu penses que même en étant passé de DSM 6.2 à DSM 7.1 je pourrais récupérer les configs des applications ?

Comment sauvegarder ces configs ?

Je vous tiens au courant, en espérant que cette bonne tournure perdure, j'ai déjà récupéré toutes les données de ma femme !

-

7 hours ago, vinceg77 said:

A ce stade j'hésite entre :

- 1/ Tenter cette option de conversion en lecture/écriture

-

2/ Essayer d'intervertir les nappes SATA des 4 disques en échec de partition système, quitte à revenir sur le setup actuel si ca n'améliore pas. Mais dans tous les cas :

- il me manque un disque WD red 4 To qui était complètement mort (erreurs I/O, kernel) et qui est reparti en garantie hier

- mon setup n'est plus le même qu'avant, j'étais sur une répartition des disques entre la carte mère et 2 contrôleurs SATA PCIe alors que je suis désormais sur une répartition entre la carte mère (3 HDD) et 1 contrôleurs SATA PCIe (4 HDD)

- 3/ Remonter les disques sous ma VM ubuntu pour voir si le volume se monte et si il est plus lisible que sous DSM... Et si j'ai un peu d'aide de ce forum avec LVM et PV/VG/LV

Si quelqu'un de plus compétent que moi (c'est pas très dur !) a une idée, je suis preneur !

Erratum (cf en gras dans le quote ci dessus) !

On ne peut plus modifier sur ce forum les anciens posts, quel dommage pour la compréhension ! -

Merci beaucoup à @renegadeBE et @JacquesF pour leur retours sur ma situation.

4 hours ago, JacquesF said:Pas lu le post en anglais, mais dans ton message, tu indiques qu'un de tes disques est reparti en réparation.

J'expliquais un peu plus en anglais les étapes par lesquelles j'étais passé avant de parvenir à revoir mon volume, au moins en lecture seule... Je n'ai eu aucune réponse... Les francophones sont plus sympas ! 😀. Je confirme qu'un des 8 disques, le 4To WD red était totalement mort, inexploitable il est parti en garantie.

4 hours ago, JacquesF said:Il est donc manquant dans la grappe raid, et dans ce cas la perte de n'importe lequel de tes autres disques entraînera la perte définitive des données (à moins que ce soit un raid avec 2 disques de redondance, SHR2 ou Raid6).

J'étais effectivement en SHR2 avec 2 disques en tolérance de panne

4 hours ago, JacquesF said:Donc, en ce moment, l'urgence est de sauvegarder les données sensibles, dans la mesure du possible par partage SMB ou NFS, ce sera plus rapide que le SFTP, mais si la connexion coupait souvent, c'est probablement parce que les accès disques doivent être difficiles.

Je confirme pleinement. Vous feriez quoi à ma place dans les 3 possibilités que j'évoquais précédemment ??? (ou autre solution que je n'aurais pas envisagé... pour l'instant je n'ai pas encore touché à rien de plus !)

4 hours ago, JacquesF said:Ensuite, une fois les données à l'abri, réorganiser les disques, les remplacer, réinstaller, etc. sera possible et sans trop de risques.

Oui effectivement l'idée est d'essayer de sauver ce qui est possible sur un autre disque (sur le réseau, en usb, peu importe...)

Ensuite j'attends le retour du 4To WD red, et je rachète un 3To pour remplacer l'un des 2,7To qui présente des signes de faiblesse (l'un des 2 responsable du crash de départ mais qui a finalement été reconnu dans la grappe, et qui m'affiche toujours des erreurs d'I/O sous proxmox) et je repart à zéro en créant un nouveau volume.

-

5 hours ago, renegadeBE said:

Ouf !! Bah nom de Dieu, pour un volume contenant des données sensibles tu n'y as pas été de main morte (j'ai lu ton post en anglais) !

Effectivement j'ai fait n'importe quoi en terme de sauvegardes. J'ai été pris par le boulot depuis 1,5 ans et j'ai été très léger sur le sujet, d'autant qu'effectivement ma femme avait transféré toutes ses données sur le NAS récemment ... J'avais déjà eu des crashs de disques mais DSM 6.x avait toujours fini par reconstituer le volume, j'étais trop en confiance. En ce qui concerne le passage à DSM 7, vu que DSM 6.2 était planté je me suis dit que quitte à passer un peu de temps, c'était le bon moment, d'autant qu'à priori le système de fichiers du volume en BTRFS restait le même sous DSM 6 ou sous DSM 7

Je ne regrette pas (pour l'instant !) les différentes manipulations que j'ai pu faire jusque là, j'ai même légèrement progressé puisque mon volume - bien que très dégradé et difficilement lisible - est au moins visible lors qu'il n'était plus monté hier encore. Je ne désespère pas qu'un expert ait pitié de moi pour aller encore un peu plus loin et m'empêcher de faire des erreurs et de revenir en arrière, jusqu'à la récupération de mes données. D'où mon appel à l'aide !

5 hours ago, renegadeBE said:Concernant l'erreur affichée sur les différents disques (échecs de partitions systèmes), en règle générale, il s'agit de disques placés dans un ordre différent (après, au vu de se qu'il a subit (installation d'une nouvelle version avec des disques crachés, pas certain). Il suffit alors de réparer ! Dans l'onglet "Vue d'ensemble", il ne te propose pas de réparer ?

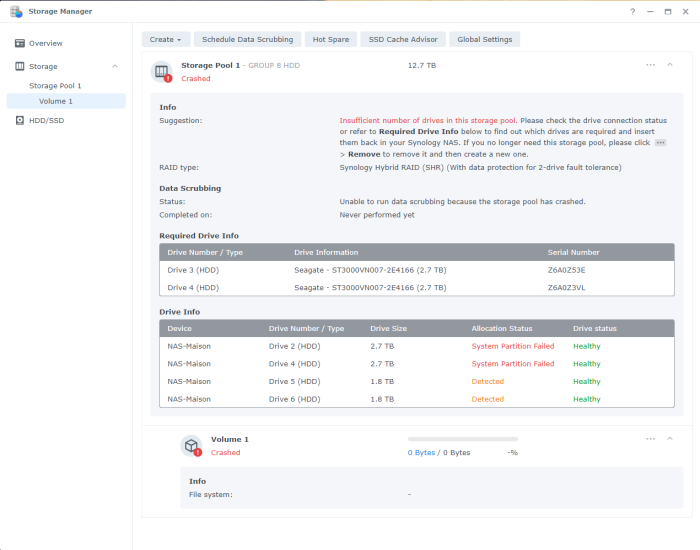

Non il ne me propose que de convertir en lecture/écriture, comme sur ma capture d'écran ci dessous, je n'ai pas l'option de réparer...

A ce stade j'hésite entre :

- 1/ Tenter cette option de conversion en lecture/écriture

-

2/ Essayer d'intervertir les nappes SATA des 4 disques en échec de partition système, quitte à revenir sur le setup actuel si ca n'améliore pas. Mais dans tous les cas :

- il me manque un disque WD red 4 To qui était complètement mort (erreurs I/O, kernel) et qui est reparti en garantie hier

- mon setup n'est plus le même qu'avant, j'étais sur une répartition des disques entre la carte mère et 2 contrôleurs SATA PCIe alors que je suis désormais sur une répartition entre la carte mère (3 HDD) et 2 contrôleurs SATA PCIe (4 HDD)

- 3/ Remonter les disques sous ma VM ubuntu pour voir si le volume se monte et si il est plus lisible que sous DSM... Et si j'ai un peu d'aide de ce forum avec LVM et PV/VG/LV

Si quelqu'un de plus compétent que moi (c'est pas très dur !) a une idée, je suis preneur !

-

Bonjour à tous,

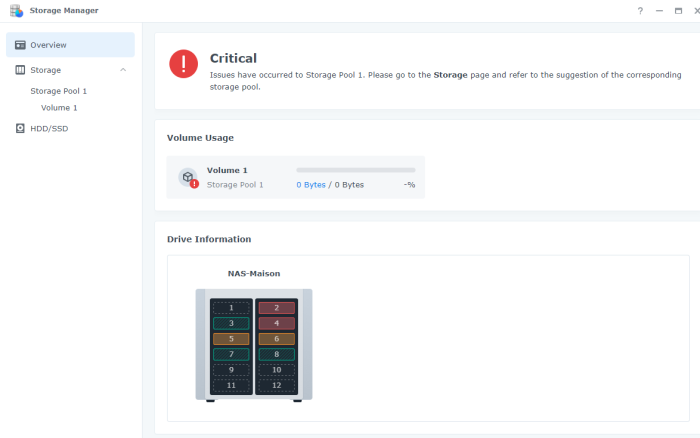

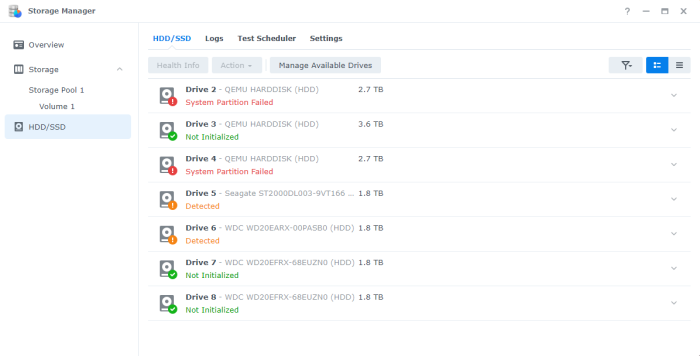

Après avoir connu un crash sur 2 disques avec DSM 6.2 sous proxmox que je ne pouvais plus mettre à jour, mon système est finalement passé en "Configuration perdue"

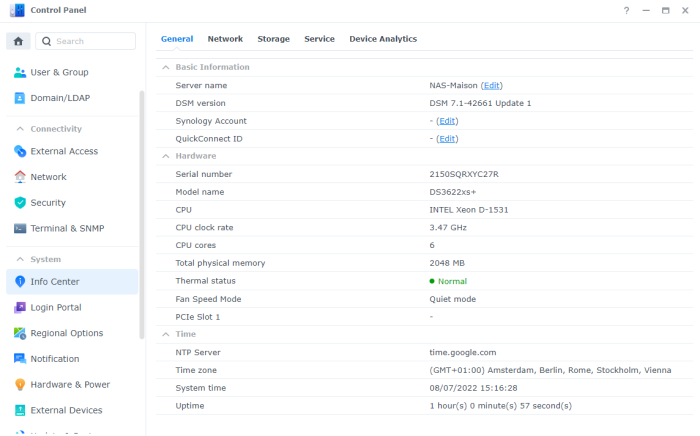

J'en ai profité pour passer sous DSM 7.1 en étant obligé de changer de setup car une de mes 2 cartes contrôleur SATA n'était pas reconnue par TCRP.

Bref, je me suis d'abord retrouvé avec un volume crashé, puis après des essais infructueux de mdam sous une VM ubuntu, puis un redémarrage du NAS, je me retrouve désormais avec un volume réapparu mais en état critique et en lecture seule !

J'ai essayé de me connecter en SFTP pour récupérer mes données mais même si j'ai récupéré quelques fichiers la connexion plante beaucoup trop souvent pour continuer.

Que puis je faire à ce stade ?

Dois je tenter de repasser le volume en lecture/écriture comme proposé ?

Merci d'avance pour votre aide afin que je puisse récupérer le plus de données possibles sans abimer encore plus mon volume

-

After trying ReclaiMe file recovery software under a Windows10 VM which was not working because it was not recognizing all my drives, I restarted DSM 7 and very surprisingly my volume is now seen as critical and read-only!

I tried to FTP to the NAS to backup but the connexion keeps on deconnecting, probably due to data corruption.

What can I do now ?

Should I try to convert the volume to read/write as proposed under the 3 dots ?

What would be the best way to recover my data ?

-

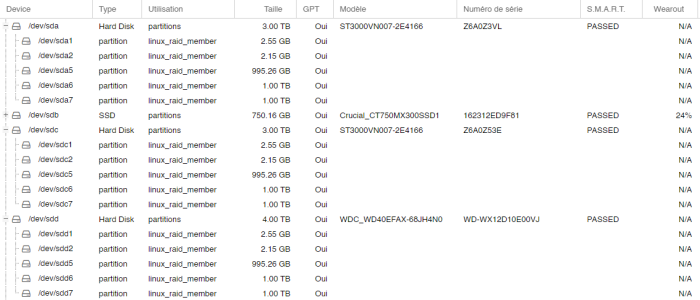

I have mounted all my NAS disks into ubuntu :

admin@VM-ubuntu$ sudo fdisk -l | grep /dev/sd Disque /dev/sda : 64 GiB, 68719476736 octets, 134217728 secteurs /dev/sda1 2048 1050623 1048576 512M Système EFI /dev/sda2 1050624 134215679 133165056 63,5G Système de fichiers Linux Disque /dev/sdb : 2,73 TiB, 3000592982016 octets, 5860533168 secteurs /dev/sdb1 2048 4982527 4980480 2,4G RAID Linux /dev/sdb2 4982528 9176831 4194304 2G RAID Linux /dev/sdb5 9453280 1953318239 1943864960 926,9G RAID Linux /dev/sdb6 1953334336 3906806143 1953471808 931,5G RAID Linux /dev/sdb7 3906822240 5860326207 1953503968 931,5G RAID Linux Disque /dev/sdc : 3,64 TiB, 4000787030016 octets, 7814037168 secteurs /dev/sdc1 2048 4982527 4980480 2,4G RAID Linux /dev/sdc2 4982528 9176831 4194304 2G RAID Linux /dev/sdc5 9453280 1953318239 1943864960 926,9G RAID Linux /dev/sdc6 1953334336 3906806143 1953471808 931,5G RAID Linux /dev/sdc7 3906822240 5860326207 1953503968 931,5G RAID Linux Disque /dev/sdd : 2,73 TiB, 3000592982016 octets, 5860533168 secteurs /dev/sdd1 2048 4982527 4980480 2,4G RAID Linux /dev/sdd2 4982528 9176831 4194304 2G RAID Linux /dev/sdd5 9453280 1953318239 1943864960 926,9G RAID Linux /dev/sdd6 1953334336 3906806143 1953471808 931,5G RAID Linux /dev/sdd7 3906822240 5860326207 1953503968 931,5G RAID Linux Disque /dev/sde : 1,82 TiB, 2000398934016 octets, 3907029168 secteurs /dev/sde1 2048 4982527 4980480 2,4G fd RAID Linux autodetected /dev/sde2 4982528 9176831 4194304 2G fd RAID Linux autodetected /dev/sde3 9437184 3907015007 3897577824 1,8T f Étendue W95 (LBA) /dev/sde5 9453280 1953318239 1943864960 926,9G fd RAID Linux autodetected /dev/sde6 1953334336 3906806143 1953471808 931,5G fd RAID Linux autodetected Disque /dev/sdf : 1,82 TiB, 2000397852160 octets, 3907027055 secteurs /dev/sdf1 2048 4982527 4980480 2,4G fd RAID Linux autodetected /dev/sdf2 4982528 9176831 4194304 2G fd RAID Linux autodetected /dev/sdf3 9437184 3907015007 3897577824 1,8T f Étendue W95 (LBA) /dev/sdf5 9453280 1953318239 1943864960 926,9G fd RAID Linux autodetected /dev/sdf6 1953334336 3906806143 1953471808 931,5G fd RAID Linux autodetected Disque /dev/sdg : 1,82 TiB, 2000398934016 octets, 3907029168 secteurs /dev/sdg1 2048 4982527 4980480 2,4G fd RAID Linux autodetected /dev/sdg2 4982528 9176831 4194304 2G fd RAID Linux autodetected /dev/sdg3 9437184 3907015007 3897577824 1,8T f Étendue W95 (LBA) /dev/sdg5 9453280 1953318239 1943864960 926,9G fd RAID Linux autodetected /dev/sdg6 1953334336 3906806143 1953471808 931,5G fd RAID Linux autodetected Disque /dev/sdh : 1,82 TiB, 2000398934016 octets, 3907029168 secteurs /dev/sdh1 2048 4982527 4980480 2,4G fd RAID Linux autodetected /dev/sdh2 4982528 9176831 4194304 2G fd RAID Linux autodetected /dev/sdh3 9437184 3907015007 3897577824 1,8T f Étendue W95 (LBA) /dev/sdh5 9453280 1953318239 1943864960 926,9G fd RAID Linux autodetected /dev/sdh6 1953334336 3906806143 1953471808 931,5G fd RAID Linux autodetectedadmin@VM-ubuntu$ cat /proc/mdstat Personalities : [raid6] [raid5] [raid4] md3 : active raid6 sdf6[8] sdd6[1] sdb6[0] sde6[3] sdg6[6] sdh6[7] 5860409088 blocks super 1.2 level 6, 64k chunk, algorithm 2 [8/6] [UUUUUU__] md2 : active raid6 sdb5[0] sdf5[7] sdd5[1] sdg5[8] sde5[3] sdh5[10] 5831588736 blocks super 1.2 level 6, 64k chunk, algorithm 2 [8/6] [UUUUUU__] md4 : active raid6 sdb7[0] sdd7[1] 1953501824 blocks super 1.2 level 6, 64k chunk, algorithm 2 [4/2] [UU__]admin@VM-ubuntu$ sudo lvs WARNING: PV /dev/md2 in VG vg1 is using an old PV header, modify the VG to update. WARNING: PV /dev/md3 in VG vg1 is using an old PV header, modify the VG to update. WARNING: PV /dev/md4 in VG vg1 is using an old PV header, modify the VG to update. LV VG Attr LSize Pool Origin Data% Meta% Move Log Cpy%Sync Convert syno_vg_reserved_area vg1 -wi-a----- 12,00m volume_1 vg1 -wi-a----- <12,71tDoes it help ? I am not sure to really fully understand thoses outputs

-

I have been running a Volume1 SHR-2 (with 2 disks protection) under DSM 6.x on proxmox for years without too many problem...

For the last few months I was not more able to update to DSM 6.X updates, the pat file was retunring as corrupted each time I was trying (I did not investigate furthermore...)

More recently 2 out of my 8 disks started to show bad health, but I had no time to deal with that. Then one day, after a reboot, my DSM 6.2.??? showed up with 'Configuration lost' !Rather than trying to repair this old version, I took advantage to migrate to 7.1 with TCRP

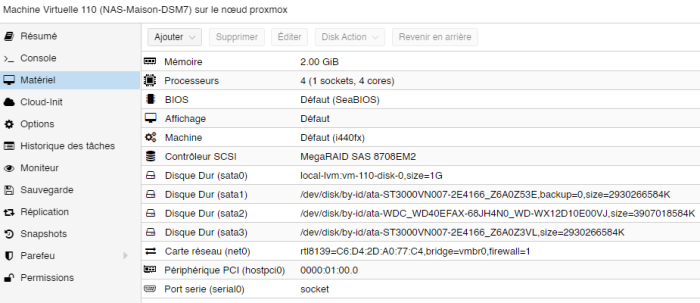

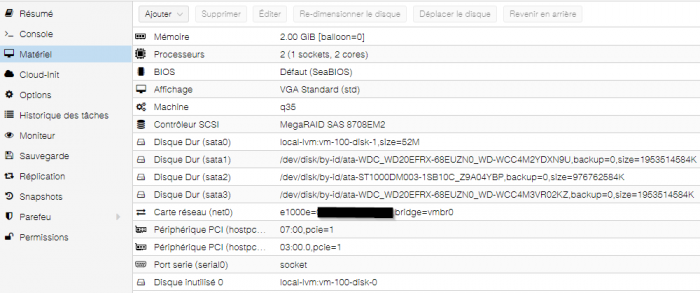

TCRP did not recognized my 2nd passthrouh SATA controller so I rearranged the disks in order to use only one controller card, the 4 others disks being held by the onboard controller (4 passtrough motherboard disks + 1 passtrough 4 slots Marvell SATA controller with 4 disks). One out of my two 4Tb WD red HDD was having massives I/O errors I have sent it back under warranty).

After different tried, I had to change to DS3622xs+ to make it run. I

configured user_config.json with SataPortMap=44 and DiskIdxMap=0004

This is what I get with :

Proxmox disks (those are those of the controller card, the 4 others are not seen because in passthrough under the running Xpenology VM) :

VM configuration :

All the disks are recognized (except the one gone under warranty) and I thought naively that thanks to SHR-2 DSM will be able to rearrange the Volume.

I am really not an IT expert, specially when it comes about partitionning, LVM, disk management ...

My wife has many sensible datas on that volume and I have been very busy these last few months so I haven't been very serious about backups (I know

!... )

!... )

She will probably ask divorce if I do not manage to recover thoses files 🤔!Any help in order to recover my data (and my mariage 😀) would be much much appreciated.

Thanks in advance.

-

blessendor method is perfect but another way would be to passthrough 2 PCIe sata controller cards with a bunch of 4 disks each ! (more expensive though)

-

Hi @stasheck

I finally managed to install Xpenology after having spent hours ! Even if everything is working now, I would not be able to tell you exactly what I really did well to make it work !!! (given that I discovered I had a faulty motherboard/bios not really able to deal with DSMAR table and so I had to use the unsafe_interrupt method within proxmox, and I am not able to tell how it might have affected my xpenology installation...)

I hope you will get some more precise help form experts, but I can provide some partial outputs :

1/ I never managed to install 918+ nor loader 1.04, I was getting a fatal error during installation (I do not remember precisely error details)

2/ ds3617 xs was working with 6.2.1 but I was unable to update to 24922.pat or higher, it was also crashing

3/ I so use ds3615xs with 1.03b. I firstly installed 6.2.1 then update to 6.2.2 (I kept 1.03b)

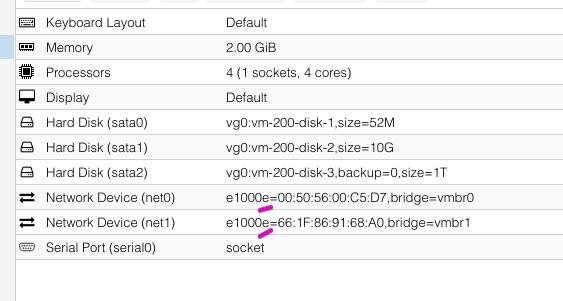

4/ Yes I use e1000e nic drivers, implemented following the @blessendor method

5/ I did not managed neither to use virtual USB key for loading, I had to use sata disk. And the boot disk does appear in HDD manager but normally I depends of your choice in the loader boot menu (baremetal or VMware options)

6/ I firstly managed to get xpenology working and updated before any device passthrough

I was finally able to passthrough 1 PCIe sata controleur card with 5 sata disks and USB + 3 other sata disks directly

I hope this partial feedback will give you some clues. And do not give up, it should finally work fine also

!

!

... even if I am quite anxious about the moment the next update will show up !!!

Good luck

-

1

1

-

-

- Outcome of the update: SUCCESSFUL

- DSM version prior update: DSM 6.2.23739

- DSM version after update: DSM 6.2.2-24922-update 3

- Loader version and model: JUN'S LOADER v1.03b

- Using custom extra.lzma: NO

- Installation type: VM Proxmox 6.0.7 running on Asus P6T Deluxe / 24 Go Ram / CPU Intel core I7 990X

- Additional comment: Achieving to GUI select e1000e network card led to success after many kernel panic !

On 8/1/2019 at 7:46 PM, blessendor said:After successful testing of the @hellbondz's method, I found that my second network interface in the DSM is inaccessible from my LAN (I use multi-homed network).

This was happened because:

Without this script PVE will add both netdev into default bridge - vmbr0 (a public bridge in my case).

I patched two PVE scripts to be able add network interface with Proxmox GUI and staying out from edit config manually (what somebody can't do it correctly).

So my method of using Network Driver Intel e1000e with Proxmox, which required to be able upgrade to the the latest DSM version (current up to DSM 6.2.2-24922 Update 2) and keep network worked:

1) Make DSM VM backup as usual!

2) Make PVE scripts backup:

cp /usr/share/perl5/PVE/QemuServer.pm /usr/share/perl5/PVE/QemuServer.pm.default

cp /usr/share/pve-manager/js/pvemanagerlib.js /usr/share/pve-manager/js/pvemanagerlib.js.default3.1) Open /usr/share/perl5/PVE/QemuServer.pm

find needed block with keyword 'e1000 (or 'vmxnet3' - less results than for '1000')

replace:

my $nic_model_list = ['rtl8139', 'ne2k_pci', 'e1000', 'pcnet', 'virtio', 'ne2k_isa', 'i82551', 'i82557b', 'i82559er', 'vmxnet3', 'e1000-82540em', 'e1000-82544gc', 'e1000-82545em'];

to (add 'e1000e'):

my $nic_model_list = ['rtl8139', 'ne2k_pci', 'e1000', 'e1000e', 'pcnet', 'virtio', 'ne2k_isa', 'i82551', 'i82557b', 'i82559er', 'vmxnet3', 'e1000-82540em', 'e1000-82544gc', 'e1000-82545em'];

3.2) Open/find/replace /usr/share/pve-manager/js/pvemanagerlib.js

if ((match_res = p.match(/^(ne2k_pci|e1000|e1000-82540em|e1000-82544gc|e1000-82545em|vmxnet3|rtl8139|pcnet|virtio|ne2k_isa|i82551|i82557b|i82559er)(=([0-9a-f]{2}(:[0-9a-f]{2}){5}))?$/i)) !== null) { res.model = match_res[1].toLowerCase();

to:

if ((match_res = p.match(/^(ne2k_pci|e1000|e1000e|e1000-82540em|e1000-82544gc|e1000-82545em|vmxnet3|rtl8139|pcnet|virtio|ne2k_isa|i82551|i82557b|i82559er)(=([0-9a-f]{2}(:[0-9a-f]{2}){5}))?$/i)) !== null) { res.model = match_res[1].toLowerCase();

next replace block:

Ext.define('PVE.form.NetworkCardSelector', { extend: 'Proxmox.form.KVComboBox', alias: 'widget.pveNetworkCardSelector', comboItems: [ ['e1000', 'Intel E1000'], ['virtio', 'VirtIO (' + gettext('paravirtualized') + ')'], ['rtl8139', 'Realtek RTL8139'], ['vmxnet3', 'VMware vmxnet3'] ] });

to:

Ext.define('PVE.form.NetworkCardSelector', { extend: 'Proxmox.form.KVComboBox', alias: 'widget.pveNetworkCardSelector', comboItems: [ ['e1000', 'Intel E1000'], ['e1000e', 'Intel e1000e'], ['virtio', 'VirtIO (' + gettext('paravirtualized') + ')'], ['rtl8139', 'Realtek RTL8139'], ['vmxnet3', 'VMware vmxnet3'] ] });

4) Run 'service pveproxy restart' and reload PVE admin interface - you will be able to change the Network driver of your DSM VM from e1000 to e1000e.

5) Save copies of edited scripts to somewhere else to be able restore/compare scripts versions after Proxmox upgrades.

Again - make backups before run any test from my tutorial.

Good luck

I have spent almost 2 weeks to try to get Synology last update to work with proxmox 6.0.7. Hours and hours trying thousands of different options ! Until I found this post (to be honest, I tried it a week ago, without success, maybe I did it wrong!!??) Then it finally happened ... Xpenology using 6.2.2-24922 (last update as of 09/11 !!!). I would never thank enough @blessendor for the hack he published in order to use Intel e1000e network card within Proxmox. I first tried everything with the '-arg:' command line in vmid.conf to define e1000e as default network card, including great @hellbondz 's trick, but it never really worked out for me. Hacking the QemuServer.pm/pvemanagerlib.js files allowed me to select e1000e in the Proxmox GUI and then my virtual DS3617xs finally accepted last update without crashing ! I could not believe it !

... Now I have to succeed in passing through my 2 sata controller cards and my 8 hdd disks - which is another story!

Thanks again @blessendor for your sharing, you saved my last few weeks, and also for all the people using or developing Xpenology, and specially for @jun the master !

-

Pas de souci pour moi non plus avec l'update 3 si ce n'est le firewall qui m'empêchait d'accéder aux lecteurs mappés depuis Windows 10 (serveur de fichier Windows). Mais cet n'était finalement peut-y été pas directement lié à l'update ???

Rien de méchant en tous cas, très vite résolu. Le reste est ok.

Envoyé de mon SM-N910F en utilisant Tapatalk

A l'aide ! Volume en lecture seule

in Autre

Posted

ok merci beaucoup