WowaDriver

Member-

Posts

42 -

Joined

-

Last visited

Everything posted by WowaDriver

-

Hallo Leute, Habe seit 1,5 Jahren meine VM mit Win10 am laufen. Am Wochenende habe ich dann der VM selbst, welche eine eigene SSD hat von 120GB Brutto 107GB Netto Kapazität das zugewiesene Volume von 60GB auf 92GB (maximum was ging) erhöht. Seit dem startet die VM nicht mehr und spuckt die Fehlermeldung aus (siehe Screen). Die Platte verkleinern geht nicht mehr, musste man ja auch mit eine Bestätigung akzeptieren. Habt ihr einen Rat für mich?

-

Beratung Hardware Ressourcen Aufteilung Xpenology unter ESXI

WowaDriver replied to WowaDriver's topic in GERMAN

Danke für euren Antworten und Vorschläge. Hab lange hin und her überlegt. Habe jetzt für kleines Geld 16gb Ram ergattert und werde mal vorerst auf dem bestehenden System ESXI aufsetzen bin den oben genannten VM's und virtuallisiere zu Testzwecken den angesprochen Gaming Rechner ebenfalls. Ob es und wie zuverlässig laufen wird schaue ich mal. Bin bis vorgestern davon ausgegangen, dass man auf einem 6700K kein ESXI zum laufen bekommt und der GPU Passtrough für das Gaming ebenfalls eine Hürde wird... Aber für alles gibt es mittlerweile Lösungen habe einige TUT gefunden. Interessant wird es nur mit der PCIe 3.0 voll Besetzung. Da eine 980 TI fürs Gaming rein soll, in den zweiten SLOT eine 1060 GTX 6 GB für das Transcoden und in den dritten SLOT der 9211-8i IT mit den Patten muss. Würde heißen das diese laut Board Buch nur mit 8x, 4x 4x laufen würden, da die CPU maximal nur 16 Lanes kann. Vom RAM her mit 32 GB denke ich würd es mir reichen, gut ist kein ECC aber hat mich bis dato auch nicht gestört, bzw. hatte ich keinen Fall wo ich gesagt habe ich hätte es gebraucht. Was mir bis vorgestern auch nicht klar war, ist dass man die Cores auch mehrfach zu ordnen kann. Sprich meine o.g. CPU hat ja 4x echte Cores und 4 Threads. Somit nahm ich an, dass wenn ich 4 der einem VM zuweise ich für den Rest eben nur noch die 4 Threads habe... mir wurde jetzt gesagt, dass man durch aus einen Kern 2-3 mal vergeben kann, weil diese ja nicht immer zu 100% unter Last sind... Hättest du da mal nähere Infos zu? Bei mir hat das wegen SSS überhaupt nicht klappen wollen. -

Beratung Hardware Ressourcen Aufteilung Xpenology unter ESXI

WowaDriver replied to WowaDriver's topic in GERMAN

Ja genau, mit der in den beiden Links geposteten Anleitung hebelt man eben genau diese Limitierung für Consumer karten auf. Sehr gute Neuigkeiten. Würde es auch keine Probleme beim Migrieren geben? Will wohl nämlich auch von der 918+ auf die 3615xs wechseln. Wenn ich mich gestern richtig eingelesen habe soll es da wohl auch mit dem Spindown des RAID 5 klappen... können diese beiden Punkte bestätigt werden? Danke für den Hinweis, das war mit aber bewusst. Mir ging es bei der Frage eher darum was ihr konkrekt als Hardware Empfehlung aussprechen würden. Ich neige zu dem Problem immer den V8 kaufen zu wollen obwohl ich mit einem Polo 3 Zylinder auch auskommen würde für meine Anwendungsfälle. Möchte die Stromkosten reduzieren und die Ressourcen besser nutzen. Aber ja Puffer nach oben sollte es auch noch geben, da ggf. mal für die Frau auf der ESXI Plattform mal auch eine VM aufgesetzt werden könnte. Erneut vielen Dank für das Lesen und drüber nachdenken der Probleme eines anderen! -

Hallo Leute, nochmals vielen Dank an alle Beteiligten für die großartigen Möglichkeiten und die Unterstützung! Nach etwas mehr als einem Jahr nutzen meines produktiv Systems habe ich einiges dazu gelernt und erfahren was ich hätte eventuell anders machen sollen. Mein derzeitiges System: I7-7700K 16 GB DDR4 Ram Dell 310 HBA auf 9211-8i IT P20 Mode geflasht 5x 6TB Storrage als RADI 5 inkl. SMART Werte Meine Anwendungen und Ziele an meinen HomeServer: Storage und Backup RAID 5 emby Server -> mit großem Wunsch auf Hardwaretranscoding, 12 Clients und teils streaming auf iPads und Multimiedia im Auto von HD+4k Material Docker Containter: guacamole für den Remotezugriff auf Heimrechner und VM's über den Brwoser von überall aus und jedem Gerät ioBroker Zentrale inkl. Backup portainer Survaillance Station von meinem Kameras -> wodurch ich wohl mit keiner Version (derzeit 918+) die Disks in Ruhuzustand bekomme, weil entweder alle oder keine... oder ist es möglich eine eigenes Speicherpool also auch in Hardware für die Kamers laufen zu lassen und das RAID 5 s.o. in den Sleep zu bringen? Habe auch schon über USB Storage nachgedacht wo man dann SSS drauf packen könnte... VM's: Derzeit ein Windows 10 Client (siehe 3.1) und ein paar virtuelle Raspberry PI's mit diversen Smart Home Images Wenn jetzt nicht gerade 2-3 Clients bei emby mittels Software oder HW Transcoding, was auch nur über die Grakka der CPU geht, laufen ist die Hardware nahezu auf dem Minimum unterwegs. ich würde gerne die VM's mit Grakka Unterstüzung nutzen, was leider nicht möglich ist. Genauso wenig wie eine Grakka für emby zum HW Transcoding zuzuweisen... Auf der Suche nach Alternativen bin ich dann auf folgende zwei Threads gestoßen: https://emby.media/community/index.php?/topic/84485-will-adding-a-gpu-benefit-me/ https://www.elpamsoft.com/?p=Plex-Hardware-Transcoding Mein Gedanke ist jetzt folgender. Ich benutze die aktuelle Server Baremetall Hardware als Hauptrechner und packe da eine noch verfügbare 980 TI rein und habe dann einen Rechner mit dem man auch mal zocken könnte. Nicht das Highend vom Highend aber ausreichend. Diesen möchte ich ebenfalls über die in Punkt 3.1 genannte Möglichkeit von außen erreichbar machen und benötige dann in xpenology die VM dafür nicht mehr. Für die Server hardware muss was komplett neues her. Wobei hier die Ressourcenaufteilung besser stattfinden muss. Somit käme ein ESXI Unterbau ins Spiel. Was haltet ihr davon wenn ich eine VM mit Linux aufsetze mit der ich rein den emby Server betreibe und eine 1060 GTX mit 6GB mittels passtrough durchreiche und somit mit den passenden Treiber 20 Streams HW transcodieren könnte. Für Xpenology würde eine zweie VM aufgesetzt werden. Hier ist oberstes Gebot, dass ich den DELL HBA 310 als 9211-8i IT durchreichen kann um zum einen alle SMART Werte lesen zu können und noch viel wichtige mein bestehendes RAID 5 migrieren also weiterverwenden kann. Meines Wissens nach müsste das gehen oder? Hier würden dann komplett die Punkte 1,3 und 4 laufen wie bisher, es sei denn man kriegt irgendwie das ganze mit der Sleep Funktion des Raid 5 hin. Wenn die oben genannten Möglichkeiten für SSS mittels seperaten Speicherpools oder USB Laufwerk gehen gut, wenn nicht kann man überlegen ob man nicht für SSS ein seperates xpenology auf eine 3. VM aufsetzt und auf einer seperaten Platte laufen lässt. Ein großen Vorteil vom ESXI Unterbau sehe ich, dass man für die sepraten Anwendungen jeweils eine eigene Netzwerkkarte betreiben könnte, oder? Nun zum Schluss die qual der Wahl, ich brauch keine super Highend Hardware. Zumal ich die Produktive Win10 VM jetzt ja auslagere. Vielmehr geht es jetzt in die Richtung Ressourcenausnutzung und Stromsparen. Welchen Hardware würdet ihr mir empgehlen, gerne auf was, was man gebraucht gut bekommt aber eben auch stromsparen ist. Gut bisshen Puffer nach oben wäre auch nciht schlecht. Vielleicht kommt ja mal das ein oder andere noch dazu... Vielen Dank mal wieder für das Lesen und drüber nachdenken der Probleme eines anderen!

-

Hallo @IG-88 vielen Dnak für deine sehr ausführliche Antwort. An sich hat du ja Recht. Hauptaugenmerk soll dabei auf produktives flüssiges Arbeiten mit CAD und Office Anwendungen bzw. Anwendungen sein bei denen es auf FPS usw nicht ankommt. Das mit dem gaming war ein netter neben Gedanke, da ja eh schon eine Grakka drin ist. Somal für die lange weile auf der Arbeit ... Battlefield und CS:GO bzw. ESL kann ich damit vergessen... Der zweite wesentliche Punkt wäre dann halt lohnt sich das ganze seprat auf eine Baremetall Maschine aufzusetzen oder reichen eurer Meinung die Kapazitäten der vorhanden Hardware aus um das zu virtualisieren parallel zu einer xpenology Maschine... Auch hier hast du sicherlich recht. Geplant war sowieso erstmal nur eine Karte zu verwenden. Der Gedanke bei LINK AGG war eher der das es Karten gibt die halt 2x SFP+ Ports haben und da am Switch Ports frei sind, why not... außerdem ob 10 Gibit oder 1Gbit Anfragen werden doch nicht parallel sondern eben nach einander abgearbeitet oder? Sprich dann ist eine zweit Anbindung doch in jedemfall sinnvoll, richtig? Wenn es eine Single Card wird dann habe ich an die Mellanox ConnectX-3 gedacht... ist preislich auch nciht zu teuer... oder lieber iene Intel NIC diese liegen aber beist bei doppelten Preis... Da kommen wir zum interessanten Punkt... Habe jetzt gelesen, und auch reproduzieren können, dass entweder alle HDD's in den SPin Down fahren oder eben keine. Externe Platten können seperat konfiguriert werden. SSS auf eine External Drive ist aber glaube ich nicht möglich oder? Will es auf jedenfall mal testen... was meinst du mit extra ssd's? Verhalten sich diese nicht 1 zu 1 wie eine interne Platte? Sprich gilt hier doch wieder entweder alle oder keine... SSS, VMM und Docker sind ja die bekannten Pakete die eine Spindown verhindern... wie aber kann ich diese Pakete auslagern ohne das deren Installations Daten auf jede Systempartition eine jeden physikalsichen internen HDD installiert werden, dass ist ja wie ich verstanden habe der Standard bei der DSM... Bei mir ist derzeit alles noch in 1080p an Endgeräten vorhanden. Ich stelle den Content aber allmählich auf 2160p um, da in Zukunft eben 4k Beamer und TV's kommen werden. Sharen ins Netz ist primär nicht vorgesehen ,jedoch gibt es schon einmal den ein oder anderen Anwendungsfall wo der nachbar mal einen Film streamen will... VMM würde hier für Windows auf der DSM ausgedient haben da würde nur ein Raspberry Image laufen für die Smart Home Geschichten und eben Docker wegen ioBroker, wobei dieser im Falle von ESXI ebenfall ausgelagert werden kann. In Summe möcht eich eigentlich minimalen Stromverbrauch bei maximaler Leistung... passt an und für sich nicht zusammen aber das gesunde Mittelmaß eben. Im Tutorial Thread hier im Forum sind ja einige Beispiel Configs von Usern genannt, welche so ziemlich alles zum laufen bekommen haben... nur die Frage ist ob es Stand heute lohnt die gleiche hrdware erneut zusamme nzu bauen, sollte man bei meinem zweiten Vorschlag die Maschinen trennen... zum Beispiel auf Page 8: Jun 1.04b loader for 918+ Pentium G4620 welcher ja mit 51W TDP beinahe die Hälfte schluckt als meine derzeitige CPU... die Frage ist nur welcher ist sparmaser im idle bzw standby und wieviel Kapazität wird benötigt und unter diesen Bedingungen welcher ist Sparsammer? Eben ganz nach dem Motto, wenn ich nur 100km/h dauerhaft fahre wozu benötige ich ein V8 mit 4,2L hubraum wenn ich auch mit einem 1,6L 4 Zylinder sprsammer bei gleicher Leistung bin...

-

Hallo Leute, erstmal möchte ich mich hier für die große Arbeit Community bedanken die es möglich machen, das zu nutzen was wir hier alle eben nutzen ;). Ich habe nun seit 1 Jahr ein Xpenology System als 918+ mit dem 1.04b Loader erfolgreich im Betrieb auf folgender Hardware: i7 6700k 16gb DDR4 4x4tb Raid 5 2x 120gb SSD Genutzt wird dabei: Festplattenverbund mit 310 HBA IT im Raid 5 Photostation Videostation SSS mit 7 Cams VMM mit Windows 10 als produktiv Umgebung und zwei weiteren Raspy VM's fürs Smart Home Docker mit iOBroker Jdownloader Mein Problem was ich habe ist, dass der VMM für die Windows VM einfach zu lahm ist. Ich will das jetzt entweder splitten sprich das System beibehalten und ESXI davor schieben sodass Windows eine VM bekommt mit PCI Passtrough und Xpenology eben auch. Ist die genutzte Hardware stark genug für dieses Vorhaben? Mit dem Windows VM soll dann auch ohne zu mucken CAD laufen und ggf. mal ab und an gezockt werden. Deshalb muss da ne Graka rein... ODER: Ich das bestehende System als Barmetal Installation für eine Windows Workstation für sich nutze und für Xpenology eine leistungssparsame Hardware Konstellation einsetze. Hauptziele sind dann: -Hardware transcoding (habe gelesen das geht nur mit originaler SN und MAC) oder gibt es da workarounds? -Festplatten Hibernation bzw. Spin Down wenn kein Zugriff erfolgt damit möglichst im Standby wenig Strom gezogen wird. Dabei wird für SSS eine extra Platte eingerichtet undabhängig von RAID 5. Oder funktioniert das nur für alle Platten oder eben keine? - Alle bisher genutzten Plugins weiter zu nutzen außer halt das virtuelle Windows im VMM der DSM, und dabei die Kiste wie gesagt stromsparend 24/7 fahren aber auch nicht am Leistungsmaximum. - Einsatz von 10Gbit wenn möglich diese auch doppelt für Link Agg. habe am Switch 4x 10 Gbit Ports Für die WIndwos VM auch wenn diese Baremetall eingesetzt wird müsste ja auch Gigabit reichen oder? Wird ja nur das Bild gestreamt... Sofern ihr der Meinung seit, so wie ich langsam jedenfalls je mehr ich darüber nachdenke und lese, dass Variante zwei zu wählen ist... Wäre ich sehr für Hardware Vorschlage dankbar und einen Verweis auf Installationshinweise... Gruß

-

SurveillanceStation-x86_64-8.2.2-5766

WowaDriver replied to montagnic's topic in Програмное обеспечение

Привет, кто-нибудь использует livecam со Surveillance Station? Можно ли запустить его пока экран заблокирован или используется другая программа? -

H310 IT Mode + 3x6TB Red + 1.04l DS918+ Speicherpool Absturz

WowaDriver replied to WowaDriver's topic in GERMAN

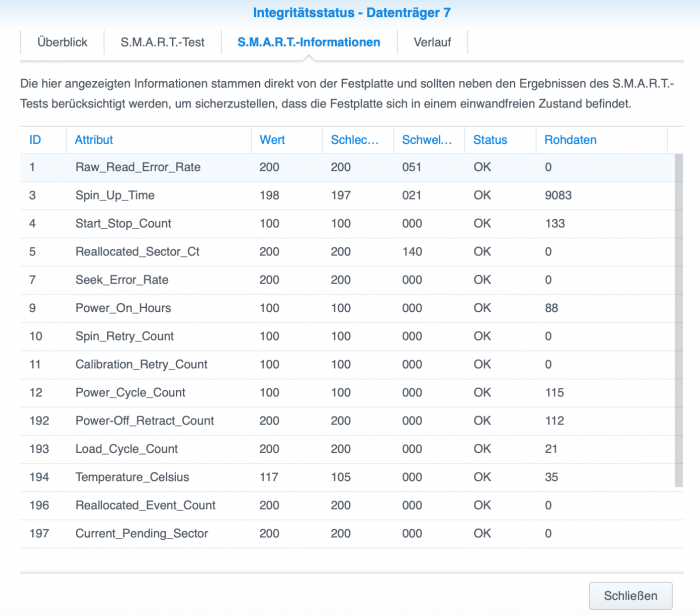

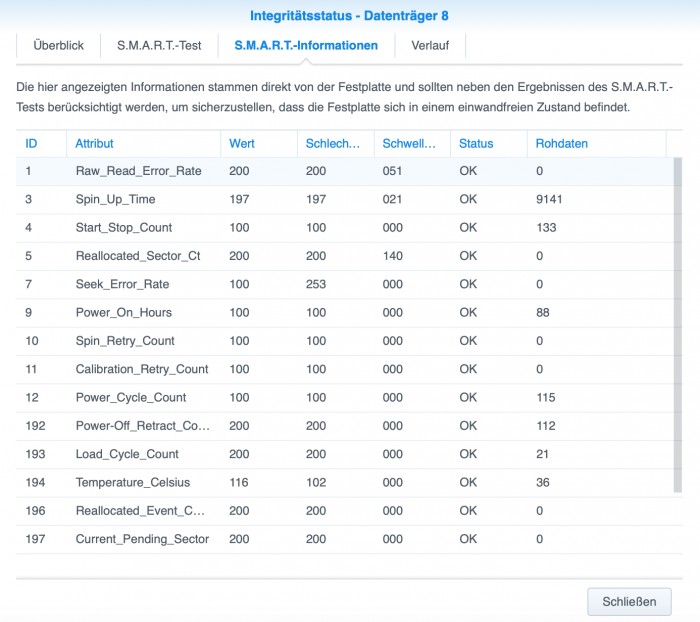

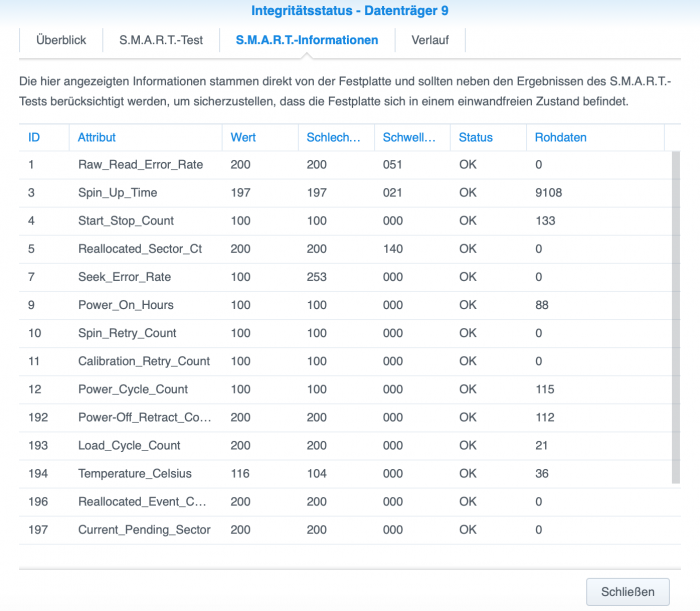

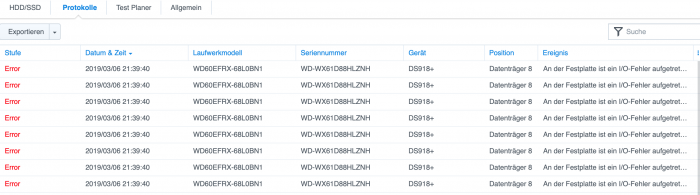

Habe gestern abend das Problem mit dem Speicherpool lösen können. Es liegt am Spindown der Platten. Habe es reprozuieren können, wenn ich 10 min einstelle und am DSM mich auslogge ist jedesmal beim wieder einloggen der Speicherpool mit der Festplatte 8 ausgefallen. Siehe angehängte Screens.. in den SMART Werten der Platte sieht man auch, dass diese schon ca 120 Stromabbrüche hatten... Habe das Abschalten der Platten nun deaktiviert und seit dem keine Probleme mehr... Im nachhinein habe ich so viel Zeit für die Felhersuche investiert und dabei benötige ich das Abschalten wahrscheinlich eh nicht, weil ich die Survailance Station aufzeichnen lassen möchte... und da eh entweder alle oder eben keine Platte abschaltbar ist ginge das doch sowieso nicht, richtig? Die Fragen zur Umstellung auf DS3615/17XS bestehen aber weiterhin... -> Da an sich erstmal alles läuft bei meiner Hardware würdet iht die DS918+ oder eine der DS3615/17XS empfehlen? Will das RAID später auf bis zu 8 Platten erweitern... -> Ich möchte außerdem ein zentrale WIN10 Arbeitsumgebung im VMM einrichten, das läuft auch soweit sogut. Wenn ich grafischhungirige Tools wie CAD Anwendungen einsetzen will würde hier doch auch eine seperate GPU nicht schaden oder? -

H310 IT Mode + 3x6TB Red + 1.04l DS918+ Speicherpool Absturz

WowaDriver replied to WowaDriver's topic in GERMAN

Danke für die Rückmeldung. Das Thema mit dem Shutdown hat sich erledigt. Das liegt ja komischerweise an der USB Platte sobald diese dran ist fährt die DSM wieder hoch nachdem Shutdown... keine Welche WakeonUSB Settings man da im Bios ausstellen kann. Als Board benutze ich ein noch rumliegen gehabtes z170 pro gaming von Asus mit einem i7 6700 inkl. 16gb ram da ich einiges vor habe parallel zu fahren unteranderem Virtualisierung von WIn10, ein paar Loxberrys, Überwachung mit 4-6 Cams und MediaServer.... Nachdem DSM heute den ganzen Tag lief, knappe 7 Stunden am Stück wo ich immer wieder drauf Zugriff hatte, habe ich mich vorhin auf der Arbeit von der Weboberfläche abgemeldet und bin Home gefahren. Daheim eben eingeloggt und festgestellt, dass der Speicherpool wieder abgestürzt ist.... auf bereits erwähnte weise repariert... aber das kann doch auf Dauer nicht sein. Sprich die P19 IT bringt mich bei dem Problem ebenfalls nicht weiter... Habe in einem anderen Forum gelesen das ein defekter Elko im Netzteil zum Absturz eines Speicherpools geführt haben soll... kann mir dies aber ehrlich gesagt nur schwer vorstellen. Ich fahre die Platten mittels der Energiesparfunktion nach 15 Min runter bei nicht Verwendung falls das für das Problem relevant sein kann... Wenn ich jetzt das RAID5 abklemme und auf DS3615XS oder DS3617XS umsteige, kann ich später das RAID5 wieder anklemmen und weiter nutzen? Oder muss dieses neu aufgebaut werden? Hatte zu Testzwecken überlegt, komplett eine andere Festplatte, inklusive anderem Stick eine DS3615/17XS aufzusetzen und danach das RAID5 abzuklemmen um zu schauen was passiert... Ratsam? Bevor ich mir das Produktivsystem zerschiesse... Gruß -

H310 IT Mode + 3x6TB Red + 1.04l DS918+ Speicherpool Absturz

WowaDriver replied to WowaDriver's topic in GERMAN

Habe gestern einiges selbst erfolgreich testen können: Die Prozedur muss komplett von vorne durchgeführt werden, die P19 IT über die P20 IT ging nicht. Bin nun auf P19 IT und mal sehen was die Langzeiterfahrung zeigt... Alles ohne Probleme durchführbar und danach wieder verwendbar. DSM bekommt von Neuflash des HBA's gar nichts mit... Habe ich erstmal sein gelassen, aus Angst das es das RAID zerstört und weil ich nicht zu viele Variablen verändern wollte. Schauen wir zu erst einmal ob die P19 das RAID 5 stabil am laufen hält... P.S.: Kann es sein das der Speicherpoolabsturz auch was mit einem fehlerhaften USB Laufwerk zu tun haben kann?? Ich hatte mir zur Sicherheit vor dem Flash ein Backup der wichtigsten DAten auf eine alte Externe gemacht. Die war schon die ganzen Tage angeschlossen mittel USB 3.0. Was mir zusätzlich zum Absturz des Speicherpools aufgefallen war, dass ich die Xpenology Kiste nicht mehr runterfahren konnte. Diese ging sofort wieder an, auch wenn ich diese Stromlos geschaltet habe. Gestern hatte ich dann vor dem Flashen die USB Platte entfernt und konnte danach "reproduzierend" die DSM mehrfach auschalten ohne das diese wieder anging. Nach Anstopseln der USB Platte, zack ging die DSM wieder an... jetzt meine Vermutung, kann es sein, dass die Externe auch ein Auslöser für den Absturz des Speicherpools ist? Der Absturz ist auch ein zwei mal passiert, als ich DAten von diesem auf der Externen gesichert habe... P.P.S.: Eine Reparatur des Speicherpools, wenn die zweite Meldung kommt, wie oben im Screens dargestellt, in ROT mit Gefahr, kann nicht durchgeführt werden. Starte ich die DSM neu ist nur noch eine "Achtung" Meldung in Orange da, welche besagt, dass der Zugriff der Systemparition der drei RAID5 Platten fehlgeschlagen ist. Diese kann ich ohne Probleme reparieren und dann sind alle Meldung weg, das NAS in Ordnung und das RAID 5 voll funktionsfähig... bin echt ratlos... Beste Grüße -

H310 IT Mode + 3x6TB Red + 1.04l DS918+ Speicherpool Absturz

WowaDriver replied to WowaDriver's topic in GERMAN

Danke für den Hinweis. Habe den Fehler diagnostizieren können. Der Fehler war, dass ich ich dachte der mit einem passiven Kühlkörper ausgestattete Raidcontroller wird bestimmt nicht warm und benötigt keine Zusatzkühlung... Bullshit! Der wird kochend heiß. Nachdem ich da einen kleinen Lüfter draufgesetzt hab ist alles durchgelaufen und das RAID 5 konnte erstellt werden. Jedoch hab ich nach 3-4 Tage Betrieb plötzlich immer wieder einen RAID Absturz. Bzw. er schreibt erst in oranger Warnmeldung die Systempartition sei abgestürzt und soll repariert werden. Diese kann ich reparieren und nach einem Reboot ist auch alles wieder im Lot nur weiß ich nicht so recht wie ich mit dieser Tatsache umzugehen habe. Ab und an so wie gerade eben ließ sich die Systempartition nicht reparieren und er schrieb daraufhin, dass das RAID abgestürzt ist und repariert werden soll. Dieses kann ich umgehen indem ich einen Neustart durchführe und die Systempartition anschließend repariere... Nehmen wir mal an @jensmander hat Recht und die P19 Firmware wäre besser, kann ich diese einfach über die P20 IT Firmware spielen, oder muss ich die ganze Prozedur von vorne starten...? Wie verhält es sich mit dem in DSM erstellten Software RAID 5? Ist diesen danach weiterhin verwendbar (Bei Neuflash des Dell H310 mit der P19 IT Firmware)? Oder mache ich mir hier zuviel Panik und der HBA ist wie der Name schon sagt wirklich mit der IT Firmware ein SATA Controller und reicht die Platten ein zu eins durch...? Derweil habe ich ja eine DS918+ Maschine konfiguriert... Wenn ich nun einen neuen Stick für eine DS3617xs erstelle und das DSM neu aufspiele, ist dann dann Software RAID weiterhin verfügbar? Ich kann es ja für die Installation abkoppeln (Denke an die DS3517xs weil diese Treiberfreundlicher sein soll und vielleicht besser mit dem 310 HBA Laufen) Vielen Dank für die Hilfe! -

Hallo Leute, bin noch ziemlich neu in der Materie, habe viel gelesen und gestern das System auch schon zum laufen gebracht. Aus Sicht der aufrüstbarkeit, Erhöhung der schreibgeschwindigkeit, einer paritätsplatte und einem großen speicherpool habe ich mich für ein RAID 5 System entschieden. So da Mein Mainboard nur ein paar sata Ports hat und der das RAID Ressourcen frisst habe ich mich für den DELL HBA H310 entschieden, welchen ich erfolgreich auf den P20 IT Mode geflasht hab. Daran ist vorerst das Minimum angeschlossen, 3x6TB WD Red. Anschließend wurde mit dem l1.04 Loader ein DS918+ auf die Beine gestellt und die die Platten würden auch sofort erkannt. Beim erstellen eines speicherpools musste ich feststellen, dass dies auf Grund der Größe ziemlich dauern kann. Bei 80-90% ist der Aufbau dann gescheitert. DSM wollte das neue RAID versuchen zu reparieren, wodurch der Speicher Manager nicht mehr reagiert hat. Nach vier Stunden war es mir dann zu viel, hab die Kiste neu gestartet weil nichts passierte und die Kiste in die Knie ging... Nach dem Neustart rennt DSM wieder gewohnt wie es soll, aber meine drei WD REds werden nicht mehr erkannt. An einem separaten PC getestet laufen die haben auch schon die typische DSM Partitionierung. Dann die Ernüchterung. Der H310 blinkt nicht mehr, sprich die heartbeath LED ist aus. Also wieder H310 Flash Stock fertig gemacht und mit sas2flash.efi -listall versucht den cobtroller zu finden... Puste Kuchen... findet nicht als ob nichts verbaut ist. Habt ihr einen Rat für mich? Gruß