Magnetic

Transition Member-

Posts

19 -

Joined

-

Last visited

Recent Profile Visitors

The recent visitors block is disabled and is not being shown to other users.

Magnetic's Achievements

Newbie (1/7)

0

Reputation

-

Скажите, загрузчик arpl-i18n исчез с гитхаба, всё, капут? Сейчас актуальный Arc? Просто подсунуть его с теми же параметрами sn\mac?

-

Обновления XPEnology DSM (успешные и не очень)

Magnetic replied to XerSonik's topic in Програмное обеспечение

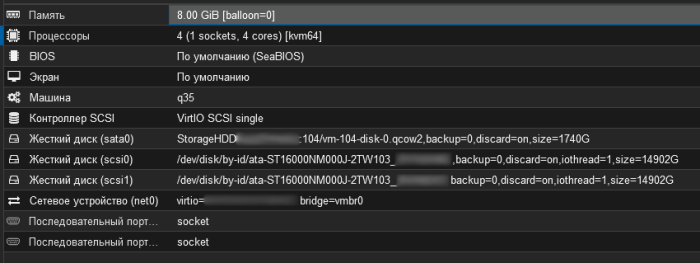

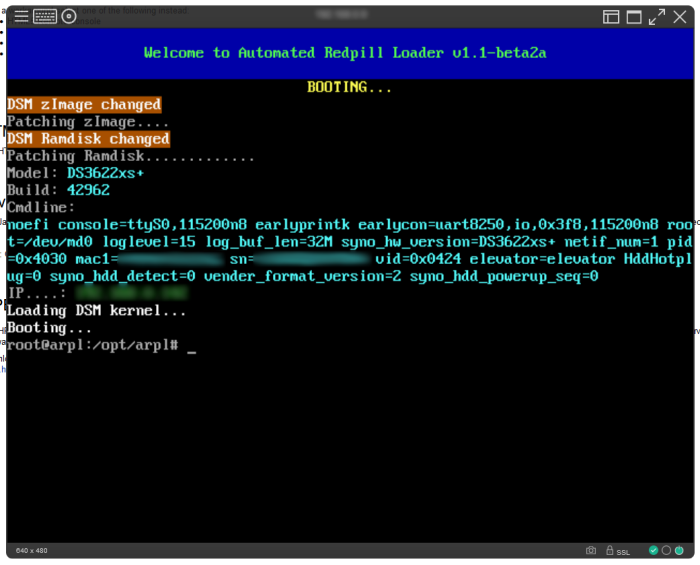

DS3622xs+: DSM 7.2-64570 - результат обновления: УСПЕШНЫЙ - версия DSM до обновления: DSM 7.1.1-42962 Update 5 - версия и модель загрузчика до обновления: arpl-v1.1-beta2a DS3622xs+ - версия и модель загрузчика после обновления: arpl-i18n-23.6.4 DS3622xs+ - железо: ProxMox 7.4-13 - комментарий: Обновление пакетом через веб-интерфейс, затем смена и сборка загрузчика. Было очень страшно но всё обошлось.- 218 replies

-

- dsm update

- ошибка обновления

-

(and 3 more)

Tagged with:

-

Доброе утро. Железо и корзина те же самые. Загрузчик на SD-карте, версия на скриншотах. Данный сервак использую в качестве бекапного для "боевой" Synology. Не включал сервак три недели, включил, прилетело обновление, обновил штатным способом. Почему вы используете загрузчик "arpl-1.0-beta9" данной версии, может проблемы из-за этого? Какую модель эмулируете? На сколько помню, самые беспроблемные DS3622xs+ и DS920+. Проверьте память мемтестом.

-

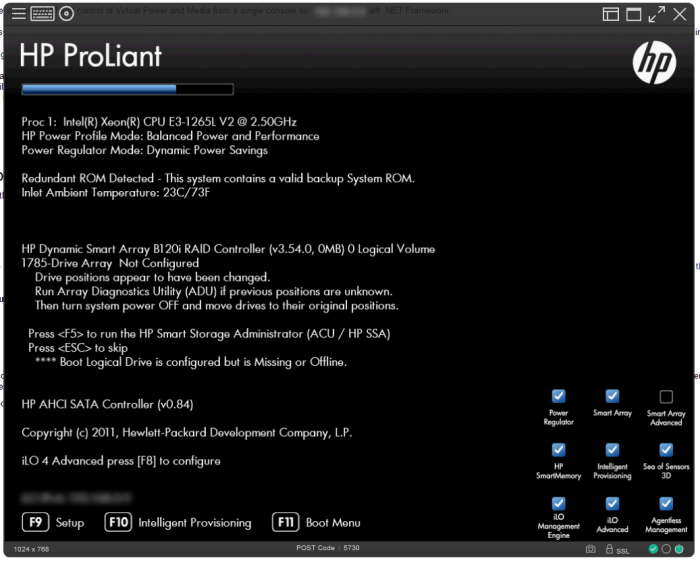

HP Microserver Gen8. CPU Xeon E3-1265L V2 Ivy Bridge RAM 16 gb HDD 4x4tb "Хрень" DSM 6.2.3-25426 Update 3 DS3615xs с валидной парой mac+serial Подскажите, чтобы перейти на 7.1.1, чтобы работал транскодинг, какое устройство эмулировать в загрузчике ARPL? DS3615xs? Оно вроде как может быть заброшено вскоре. 920+? Да, очень хотелось бы мигрировать а не с нуля 7.1.1.

-

Так же успешно обновился.

-

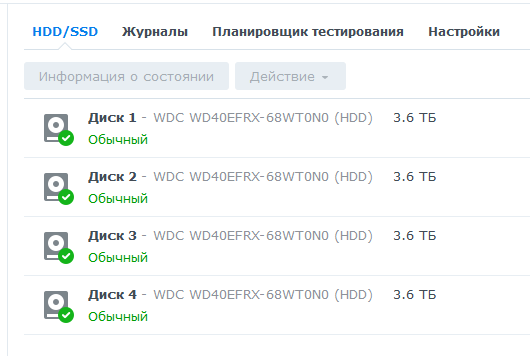

У меня 4 по 4tb. Точно знаю что возможно и по 8tb, где то читал что и 12tb работают.

-

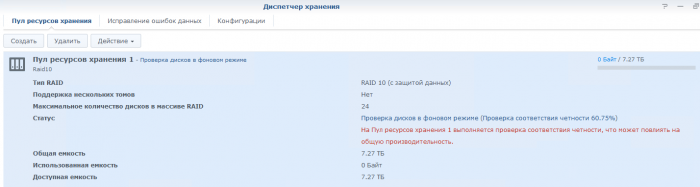

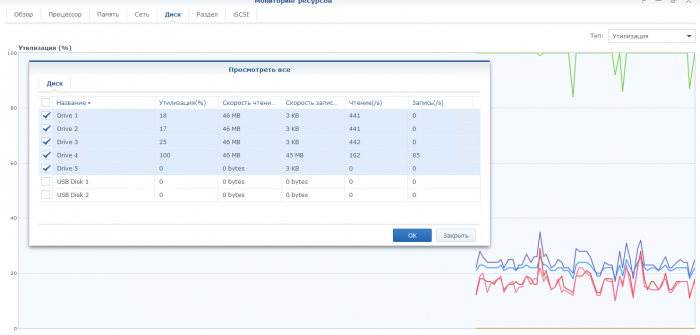

Заметил тут, 11 часов режется 10 рейд из 4х 4тб дисков, полез в мониторинг ресурсов, а там странность, 4 диск, который был заменён, утилизирован на 100% а другие нет. Сегодня утром переустановил Synology с нуля, устал ждать ребилд 10 рейда прошлой установки когда 4 диск обнаружил сбой. Почему такая разница? может с диском что не так?))) этот 4 диск отличается годом выпуска (2 года), он помоложе, и по часам наработал втрое меньше старых.

-

А на Nginx нужно проксипасить на 5000 или 5001 порт, если галку поставить? Наткнулся на такую инфу: народ рекомендовал делать проброс порт в порт именно этих: 80 - 80 443 - 443 5000 - 5000 5001 - 5001 Но это если 80 и 443 порт никем не занят, а тогда и сертификат можно получать на самой Synology. А в моём случае, с отдельным Nginx внутри сети на который уже проброшены 80 и 443 порты снаружи, на роутере нужно пробросить только 5000 и 5001 порт на внутренний ip-адрес Synology? Или если поставить галку то вообще только 5001? Я всё правильно понимаю?) Жгучая боязнь есть только профукать данные на дисках, старенькие они, 2014 года, 47 тысяч часов наработки. Потому бекапы.

-

Я проверял в мониторинге ресурсов, есть ли напруга на диски, нету. Так же смотрел и в File Station, рефрешил папочки в куда копировал, ничего нового не появлялось. Мне кажется что то я в настройках в это время ковырнул, оно и сбросилось, но это не точно)

-

Нет нет, с авторизацией конечно. Страшновато, т.к. сертификат получен не в самой Synology, а на отдельном Nginx внутри сети, который публикует в мир доступ к DSM по https, ведь сама Synology никак не знает что к ней извне ходят по https. Если это учесть, галка предложенная вами, не оборвёт мне доступ к вебморде Synology? И нужно ли в Nginx проксипасить на 5001 порт, а не как сейчас у меня на 5000, или в моём случае это не принципиально?

-

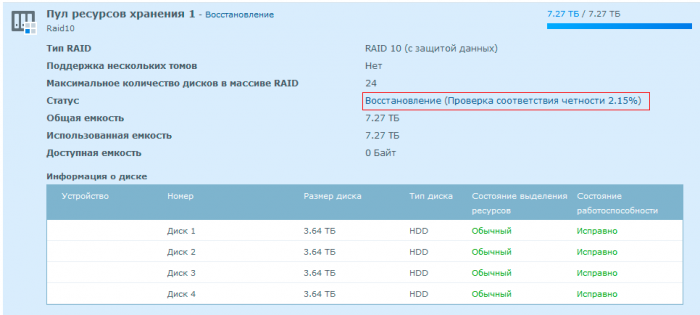

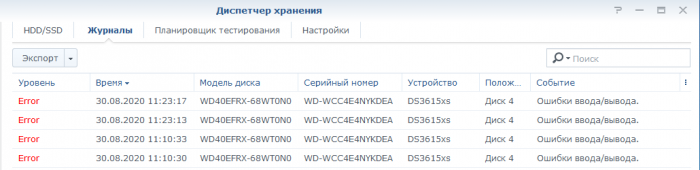

Диск заменил, вытащил из сервака с ProxMox, диск был в составе Raid1 исключительно для бекапов виртуалок. Synology диск принял, поругался, предложил восстановление массива, не стал возражать. Процесс восстановления очень удивил временем на восстановление, прошло уже пару часов, а процентики капают еле еле: Для такого объёма диска это нормально? А ещё заметил пару раз непоняточку, при копировании с внешнего диска внутри Synology, процесс копирования, который прятался в "Задача в фоновом режиме", спустя какое то время просто исчезал, как будто и небыло никакого копирования. Зайдя в копируемое место и сравнивая с источником, скопировалась треть. А главное Synology ничего и не сказала что процесс был чем-то и почему-то прерван, странно. Но грешу, возможно, на какие то свои действия настраивая Synology, пока шёл процесс копирования. Или такое случается и это норм?

-

Ого какой заковыристый способ. Мне удалось методом тыка создать пользуна, ограниченного только на использование Video Station и только на чтение, в правилах доступа к приложению включил галку "включить пользовательский псевдоним" например "vs", итого получил ссылку "https://внутренний_ip/vs". Т.к. есть внутри сети Nginx, дополнительно ничего настраивать не пришлось, по внешней ссылке https://example.ru/vs попадаю на страницу авторизации, где захожу под ограниченным пользователем и сразу попадаю в Video Station и вижу все кИны. Нашёл досадный глюк в Video Station в любом браузере, если навести курсор на любой фильм, появляются три иконки, плюсик, плэй, и какая то ещё, так вот нажав на иконку плея, открывается окно с фильмом и ничего более не происходит, индикатор загрузки в центре бесконечно крутится, но, если нажать на предыдущем этапе не на иконку а на превьюшку фильма, проваливаемся в описание фильма, где есть большая кнопа плей, нажав на которую фильм воспроизводится без проблем. Так же удалось на айфоне в приложухе "DS video" настроить доступ к киношкам, единственное что ненравится, необходимо указывать порт 443 в строке подключения, вот думаю это проблема Video Station или неверные настройки Nginx.

-

Понял, спасибо. Займусь заменой чуть позже, не хочется останавливать процесс копирования. А не подскажете по моему вопросу выше по Nginx? И можно ли опубликовать доступ сразу в Video Station минуя заход\авторизацию в DSM для пользователей которым хотел дать доступ исключительно для просмотра киношек?

-

Добрый день. Построил 10 Raid из 4х дисков по 4 тб, заливая данные, обнаружилась ошибка ввода\вывода на одном из дисков. Подскажите, что будет, если заменю проблемный диск чистым таким же, как на это отреагирует Synology, она сама подскажет? Или нужно в диспетчере хранения его деактивировать, после заменить на исправный и что-то потом сделать чтобы диск встал на замену неисправному и синхронизировался в 10 рейде?

-

Добрый день. Возникли сомнения, насчёт правильного proxy_pass на уже имеющимся в локальной сети Nginx сервера. Конфиг которого для для публикации Synology такой (секция location): location / { proxy_pass http://local_ip_synology:5000; #proxy_redirect http://local_ip_synology:5000 https://example.example.ru; нужна ли эта строка? proxy_redirect off; proxy_set_header Host $host; proxy_set_header X-Real-IP $remote_addr; proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for; proxy_set_header X-Forwarded-Proto $scheme; client_max_body_size 1000m; client_body_buffer_size 128k; proxy_connect_timeout 90; proxy_send_timeout 90; proxy_read_timeout 90; proxy_buffer_size 4k; proxy_buffers 4 32k; proxy_busy_buffers_size 64k; proxy_temp_file_write_size 64k; } Есть ли тут лишние\ненужные строки или может каких нехватает? Для получения в логах кто залогинен и откуда, в "Панель управления, Безопасность, доверенные прокси-серверы" добавил ip-адрес своего Nginx сервера. Есть пачка опций в "Панель управления, Безопасность", и в "Панель управления, Сеть, Настройки DSM", нужно ли там чего включать\отключать\менять? Вчера пробовал достать диск из Raid1 и подключить к виндовой машине, смог это сделать софтинкой "DiskInternals Linux Reader", BTrfs увидел, но данные увидеть не получилось, кроме того что есть четыре нулевых рейда btrfs. Раздел на Ext4 увидел, и файлы увидел, скачались и прочитались, выбор за файловой системы на свежеустановленном сегодня Synology оставил за Ext4.