-

Posts

70 -

Joined

-

Last visited

Posts posted by Skyinfire

-

-

В 12.10.2020 в 15:28, -iliya- сказал:

есть 2 по 8 портов LSI но они в режиме RAID, а перевести их в режим IT руки не доходят, да и не нашел нормальной инструкциии

оказалось, мой Lsi 9285CV-8e тоже тупо в IR-mode (как я понял, это RAID режим), а надо в IT-mode (HBA, как я понял). И поэтому у меня нихрена не работает.

Инструкции есть (например http://true-system.blogspot.com/2011/07/lsi-9211-48i-it.html), а вот прошивку я не смог найти на https://www.broadcom.com/support/storage - там черт ногу сломит и мою модель вообще не ищет...

-

Great.

As I understand it, IR-mode is RAID mode, and IT-mode is HBA (host bus adapter) mode.

And all adapters for xpenology should be in IT-mode. All adapters in IR-mode are not compatible with xpenology, right?

Why is this super-important information not listed in the compatibility list in a huge red font???

I selected the controller, relying entirely on the compatibility list. Picked it up. I bought it. And it doesn't work. Because there is no warning anywhere that all the controllers listed in the so-called "compatibility sheet" are actually useless garbage if they are in IR mode. -

И еще вопрос. Есть ли где-то списки совместимости (соответствия) версий DSM и версий (поколений) процессоров, поддерживаемых версией.

Для моего Celeron g3930 можно использовать DSM не старше 6.1.7, но выяснено это было полуэкспериментальным путем. Есть где-то прозрачные таблицы соответсвия? -

17 часов назад, Skyinfire сказал:

System ds3615xs

Typo. I use ds3617xs + lzma

-

В 12.10.2020 в 15:28, -iliya- сказал:

У меня один 9267 а второй 9271 как я понимаю это ребрендированные NEC

я вижу на 9267 у вас работает сборка

Скрытый тексттак эти контроллеры годятся под сервер или какие-то сложности с ними были? Я в списке совместимости (lzma) вообще не увидел их.

-

16 часов назад, Firs сказал:

LSI 9211-8i

Я не нашел его в листах совместимости того самого "extra.lzma for ds3615 v4.8".

Я так понимаю, эти листы до лампы, если все управление идет через Proxmox...

-

В 10.10.2020 в 11:20, -iliya- сказал:

у меня сейчас работает на нем, но есть другая проблема - если включены USB диски то при перезагрузке они сбивают нумерацию, приходится их подключать уже после загрузки.

9201-16i оказался тоже шляпой: если вылетел диск, пустую ячейку видно только до ребута - после ребута все последующие диски смещаются, занимая пустой слот и нумерация сбивается. Это все в полке. USB даже не тестировал, т.к. уже работа неприемлема для меня.

-

В 26.10.2020 в 13:15, victoryi сказал:

И так в цикле.

У меня такая же ситуация, только на оригинальном Synology RS2416+ с SHR.

В ТП сказали, что сделать ничего нельзя - нужно переносить все данные и пересобирать весь массив заново.

В 09.11.2020 в 14:02, victoryi сказал:Btrfs или Ext4?

Если не хотите проблем, берите Ext4. Он всегда нормально работал. "Плюшки" Btrfs рядовому пользователю не пригодятся. А вот огрести проблем с Btrfs на уровне ФС - это запросто.

У меня есть реальные случаи на оригинальных Synology с Btrfs, когда в какой-то момент эта система вдруг решила переименовать мне все папки "Зарубежные" в "3арубежные".

Видно, в чем проблема?

Вот я тоже долго не мог понять, какого хера все пути и каталоги не работают. Потом нашел. Во втором варианте название начинается с цифры три.

Вот такая классная Btrfs.

Отправлял багрепорты в Syno, может и пофиксили, но больше я ее не использую. На практике у нее нет преимуществ.

-

Бодаюсь с контроллером Lsi 9285CV-8e Он есть в листе совместимости extra.lzma но ни черта не работает.

Система 6.1.7 (1.02b) + extra.lzma for ds3617 v4.8.

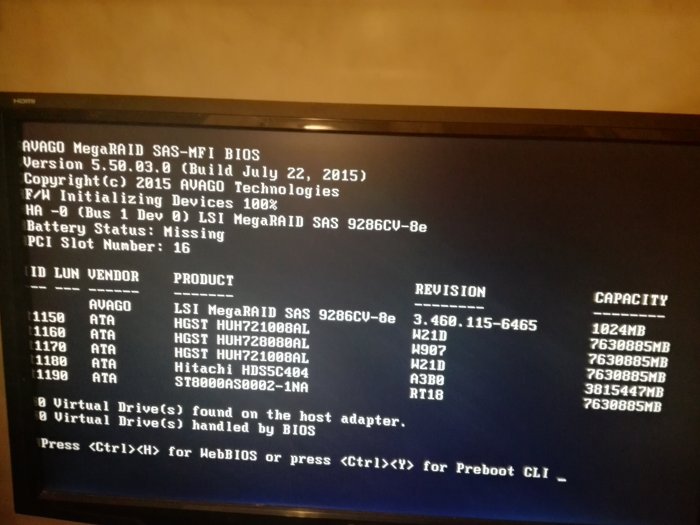

Контроллер исправен 100% (диски видны до загрузки XPEnology).

Второй контроллер (LSI 9201-16i) работает условно нормально с этими же дисками (и полкой).

Пока я делаю вывод, что IG-88 просто забыл положить сами драйвера от 9285CV-8e в extra.lzma (либо эти драйвера просто непотребные).Иначе, все бы работало как с 9201-16i.

Что я упускаю или как исправить ситуацию?

-

@Firs, благодарю за ответ.

Да, актуально, бодаюсь с контроллером (Lsi 9285CV-8e) сейчас. Он есть в листе совместимости "extra.lzma for ds3615 v4.8", но ни черта не работает (похоже, IG-88 просто забыл сами драйвера в него положить).

Скрытый текст

Ваш способ интересный, но очень муторный. Требует серьезной технической подготовки. А я хочу, чтобы все было просто: сделал флешку, прописал 1 раз конфиг и втыкай любые диски без ограничений, как в обычный Synology. -

Thank you for your answer.

15 часов назад, IG-88 сказал:you could try loader 1.03b

I can't use 1.03b loader, bacause Asus Z170 PRO GAMING + Celeron g3930 сan start only at 6.1.7 (1.02b).

16 часов назад, IG-88 сказал:the newer controller do have a mode for single disk equivalent to IT mode firmware, did you use this mode?

I don't understand the question.

"newer controller" is what??

I have two controllers: LSI SAS 9201-16i and Lsi 9285CV-8e. The first one works, the second one doesn't.

System ds3615xs 6.1.7 Jun's Mod V1. 02b + lzma 1.02b.

The type of partition on disks does not matter at all. Because I don't see the disks themselves in the system.

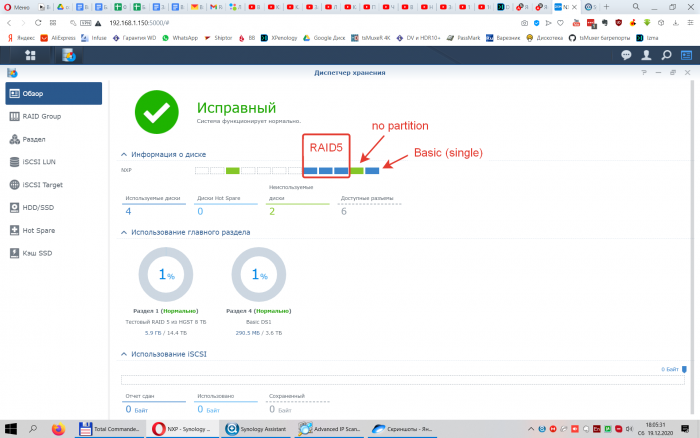

Here is the LSI SAS 9201-16i:Disks 8, 9 and 10 are in RAID5.

Disk 11 has no partitions at all.

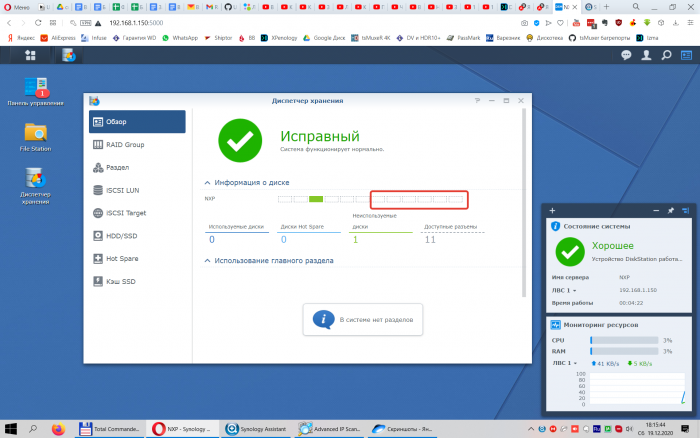

The disk 12 has a Single partition (Basic).And here are the same disks connected on the same system via Lsi 9285CV-8e:

The disks are simply not in the system.

At the same time, that the Lsi 9285CV-8e controller itself is 100% serviceable, since it identifies all 5 disks before loading xpenology:

From here I draw an obvious logical conclusion: "extra.lzma for ds3617 v4.8" either does not contain a driver for 9285CV-8e at all, or this driver is incorrect. Otherwise, everything would work exactly the same as with the 9201-16i.

Аre you 100% sure that the driver is included in extra. lzma? -

@IG-88

Hello.

I have Lsi 9285CV-8e (it 100% work - i see it + HDDs in boot bios befor XPEnology start), and i see it compatible list.But when XPEnology 6.1.7 + Driver extension jun 1.02b (3617xs) starts, it doest'n work (no one disk in system from this controller).

Why?

Another controllers (fo example LSI SAS 9201-16i) work, but i need work Lsi 9285CV-8e.

-

В 16.10.2020 в 09:27, DenisShiln сказал:

Есть ли рабочая конфигурация на 12 дисков?

почитайте ветку, выше есть скрины рабочей версии на 16 дисков.

На 12 много рабочих примеров, ищите здесь по 3615 и 3617

и на английском еще есть аналогичная ветка. -

22 часа назад, -iliya- сказал:

не должен же при рестарте USB диски как внутренние считать, а он считает

нет, конечно. А другой контроллер не пробовали?

-

Да, "настоящик" у меня есть, все разделы до 12 дисков будут.

На XPEnology автоматические обновления нужно же отключать и ставить только вручную (прочитав кучу варнингов и рисков перед этим).

Конфиг, вроде, правильный, насколько я разбираюсь.

А зачем нужен HS для RAID5, когда можно сразу сделать RAID6? Нет резона ждать, пока накроется какой-то из дисков, чтобы потом тратить время на копирование (из критического состояния, кстати) и защиту, когда можно защитить сразу 2 диска в RAID6. HD нужен для RAID6 и выше.

Даже чисто по количеству если смотреть, RAID5 из 15 дисков довольно рискованно: для такого количества нужен минимум RAID6, тем более, что диск для этого есть. Я бы прямо сейчас запустил перестройку из RAID5 в RAID6, но дело Ваше.

-

В 08.10.2020 в 05:56, XPEH сказал:

Это откуда?

https://xpenology.com/forum/announcement/24-dsm-623-25423-intermediate-update/

"This update breaks all custom modules (network and storage)" и

"you risk losing your volume"Что такое "custom modules" и патч NVMe? Я вижу слово storage и volume и пониманию их, как "раздел" и "массив". Других "стораджей" в насе нет. И мне очень не нравятся слова "breaks all" и "losing", стоящие в одном предложении с "массив" и "раздел".

-

2 часа назад, -iliya- сказал:

если включены USB диски то при перезагрузке они сбивают нумерацию

а usbportcfg и остальные правильно прописаны?

И сколько в итоге дисков работает на контроллере?

-

2 часа назад, -iliya- сказал:

Но если нужен надежный массив на много дисков то лучше все таки не хренологию рассматривать

А что рассматривать?

Я описывал в самом первом посте, почему XPEnology: дешево и сердито + относительно легкий переход с Synology (можно весь массив переставить вместе с данными) и обратно. В случае серьезных проблем я могу запросить ТП удаленно отремонтировать. У меня был случай, когда из рейда отваливалось больше дисков, чем защищало (у синолоджи это, кстати, частенько бывает - на ровном месте отваливается нормальный беспроблемный диск или даже два, восстановлением встает обратно и потом годами работает. Чего отваливался - не понятно) и сами диски были целые и с данными, просто вылетели из массива и стали зелеными. Стандартными средствами их обратно не вернуть было, а ТП удаленно вставили их обратно. А иначе массиву каюк.Правда, я видел в хелпе у синолоджи статью, что можно подключить все диски из рейда к линуксу и оттуда их собрать обратно в рейд, но это такой гемор и вилами по воде, что это сработает гладко и без проблем.

И потом, что значит, надежнее? RAID 5 или 6 он же везде одинаковый.

-

38 минут назад, XPEH сказал:

или мы говорим на разных языках

или вы просто задачу не поняли.

У меня нет проблемы или задачи "3. Проверить работает ли ваше железо с этой версией."

Если железо работает на 6.2, то 99,9%, что оно будет также нормально работать и на 6.2.3.

У меня разделы вообще стоят в оригинальных Synology и именно оттуда им предстоит миграция в XPEnology, а его версию я и выбираю для установки.

Проблема в том, что, по описанному вами алгоритму, если верить предупреждению по обновлению (красным жирным шрифтом), я опасаюсь, что после пункта

"6. Поменять флешку на новую версию, запустить с нее и принять предложенный вариант миграции."

последует пункт"7. Все разделы падают со всеми данными и все диски отображаются в системе как не размеченные (зеленые)."

Так что этот алгоритм не подходит мне в таком виде.

Пунктом 6 должна быть тестовая миграция на пустые тестовые разделы RAID5, RAID6 и SHR, для того, чтобы убедиться, что все они встают четко и без проблем.

И уже только после этого возможна миграция на разделы с данными.

-

Короче, как я понял, если изначально ставить версию 6.2.3, а не обновляться до нее, то перенос разделов должен идти ровно. С предварительным тестом на пустых разделах, разумеется.

-

C рутом разобрался, я просто делал по другой инструкции (я ее приводил), там предлагалось именно логиниться как root, а не как admin. Через "sudo -i" работает.

Короче, коротко о промежуточных итогах.

Толком все протестить пока не удалось, так как оба системника наотрез отказываются запускаться по сети (DHCP) на обоих интегрированных сетевухах и двух интеловских на сборках от 6.1 до 6.2.3, проблему я описывал в другой ветке, ни причин, ни решения найти не удалось. Предполагаю, что сборка виснет наглухо сразу после загрузки, т.к. нумлок не реагирует и курсор не моргает.

Заработала только DSM 5.2, но толку от нее нет, т.к. на команду "sudo -i" или "sudo su -" сервер (в Putty) пишет, что "-sh: sudo: not found". Дальше с ней делать нечего.

Сейчас буду на стороне заказывать сборку заведомо рабочей конфигурации с уже установленным Xpnology.

Пока есть возможность выбрать версию. Есть рекомендации?

Хочу последнюю 6.2.3 (на DS3617xs), но крайне смущает предупреждение о крашах массивов

https://xpenology.com/forum/announcement/24-dsm-623-25423-intermediate-update/

что абсолютно неприемлемо, т.к. предлагается дальнейший перенос нескольких массивов (они стоят в Synology 6.2.2-24922, а некоторые даже в 5.2-5967).В целом, последняя версия мне вообще не обязательна, т.к. от хранилища нужен только сетевой доступ и 6.2 должно быть за глаза.

Пока несколько раз грузилась 6.1, удалось подцепить полку на 24 харда. Тут выяснилось сразу несколько вещей.

Во-первых, сильно мешают встроенные в материнку SATA порты, т.к. они идут первыми и сбивают визуальную 12-тидисковую нумерацию: первый диск в полке становится пятым и т.д. Т.е. все порты и контроллеры в биосе надо отключать, а на тестовом системнике это оказалось невозможно - биос не предусматривал такого.

Во-вторых, не все контроллеры одинаково полезны.

На двухпортовом (8087) контроллере LSI SAS9200-8e SGL не закрепляются за дисками их постоянные "места": после перезагрузки все выключенные диски пропадают из системы, а все оставшиеся включенные располагаются рандомно (предположительно) и последовательно, занимая места с первого по поселений включенный. Т.е. если из 10 включенных дисков выдернуть третий и шестой, то после перезагрузки мы увидим 8 включенных дисков с 1-го по 8-й. Очевидно, такая работа контроллера неприемлема.

Кстати, встроенный SATA контроллер (который отключить не удалось) сохранял всегда нумерацию за каждым портом.

Второй контроллер LSI SAS 9201-16i, вроде, сохранял позиции, но тесты встали из-за проблем с определением в сети.

В-третьих, я нашел ошибку в заполнении параметров internalportcfg, что мы обсуждали выше.

В 15.01.2020 в 13:58, Olegin сказал:Последовательность СПРАВА-налево, сначала внутренние, потом USB, потом внешние sata

Не верно.

Справа налево - сначала внутренние, потом esata и только потом USB.

Вот оригинальная конфигурация DS2413 = 12 хардов + 4 eSata + 4 USB:

maxdisks="12"

internalportcfg="0xfff"= 0000 0000 1111 1111 1111

esataportcfg="0xf000"= 0000 1111 0000 0000 0000

usbportcfg="0xf0000"= 1111 0000 0000 0000 0000

Соответственно, себе я прописываю

maxdisks="240"

esataportcfg="0x0" ==> 0 esata

internalportcfg="0xffffffffffffffffffffffffffffffffffffffffffffffffffffffffffff" ==> 60 F = 60x4 = 240 хардов

usbportcfg="0xff000000000000000000000000000000000000000000000000000000000000" ==> 4+4 USB и 60 нулей

Кстати, параметр maxdisks="NNN" отвечает за количество отображаемых в интерфейсе внутренних дисков (параметр internalportcfg пока не ясно на что именно влияет).

Поглядываю на третий контроллер Lsi 9285CV-8e (3500 руб). т.к. он есть в списках драйверов lzma, это на случай, если не получится с LSI SAS 9201-16i, который громоздкий и работает только в паре с экспандером chenbro CK13601H-0BF, т.к. не имеет своих SFF8087.

Если есть рекомендации по проверенному недорогому контроллеру, который точно сохраняет за дисками места, буду рад подсказке.

Еще удалось ненадолго подцепить полку к Synology DS2415+ и он ее увидел!

Правда диски определились как ESATA. Времени на тесты не было - надо было отдавать сервер, но по-хорошему дальше нужно было менять конфиг и, возможно, все бы заработало как надо.

А вот со старичками Synology DS2413+ и DS3612xs такое провернуть не удалось.

Synology DS2413+ вообще не видит диски в полке расширения (через кабель 8047-8088) - ни как внутренние, ни как esata.

В "грейженый" до 240 дисков Synology DS2413 не ставится массив RAID5 (даже стоявший в нем ранее) даже в родные 12 слотов - система требует миграцию, которую невозможно запустить, т.к. на IP сервера зайти уже нельзя - система бесконечно висит. Приходится ставить DSM заново через асистент.

Нормально ставятся только пустые диски и одиночные (basic) диски (в сам Synology).

Synology DS3612xs тоже не видит полку ни как внутренние диски, ни как esata.

Проверялось на параметрах (24 HDD + 24 ESATA + 0 USB)

Дальше жду советы (версия DSM, контроллер), сборку рабочего сервера и, наконец, нормальные тесты на нем.

-

а поясните, пожалуйста, по предупреждению

https://xpenology.com/forum/announcement/24-dsm-623-25423-intermediate-update/

Очень не нравится фраза "This update breaks all custom modules (network and storage)".Особенно про краш хранилища.

Что оно означает и как/где проявляется? И чего нельзя делать, а что можно?

Можно ли безопасно запустить сначала сборку 6.2.3, а потом вставить в сервер размеченный рейд5, но более ранний (6.0, например, или 5.2) и подцепить его нормально, а не угробить его вместе с данными?

-

А Numlock нажимается/гаснет с клавиатуры?

-

На работающих xpnology 6.Х мигает курсор? Numlock отзывается?

Установка XPEnology на PC

in Аппаратное обеспечение и совместимость

Posted

Ответил IG-88. Похоже, мой Lsi 9285CV-8e находится в IR-mode (как я понял, это RAID режим), а надо, чтобы был в IT-mode (HBA, как я понял).

И это касается всех адаптеров, как я понял, поэтому весь этот "список совместимости" можно в мусорку выкидывать, если купленный адаптер оказался в RAID-режиме.