awunschik

-

Posts

14 -

Joined

-

Last visited

Posts posted by awunschik

-

-

10 hours ago, IG-88 said:

ist es denn aktiviert bei deinem system?

beim erzeugen eines shares kann/sollte man das aktivieren

3. tab bei einem share (advanced)

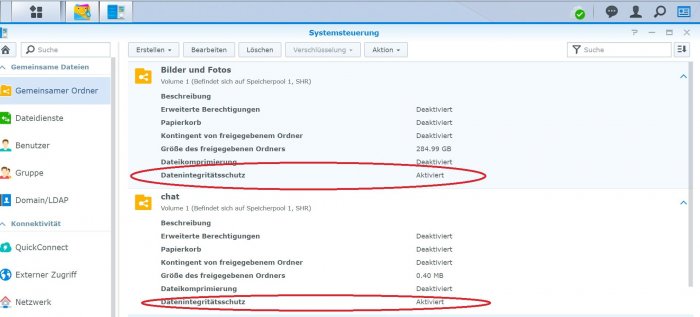

Ja ich habe es aktiviert.

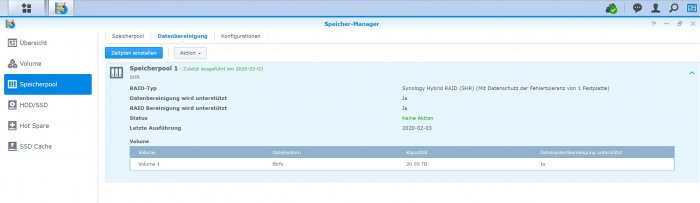

Also wenn damit der Datenintegritätsschutz der gemeinsamen Ordner gemeint ist (siehe Bild 1)10 hours ago, IG-88 said:soweit ich das nachlesen konnte würde man das in dem paket "Log Center" nachher finden

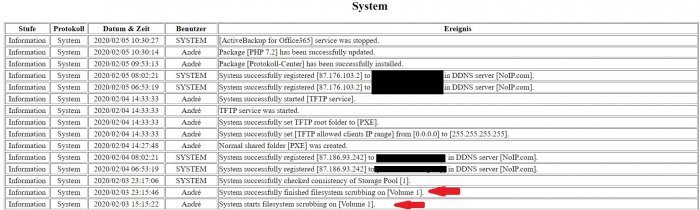

Ich habe das Paket "Protokoll-Center" nachinstalliert.

Der Inhalt zeigt mir jedoch lediglich, dass das Scrubbing statt gefunden hat.

Ein Ergebnis lässt sich aber nicht auslesen...Bild zwei zeigt einen HTML-Export.

-

-

Na dann werde ich das mal hier posten, wenn alles durchgelaufen ist...

Vermutlich in 3 Tagen oder so.

Schönen Feierabend! -

20 minutes ago, IG-88 said:

du merkst ih nur nicht, du solltest noch scrubing laufen lassen um evtuelle fehler durch die verluste zu finden, theoretisch findest du so raus welche dateien betroffen sind

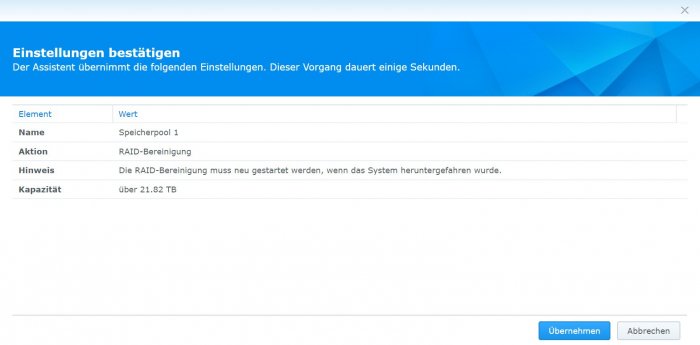

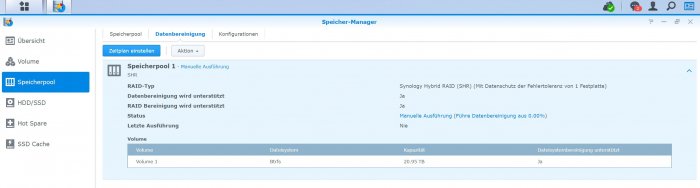

Ist das Scrubbing dann hier zu finden?

Dann mache ich das wohl nach der Konsistenzprüfung?

Oder besser über die Console? -

Ein ganz ganz dickes fettes Danke für deine Geduld, investierte Zeit und deine kompetenten, schnellen Antworten! ✊

Es hat genau so funktioniert, wie du es beschrieben hast.

Dank Dir habe ich wieder ein funktionierendes System praktisch ohne Datenverlust. 😁Ich werde mir für die Zukunft vornehmen, mich da mal ein bisschen rein zu lesen.

Herzliche Grüße

André -

sudo mdadm --stop /dev/md2

mdadm: stopped /dev/md2 sudo mdadm --assemble --force /dev/md2 /dev/sd[abc]5

mdadm: forcing event count in /dev/sdc5(2) from 2746 upto 2797

mdadm: /dev/md2 has been started with 3 drives (out of 4).cat /proc/mdstat

Personalities : [linear] [raid0] [raid1] [raid10] [raid6] [raid5] [raid4]

md2 : active raid5 sda5[0] sdc5[2] sdb5[1]

23427586368 blocks super 1.2 level 5, 64k chunk, algorithm 2 [4/3] [UUU_]md1 : active raid1 sda2[0] sdb2[1] sdc2[2] sdd2[3]

2097088 blocks [16/4] [UUUU____________]md0 : active raid1 sda1[0] sdb1[1]

2490176 blocks [16/2] [UU______________]unused devices: <none>

sudo mdadm --detail /dev/md2

/dev/md2:

Version : 1.2

Creation Time : Sun Jun 2 22:53:00 2019

Raid Level : raid5

Array Size : 23427586368 (22342.29 GiB 23989.85 GB)

Used Dev Size : 7809195456 (7447.43 GiB 7996.62 GB)

Raid Devices : 4

Total Devices : 3

Persistence : Superblock is persistentUpdate Time : Mon Jan 27 11:20:04 2020

State : clean, degraded

Active Devices : 3

Working Devices : 3

Failed Devices : 0

Spare Devices : 0Layout : left-symmetric

Chunk Size : 64KName : NAS_DS918plus:2 (local to host NAS_DS918plus)

UUID : 96879d75:bd06edee:8c1bd43a:3702eb17

Events : 2798Number Major Minor RaidDevice State

0 8 5 0 active sync /dev/sda5

1 8 21 1 active sync /dev/sdb5

2 8 37 2 active sync /dev/sdc5

- 0 0 3 removed---------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------

sudo mdadm --detail /dev/md2

/dev/md2:

Version : 1.2

Creation Time : Sun Jun 2 22:53:00 2019

Raid Level : raid5

Array Size : 23427586368 (22342.29 GiB 23989.85 GB)

Used Dev Size : 7809195456 (7447.43 GiB 7996.62 GB)

Raid Devices : 4

Total Devices : 3

Persistence : Superblock is persistentUpdate Time : Mon Jan 27 11:20:04 2020

State : clean, degraded

Active Devices : 3

Working Devices : 3

Failed Devices : 0

Spare Devices : 0Layout : left-symmetric

Chunk Size : 64KName : NAS_DS918plus:2 (local to host NAS_DS918plus)

UUID : 96879d75:bd06edee:8c1bd43a:3702eb17

Events : 2798Number Major Minor RaidDevice State

0 8 5 0 active sync /dev/sda5

1 8 21 1 active sync /dev/sdb5

2 8 37 2 active sync /dev/sdc5

- 0 0 3 removedSoll ich das Ding jetzt neustarten?

-

Danke Dir erstmal das du Geduld mit mir hast und dran bleibst!

So sieht das ganze aus nach Eingabe der vier Befehle.

Wie "zwinge" ich denn die Platten wieder in das RAID?

sudo fdisk -lDisk /dev/ram0: 640 MiB, 671088640 bytes, 1310720 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 4096 bytes

I/O size (minimum/optimal): 4096 bytes / 4096 bytes

Disk /dev/ram1: 640 MiB, 671088640 bytes, 1310720 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 4096 bytes

I/O size (minimum/optimal): 4096 bytes / 4096 bytes

Disk /dev/ram2: 640 MiB, 671088640 bytes, 1310720 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 4096 bytes

I/O size (minimum/optimal): 4096 bytes / 4096 bytes

Disk /dev/ram3: 640 MiB, 671088640 bytes, 1310720 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 4096 bytes

I/O size (minimum/optimal): 4096 bytes / 4096 bytes

Disk /dev/ram4: 640 MiB, 671088640 bytes, 1310720 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 4096 bytes

I/O size (minimum/optimal): 4096 bytes / 4096 bytes

Disk /dev/ram5: 640 MiB, 671088640 bytes, 1310720 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 4096 bytes

I/O size (minimum/optimal): 4096 bytes / 4096 bytes

Disk /dev/ram6: 640 MiB, 671088640 bytes, 1310720 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 4096 bytes

I/O size (minimum/optimal): 4096 bytes / 4096 bytes

Disk /dev/ram7: 640 MiB, 671088640 bytes, 1310720 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 4096 bytes

I/O size (minimum/optimal): 4096 bytes / 4096 bytes

Disk /dev/ram8: 640 MiB, 671088640 bytes, 1310720 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 4096 bytes

I/O size (minimum/optimal): 4096 bytes / 4096 bytes

Disk /dev/ram9: 640 MiB, 671088640 bytes, 1310720 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 4096 bytes

I/O size (minimum/optimal): 4096 bytes / 4096 bytes

Disk /dev/ram10: 640 MiB, 671088640 bytes, 1310720 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 4096 bytes

I/O size (minimum/optimal): 4096 bytes / 4096 bytes

Disk /dev/ram11: 640 MiB, 671088640 bytes, 1310720 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 4096 bytes

I/O size (minimum/optimal): 4096 bytes / 4096 bytes

Disk /dev/ram12: 640 MiB, 671088640 bytes, 1310720 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 4096 bytes

I/O size (minimum/optimal): 4096 bytes / 4096 bytes

Disk /dev/ram13: 640 MiB, 671088640 bytes, 1310720 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 4096 bytes

I/O size (minimum/optimal): 4096 bytes / 4096 bytes

Disk /dev/ram14: 640 MiB, 671088640 bytes, 1310720 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 4096 bytes

I/O size (minimum/optimal): 4096 bytes / 4096 bytes

Disk /dev/ram15: 640 MiB, 671088640 bytes, 1310720 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 4096 bytes

I/O size (minimum/optimal): 4096 bytes / 4096 bytes

Disk /dev/sda: 7.3 TiB, 8001563222016 bytes, 15628053168 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 4096 bytes

I/O size (minimum/optimal): 4096 bytes / 4096 bytes

Disklabel type: gpt

Disk identifier: 588A26DF-FB20-4482-B28A-43DA8F2F8A90Device Start End Sectors Size Type

/dev/sda1 2048 4982527 4980480 2.4G Linux RAID

/dev/sda2 4982528 9176831 4194304 2G Linux RAID

/dev/sda5 9453280 15627846239 15618392960 7.3T Linux RAID

Disk /dev/sdb: 7.3 TiB, 8001563222016 bytes, 15628053168 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 4096 bytes

I/O size (minimum/optimal): 4096 bytes / 4096 bytes

Disklabel type: gpt

Disk identifier: 37888397-2EFF-4A0B-968B-E0ABCB2E4FB0Device Start End Sectors Size Type

/dev/sdb1 2048 4982527 4980480 2.4G Linux RAID

/dev/sdb2 4982528 9176831 4194304 2G Linux RAID

/dev/sdb5 9453280 15627846239 15618392960 7.3T Linux RAID

Disk /dev/sdc: 7.3 TiB, 8001563222016 bytes, 15628053168 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 4096 bytes

I/O size (minimum/optimal): 4096 bytes / 4096 bytes

Disklabel type: gpt

Disk identifier: 36512BBE-A2AA-4999-B0D5-FB290FA7D8B5Device Start End Sectors Size Type

/dev/sdc1 2048 4982527 4980480 2.4G Linux RAID

/dev/sdc2 4982528 9176831 4194304 2G Linux RAID

/dev/sdc5 9453280 15627846239 15618392960 7.3T Linux RAID

Disk /dev/sdd: 7.3 TiB, 8001563222016 bytes, 15628053168 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 4096 bytes

I/O size (minimum/optimal): 4096 bytes / 4096 bytes

Disklabel type: gpt

Disk identifier: E2E136EE-927C-4859-B486-F1C10983B92ADevice Start End Sectors Size Type

/dev/sdd1 2048 4982527 4980480 2.4G Linux RAID

/dev/sdd2 4982528 9176831 4194304 2G Linux RAID

/dev/sdd5 9453280 15627846239 15618392960 7.3T Linux RAID

Disk /dev/md0: 2.4 GiB, 2549940224 bytes, 4980352 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 4096 bytes

I/O size (minimum/optimal): 4096 bytes / 4096 bytes

Disk /dev/md1: 2 GiB, 2147418112 bytes, 4194176 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 4096 bytes

I/O size (minimum/optimal): 4096 bytes / 4096 bytes

GPT PMBR size mismatch (102399 != 15257599) will be corrected by w(rite).

Disk /dev/synoboot: 7.3 GiB, 7811891200 bytes, 15257600 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 512 bytes

I/O size (minimum/optimal): 512 bytes / 512 bytes

Disklabel type: gpt

Disk identifier: 52173969-41B8-4EDB-9190-B1CE75FCFA11Device Start End Sectors Size Type

/dev/synoboot1 2048 32767 30720 15M EFI System

/dev/synoboot2 32768 94207 61440 30M Linux filesystem

/dev/synoboot3 94208 102366 8159 4M BIOS boot

Disk /dev/zram0: 1.1 GiB, 1199570944 bytes, 292864 sectors

Units: sectors of 1 * 4096 = 4096 bytes

Sector size (logical/physical): 4096 bytes / 4096 bytes

I/O size (minimum/optimal): 4096 bytes / 4096 bytes

Disk /dev/zram1: 1.1 GiB, 1199570944 bytes, 292864 sectors

Units: sectors of 1 * 4096 = 4096 bytes

Sector size (logical/physical): 4096 bytes / 4096 bytes

I/O size (minimum/optimal): 4096 bytes / 4096 bytes

Disk /dev/zram2: 1.1 GiB, 1199570944 bytes, 292864 sectors

Units: sectors of 1 * 4096 = 4096 bytes

Sector size (logical/physical): 4096 bytes / 4096 bytes

I/O size (minimum/optimal): 4096 bytes / 4096 bytes

Disk /dev/zram3: 1.1 GiB, 1199570944 bytes, 292864 sectors

Units: sectors of 1 * 4096 = 4096 bytes

Sector size (logical/physical): 4096 bytes / 4096 bytes

I/O size (minimum/optimal): 4096 bytes / 4096 bytesls /dev/sd*

/dev/sda /dev/sda5 /dev/sdb2 /dev/sdc1 /dev/sdd /dev/sdd5

/dev/sda1 /dev/sdb /dev/sdb5 /dev/sdc2 /dev/sdd1

/dev/sda2 /dev/sdb1 /dev/sdc /dev/sdc5 /dev/sdd2sudo mdadm --detail /dev/md2

Version : 1.2

Creation Time : Sun Jun 2 22:53:00 2019

Raid Level : raid5

Array Size : 23427586368 (22342.29 GiB 23989.85 GB)

Used Dev Size : 7809195456 (7447.43 GiB 7996.62 GB)

Raid Devices : 4

Total Devices : 2

Persistence : Superblock is persistentUpdate Time : Sat Jan 25 15:27:15 2020

State : clean, FAILED

Active Devices : 2

Working Devices : 2

Failed Devices : 0

Spare Devices : 0Layout : left-symmetric

Chunk Size : 64KName : NAS_DS918plus:2 (local to host NAS_DS918plus)

UUID : 96879d75:bd06edee:8c1bd43a:3702eb17

Events : 2790Number Major Minor RaidDevice State

0 8 5 0 active sync /dev/sda5

1 8 21 1 active sync /dev/sdb5

- 0 0 2 removed

- 0 0 3 removedsudo mdadm --examine /dev/sd[abcd]5 | egrep 'Event|/dev/sd'

/dev/sda5:

Events : 2790

/dev/sdb5:

Events : 2790

/dev/sdc5:

Events : 2746

/dev/sdd5:

Events : 2746 -

9 hours ago, IG-88 said:

ich dachte da eher an die mdstat und mdadm sachen um sich über den zustand des raids zu verschaffen, ...

mdstat spuckt das aus:

Personalities : [linear] [raid0] [raid1] [raid10] [raid6] [raid5] [raid4]

md2 : active raid5 sda5[0] sdb5[1]

23427586368 blocks super 1.2 level 5, 64k chunk, algorithm 2 [4/2] [UU__]md1 : active raid1 sda2[0] sdb2[1] sdc2[2] sdd2[3]

2097088 blocks [16/4] [UUUU____________]md0 : active raid1 sda1[0] sdb1[1]

2490176 blocks [16/2] [UU______________]unused devices: <none>

Und bei mdadm kommt Folgendes:

mdadm: Found some drive for an array that is already active: /dev/md2

mdadm: giving up.

mdadm: No arrays found in config file or automaticallyIch habe keine Ahnung was ich hier tue 😜

-

11 hours ago, IG-88 said:

lies doch mal diesen noch laufenden fall, ist sehr lehrreich (nicht nur in bezug auf die frage ob man ein backup braucht)

Danke Dir!

Ich will jetzt auch echt nicht auf doof machen, aber bringt mich das weiter den Beitrag zu studieren?

Versteh mich bitte nicht falsch - ich will nicht, dass mir die gebratenen Tauben in den Mund fliegen, nur habe ich gerade ganz wenig Zeit mich weiter zu bilden.

hab da mal kurz reingelesen und es sind bömische Dörfer für mich 😫

Was ich für Fehler gemacht habe, das ist mir nun einigermaßen klar.

Ich habe nicht den Ernstfall eines Hardwareausfalls in Form des Controllers gedacht und das falsche "System" in Form von "Ausfllsicherheit 1 von 4 gewählt".

Also hilft mir der von dir verlinkte Beitrag?

LG

André -

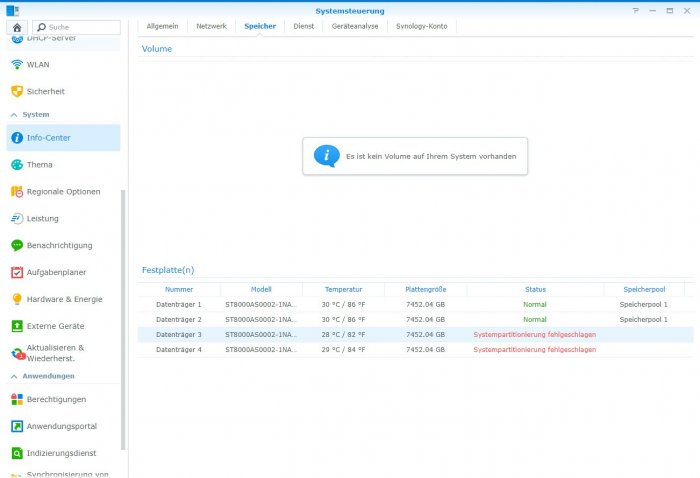

Ich habe den Controller eingebaut und alles angeschlossen.

Jetzt meldet mir DSM im INFO-Center, dass die Systempartitionierung der zwei oben erwähnten Festplatten fehlgeschlagen sei.

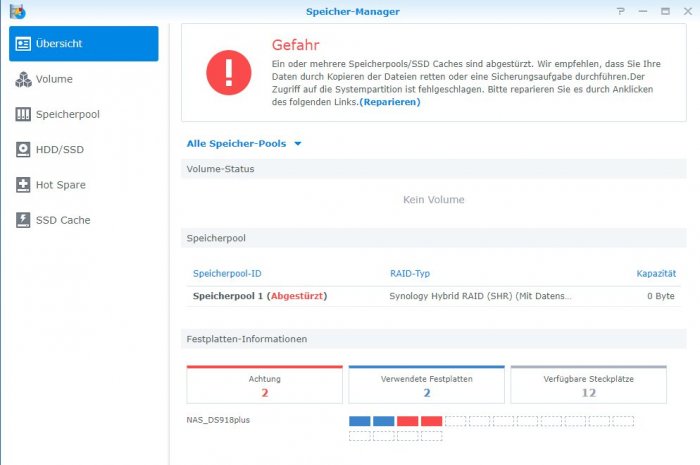

Wenn ich nun den Speicher-Manager öffne, wird mir gesagt Speicherpool 1 sei abgestürzt.Nun schlägt DSM eine Sichererung meiner Daten und eine darauf folgende Reperatur vor.

Jetzt stehe ich vor dem Problem, die Daten nicht sichern zu können, weil ich nicht ran komme 🙄

Ich befürchte, dass wenn ich einfach auf Reparieren gehe, meine Daten futsch sind.

Weiß jemand einen Rat? -

3 minutes ago, jensmander said:

Schon mal mit einem alternativen Boot Stick getestet (Live Linux o.ä.), ob an den besagten Ports wirklich keine HDDs mehr erkannt werden? Nur um XPEnology als Verursacher ausschließen zu können.

Danke für Deine Antwort!

Ich habe im BIOS die Anzeige für die 4 SATA-Ports.

Port 1 und 2 erkennt alle vier Platten (nach Neustart und umstecken).

Port 3 und 4 erkennt keine Platte mehr (laut BIOS).

Deshalb die Vermutung des defekten Controllers.

Nun habe ich erstmal einen 4-fach PCI-E-Controller bestellt und hoffe, dass das Ganze damit wieder funktioniert 😩 -

Hi!

Ich betreibe seit ca.einem halben Jahr ein Eigenbau-NAS, auf dem Xpenology installiert ist.

Hier die Spezifikationen:

ASRock J4105-ITX

Inter-Tech IPC SC-4100 Wuerfel

250 Watt Inter-Tech

8192MB Samsung M471A5244CB0-CRCD0 DDR4-2400 SO-DIMM CL17-17-17 Single4x Seagate Archive HDD 8TB

Installiert ist Xpenology auf einem 8 GB Platinum USB-Stick.

Als Speicherkonfiguration habe ich diese Synology-Geschichte genommen mit der "Ausfallsicherheit" von einer HDD.Das System lief 24/7 ohne Probleme, bis mir letzten Freitag das Betriebssystem meldete, dass der Speicherpool ausgefallen sei, oder so.

Ich habe dann zu Hause auch gleich gesehen, dass die LEDs der Trays 3 und 4 nicht mehr leuchteten.

Nach einigen Test mit anderem Netzteil und dergleichen, ist mir dann aufgefallen, dass die zwei Festplatten am 2. SATA-Controller des Boards hängen.Laut Benutzerhandbuch handelt es sich um den ASMedia (vermute ich).

• 2 x SATA3 6.0 Gb/s Connectors, support NCQ, AHCI and Hot Plug

• 2 x SATA3 6.0 Gb/s Connectors by ASMedia ASM1061, support NCQ, AHCI and Hot PlugDie Festplatten werden von anderen Rechnern und den anderen 2 Anschlüssen noch erkannt.

Und nun zu meiner eigentlichen Frage:

Wie komme ich wieder an meine Daten?

Also wie kann ich das System wieder zum Laufen bringen.Es geht mir darum, dass der Speicherpool wieder erkannt wird.

Hier meine Fragen im Einzelnen:1. Da auf das Board noch Garantie ist, wäre eine Reklamation möglich. Wäre das die beste Lösung?

Ich weiß ja nicht, ob die Taiwanesen da großes Geschiss machen, und den SATA-Controller reparieren oder nicht doch das ganze Mainboard wechseln.

2. Würde es auch funktionieren, einen PCI-E-Controller zu installieren, der die Platten dann anspricht?

Ich brauch Hilfe von erfahrenen Benutzern, die sich damit auskennen.

Vielen Dank im Voraus!

LG

André

-

Hallo!

Ich habe auch oben genanntes Mainboard.

Mein Problem ist, dass ich keinen einzigen Loader zum Laufen bekomme.

Die grub.cfg ist angepasst (VID,PID,MAC und Serial).

Ich komme bis zu dem Punkt, wo ich die DS suchen lasse, aber anscheinend schmiert das NAS ab,

denn es wird keine DS gefunden.

Es wäre schön, wenn mir jemand helfen könnte.

Danke im Voraus!

ASRock J4105-ITX SATA-Controller DEFEKT

in GERMAN

Posted

Hi!

Ich fürchte das bringt Dich nicht weiter.

Ich habe tatsächlich einen defekten Controller auf dem Mainboard.

Keine Festlappte wird von 2/4 Anschlüssen erkannt.

Durch den Einbau einer PCI-E Karte und Hilfe hier aus dem Board habe ich das Raid dann wieder ans Laufen bekommen.

Mein Server läuft 24/7 und wenn Du dringend Bilder/Einstellungen benötigst, häng ich meinen Monitor bei Gelegenheit mal dran und poste die Dinge hier,

aber ich vermute nicht, das wir nicht das selbe Problem haben/hatten...

LG

André