kouignamann

Member-

Posts

29 -

Joined

-

Last visited

Recent Profile Visitors

The recent visitors block is disabled and is not being shown to other users.

kouignamann's Achievements

Junior Member (2/7)

0

Reputation

-

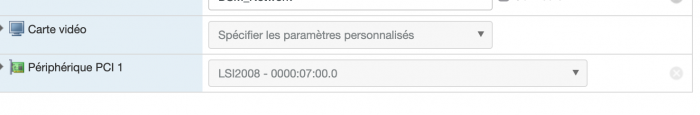

(Discaimer : I've already posted in the french section but in a effort to broader my audience, I give it a try here) I've just purchased a Ellipse ECO 650 USB FR (EL650USBFR) UPS Unfortunately, I've battled with it for two hours trying to get DSM to detect it without success. My config HP Proliant Gen 8 Server Xeon e3-1220 V2 16 GB RAM IBM M1015 (IT mode) ESXI 6.7 - the HP version ("HPE Custom Image for ESXi 6.7 GA"). Jun's Loader v1.03b DS3615xs Basically, I've added a USB controler to my VM and a USB peripheral "EATON Ellipse ECO" Which gives me nothing in the configuration panel in DSM. "No UPS attached" Even though, running a "lsusb" give me a USB peripheral "EATON Ellipse Eco". So at least it's somewhere. By writing these lines I've just realized that DS3615xs doesn't support my UPS. https://www.synology.com/fr-fr/compatibility?search_by=category&category=upses&filter_brand=EATON&p=1 This is unfortunate. Is it dead or - given that I run xpenology and not really a DS615xs - there is a workaround ? I've found this thread from 2013 A few things : My "/usr/syno/etc/ups/ups.conf" is by default with "driver = triplite_usb" I believe that my USB UPS supports driver "usbhid-ups" (from NUT website and various terminal commands I ran) So, I've edited the up.conf file, changing : driver = usbhid-ups productid = the pid of my UPS vendorid = the vid of my UPS (which is "fffff" weird) Then I've spent 30 minutes finding how to escape vim 🥴 From the thread mentionned above I've run a check : usbhid-ups -u root -DDD -a ups But it spits various error among them a "usb descriptor thing". My USB device descriptor appears to be too long. Something something, me no likey Writing those lines I just realize that I was logged as "admin" but ran the command with "-u root" (I don't know the root pw. my admin account has admin privilege). So, maybe : usbhid-ups -u admin -DDD -a ups Among the errors, I sometimes get error saying the USB device cannot be accessed. Elsewhere on the forum I've seen people modifying the chmod of some folder in order to extend the USB device accessibility. Hum. Any clues ? Am I entirely wrong ? Last chance would be to create a small headless VM just to run a NUT server in ESXI. But meh.

-

Je viens d'acquérir un UPS/Onduleur Eaton Ellipse ECO 650 USB FR (EL650USBFR). Et, malheureusement. J'ai passé deux heures à essayer de le faire reconnaitre par ma VM Synology hier sans succès. Voici mon installation : HP Proliant Gen 8 Server Xeon e3-1220 V2 16 GB RAM IBM M1015 (IT mode) ESXI 6.7 - the HP version ("HPE Custom Image for ESXi 6.7 GA"). Jun's Loader v1.03b DS3615xs Donc j'ai ajouté un controler USB à ma VM et ajouté le périphérique USB "EATON Ellipse ECO". Rien dans le panneau de config de DSM. Pas d'UPS detecté. En écrivant ceci, je réalise que le DS3615xs ne support pas mon UPS : https://www.synology.com/fr-fr/compatibility?search_by=category&category=upses&filter_brand=EATON&p=1 C'est mort ? On peut contourner ? Je suis tombé sur ce post sur le forum, dans la section anglophone : Plusieurs choses : Il me semble que mon "/usr/syno/etc/ups/ups.conf" est par defaut avec un driver "triplite_usb" Il me semble que mon UPS supporte le driver "usbhid-ups" Du coup j'ai edité le fichier de conf en changeant : driver = usbhid-ups productid = le pid de mon périphérique USB vendorid = le vid de mon périphérique USB Ensuite j'ai passé 30 minutes a trouver comment quitter vim 🥴 J'ai tenté un test avec cette commande un peu mystérieuse que j'ai trouvé dans le thread ci-dessus : usbhid-ups -u root -DDD -a ups Mais ce me retourne une erreur au niveau du "descriptor" du périphérique USB (il peut pas le lire). En écrivant cela je me demande s'il aurait mieux fallu que je la passe avec "-u admin" - car je me connecte en SSH avec admin usbhid-ups -u admin -DDD -a ups ? Bref, ca n'a pas l'air de marcher. Est-ce que je fais fausse route ? En dernier recours je fait une micro VM linux en guise de server NUT et puis voila. Mais c'est dommage...

-

Question avant de migrer vers une installation virtuelle

kouignamann replied to kouignamann's topic in Installation Virtuelle

-

Question avant de migrer vers une installation virtuelle

kouignamann replied to kouignamann's topic in Installation Virtuelle

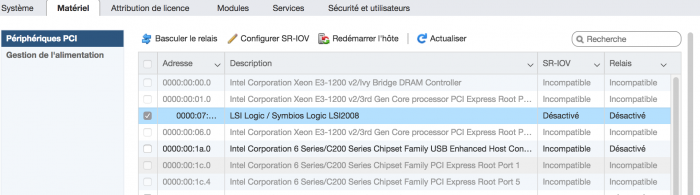

C'est qu'une hypothèse, mais j'ai l'impression que ESXI 6.7 gère moyennement bien ma carte HBA (IBM M1015 : controlleur LSI SAS2008). Il apparait que ESXI ne gère pas de cache pour les accès disques. Cette carte n'a pas de cache hardware. Donc ça souffre un peu. Pour le controlleur SAS HP Smartarray, etc. Il existe un driver specifique que propose HP donc à priori ça doit mieux fonctionner (pas testé). Du coup, je passe la carte contrôleur à DSM, et il se débrouille mieux que ESXI (il doit certainement gérer le cache). Il faut que je revérifie mais je crois avoir récupéré les infos SMART. 45 euros bien investi ce Xeon. J'avais peur du TDP au dessus des specs du radiateur (69W vs. 35W pour le Celeron d'origine) mais pas de problème. Même à pleine charge (encodage Plex), il arrive juste que le ventilo principal monte un poil, genre de 5%. -

Question avant de migrer vers une installation virtuelle

kouignamann replied to kouignamann's topic in Installation Virtuelle

J'ai continué avec mes problèmes sur un thread en anglais. En fin de compte, tout semble rentrer dans l'ordre (ou pas loin en tout cas) en passant la carte HBA à DSM directement. -

Tested again. Enabled jumbo frames on the vSwitch, DSM network config and Windows network config. No noticeable improvement. I passed through my HBA card as a PCI device instead of passing each disk with RDM. Now I get between 50 MB/s and 500 MB/s transfer speeds. I like it better. I have spare SSD lying arround, I'll try enabling SSD cache in DSM to see if I get better results.

-

So I've done some more testing. I don''t think this is a write caching issue since I'm reading files from a volume on the HBA card and writing on a regular SSD on a separate SATA port. First thing first. My transfers speed between a regular computer on the network (my Mac) and the DSM vm are normal. I get about the same speeds as in bare-metal. Not the same story when I use the Windows VM instead of a computer. My datastore is connected to the optical drive SATA port on the motherboard. Maybe it was slow. So I've connected it to the SAS port of the motherboard (can"t boot from HBA card). No improvement. I tried using a dedicated SSD connected to the second SAS port of my HBA card and using this disk (as RDM disk) with windows VM. To see if it is a thick provisionning thing. No improvement. I tried a regular Windows 10 family instead of Windows 10 Ent. LTSB. To see if I have a windows issue. No improvement. I tried disabling all firewalls and all in the windows VM. No improvement. I need to do some more testing. I'm no longer sure my read/write speeds are good with a regular computer (MacOS doesn't display transfer speeds). Again, could it be a wetwork thing. I feel like It doesn't balance the load very well between users connected to the DSM VM. Once the Windows VM is started, even if it has close to zero network activity. My transfer speeds with DSM shares are lower.

-

EDIT : Tested again, not in Remote Desktop but with vSphere console. I was able to get a fast transfer of my test file until 50%. Then it dropped to zero and froze. Weird.

-

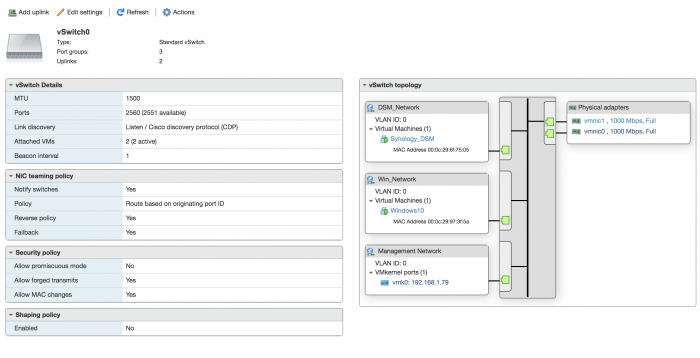

Windows VM is "Thick provisioned, lazily zeroed" DSM was migrated to a new install. VM Tools installed (with Synology Package Center). Windows VM has VM Tools as well. ESXI is latest HP custom image. Below a screenshot of a file transfer. And my vSwitch config.

-

Which means? It the virtual disk large enough? Or, is it a specific setting I may have missed? I tested again last night : I logged into my Windows VM with Remote Desktop I connected one of my DSM share as a network drive. Browsing through the folders of the share is normal and I see no lag. I use the Windows 10 ISO file as a test file (about 4GB). Transfers started arround 30MBps and immediatly drops to a few hundreds KBps and zero. Once it gets to zero (it took less than ten seconds) I canceled the file copy and I was barely able to browse the share. I couldn't even copy a small image file to the share. I also ran Adobe Lightroom on the Windows VM to test an image export. It was unable to export anything as the export job froze at 0%. Indicating it cannot access the source files on the share. Which is even worse than when I first tested it (same ISO file). On earlier tests, the copy speed waas very unstable between 10 and 40 MBps but did not drop to zero. Worth mentioning. I the meantime my laptop was connected to a DSM share and everything was very fast and snappy. I just noticed a glitch. I was playing a video file in VLC from a DSM share and it froze when the Windows VM started. For the sake of testing things. I opened "speedtest" website in Windown VM internet browser to test internet speed. I got 800 Mbps down (I have fast internet at home) but upload test failed (weird again). I don't know where the bottleneck is.

-

The two VMs uses different disks/controllers. Apart from the tiny virtual boot drive, DSM VM uses 4 disks on the HBA card. 3 of them are managed as a RAID volume by DSM. Windows VM uses a virtual disk in ESXI datastore. The datastore is stored on a SSD, connected to a SATA port on the motherboard. I don't know how fast is this SATA port.

-

So. First of all, here is my setup : HP Proliant Gen 8 Server Xeon e3-1220 V2 16 GB RAM IBM M1015 (flashed in IT mode) controler card. 4 big disks plugged on SAS port 0 on the controller card. 1 SSD plugged on one free SATA connector on the motherboard (I believe it is for optical drive) I installed ESXI 6.7 - the HP version ("HPE Custom Image for ESXi 6.7 GA"). I was able to migrate my baremetal install of DSM to a VM one (with Jun's Loader v1.03b DS3615xs). I did not passtrought the HBA card. Just each disk as "raw disk" (RDM). Accessing to my DSM share though the network is somewhat similar to what it was bare-metal. Speed is ok from my Macs using either SMB or AFP protocols. So, I think I have no problem here. I've also created a Windows 10 VM. I've had to use Windows Enteprise because I need remote desktop and it's no longer in the "Family" branch (took me a while to figure this one out). So I have latest Win10 Ent LTSB N. It works ok (I think). However, when I mount one of my DSM share. Transfers are slow and unstable. Which defeats the purpose of having a Windows VM running alongside the NAS VM in the same host. I may have missed something in the network settings. I have both my NICs connected to one Vswitch. I have one "port group" (can't remember the name) for DSM. Another one for Windows VM. Both VMs have a network adapter in VMXNET3.

-

Question avant de migrer vers une installation virtuelle

kouignamann replied to kouignamann's topic in Installation Virtuelle

Je pense que ça se passe sur cet écran (dans l'image). "SR-IOV" ou "Relais". J'ai installé Windows 10 Ent. LTSB N, et il me reste un casse-tête. Quand je me ne connecte à un share du NAS dans la VM windows, les transfert sont lents. J'attends péniblement 30 MB/s en read. Plus lent que mon Mac sur le réseau (en SMB aussi). -

Question avant de migrer vers une installation virtuelle

kouignamann replied to kouignamann's topic in Installation Virtuelle

Oui, alors mon erreur est encore plus bête que ça... Pour remote desktop il faut un Windows 10 Pro ou Entreprise. La version famille ne le supporte plus - alors que ça l'était dans Windows 7. Hum. J'ai installé Win 10 entreprise. En 3 clics ça marchait. 😒 Hier soir j'ai migré sur la version "HP" de ESXi 6.7 : HPE Custom Image for VMware ESXi 6.7 Rien de majeure à signaler. Le support hardware est parait-il meilleur. J'ai juste un dernier problème. Mes disques sont bien liés à la VM DSM en "RDM" - dans 6.7 c'est fait depuis l'admin web "Ajouter un disque dur brut". Malgré tout, mon DSM ne voit pas les infos des disques dur (numéro de série, état de santé...). Pas possible de faire un test SMART par exemple. En cherchant ici et là ça semble d'être une limitation à l'affectation de disques en RDM. J'utilise une carte IBM M1015 RAID en "IT Mode" pour connecter mes disques. L'alternative pour récupérer le contrôle "SMART" semble être de passer le controleur et non plus les disques. C'est possible/simple ? Je peux passer un seul des deux connecteurs SAS ? -

Question avant de migrer vers une installation virtuelle

kouignamann replied to kouignamann's topic in Installation Virtuelle

Oui. J'ai une VM Windows 10. J'essaie de m'y connecter avec "Connexion Bureau à Distance" depuis un poste sur mon réseau.