-

Posts

43 -

Joined

-

Last visited

Everything posted by Bulok

-

Problème Installation dva1622 sur HP Gen8 + 10Gb/s

Bulok replied to Bulok's topic in Compatibilité Hardware & Installation

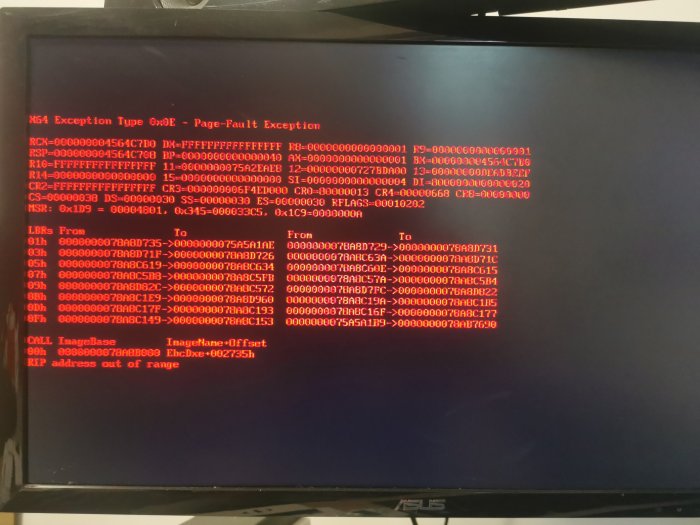

Ouff ça fait bine longtemps tout ça 😅... Je suis passé sur un Gen10+ pour pouvoir installer le DVA3221. Tout fonctionne, à part manque de bol, ma carte sfp+ 10gb/s 😂😂.. J'ai cet écran dès qu'il a chargé les options chipset.. J'ai tout essayé ce que j'ai pu trouvé sur le net, ça n'a jamais fonctionné.. (j'ai même mis à jour les firmwares, la partie logicielle.. ..). Si jamais vous avez la réponse.. Je suis preneur.. -

Problème Installation dva1622 sur HP Gen8 + 10Gb/s

Bulok replied to Bulok's topic in Compatibilité Hardware & Installation

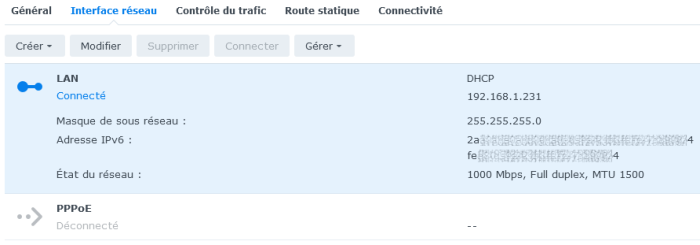

Je règle bien netif_num à 4 bien sûr ( c'était le premier truc auquel j'avais pensé lors de mon tout 1er essai ^^ ...) J'avoue ne pas avoir essayé en désactivant le chipset réseau interne ... je tenterais ça demain ifconfig me donne un résultat concernant uniquement Lo (localhost) et Eth0 (mon 1er rj45). Pour ip addr j'obtiens ça : 1: lo: <LOOPBACK,UP,LOWER_UP> mtu 65536 qdisc noqueue state UNKNOWN group default qlen 1 link/loopback 00:00:00:00:00:00 brd 00:00:00:00:00:00 inet 127.0.0.1/8 scope host lo valid_lft forever preferred_lft forever inet6 ::1/128 scope host valid_lft forever preferred_lft forever 2: eth0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc mq state UP group default qlen 1000 link/ether 98:XX:XX:XX:XX:98 brd ff:ff:ff:ff:ff:ff inet 192.168.1.231/24 brd 192.168.1.255 scope global eth0 valid_lft forever preferred_lft forever inet6 XXX1:XXa:XX0:XXX0:XXX2:XXXf:XXX7:XXX8/64 scope global mngtmpaddr dynamic valid_lft 86226sec preferred_lft 86226sec inet6 XXX0::XXX2:XXXf:XXX7:XXX8/64 scope link valid_lft forever preferred_lft forever 3: eth1: <BROADCAST,MULTICAST> mtu 1500 qdisc noop state DOWN group default qlen 1000 link/ether 98:XX:XX:XX:XX:99 brd ff:ff:ff:ff:ff:ff 4: eth2: <BROADCAST,MULTICAST> mtu 1500 qdisc noop portid 01000000000000000000004c3132345448 state DOWN group default qlen 1000 link/ether 2c:XX:XX:XX:XX:50 brd ff:ff:ff:ff:ff:ff 5: eth3: <BROADCAST,MULTICAST> mtu 1500 qdisc noop portid 02000000000000000000004c3132345448 state DOWN group default qlen 1000 link/ether 2c:XX:XX:XX:XX:54 brd ff:ff:ff:ff:ff:ff 6: sit0@NONE: <NOARP> mtu 1480 qdisc noop state DOWN group default qlen 1 link/sit 0.0.0.0 brd 0.0.0.0 -

Problème Installation dva1622 sur HP Gen8 + 10Gb/s

Bulok replied to Bulok's topic in Compatibilité Hardware & Installation

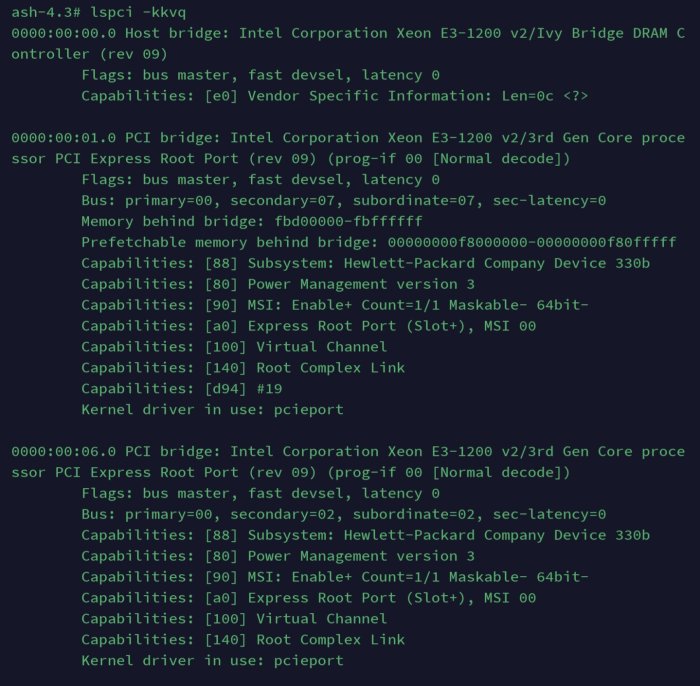

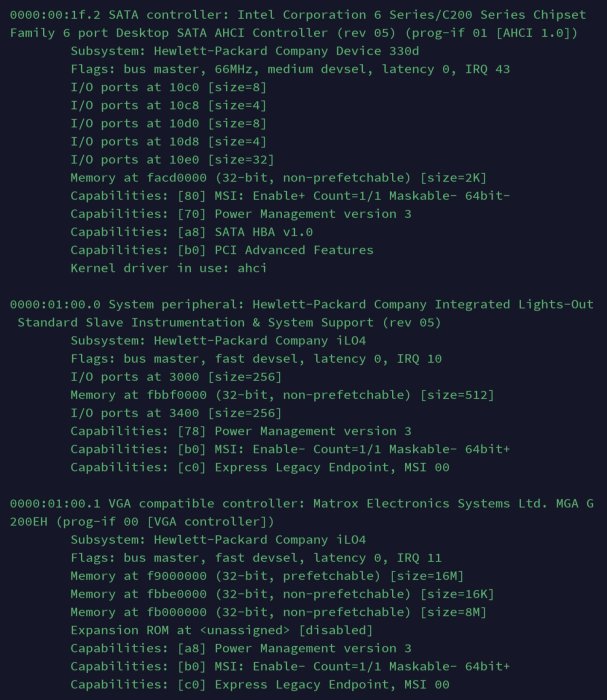

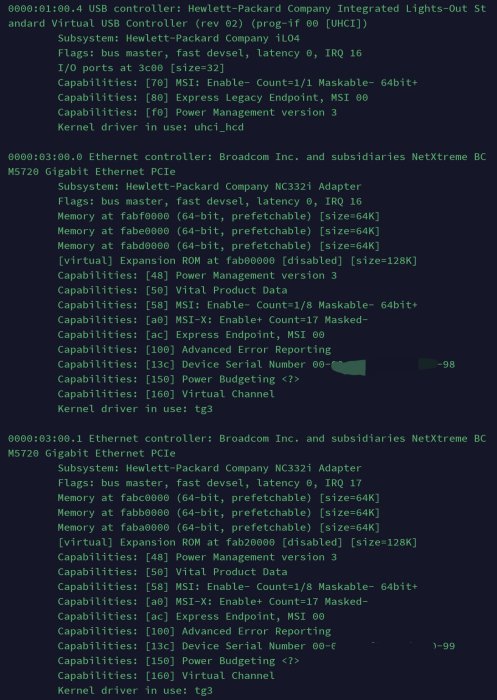

Bonsoir. J'ai fait quelques essais... Orphée : Malheureusement l'Ilo j'y connais rien ^^ ... du coup j'ai pas trop compris la démarche à suivre. J'ai refait une installation, comme d'habitude, j'ai mis les 4 adresser Mac lors de la création avec ARPL. Branché sur le 1er port rj45 je n'ai aucun pb, l'installation se passe correctement, et j'ai accès à DSM. J 'ai fait la commande lspci -kkvq et à quelques lignes près c'est quasi la même chose, y compris pour la partie réseau. Par contre, dans mon interface DSM, une fois que j'ai rebranché le câble sur ma carte SFP, puis reboot, je n'ai toujours que mon rj45 de fonctionnel et d'affiché ! Ne devrais-je pas avoir tout mes ports réseau même si ceux-ci sont inutilisés ? ( au même titre que dans DSM 6.1.7 ). La commande dmesg me donne énormément d'infos que je n'arrive pas à digérer 🤣 Par contre j'ai quand même réussi à retrouver ça dedans : [ 2.681226] be2net 0000:07:00.0: adapter not in advanced mode [ 2.689226] be2net 0000:07:00.0: FW config: function_mode=0x2003, function_caps=0xf [ 2.705227] usb 2-1: new high-speed USB device number 2 using ehci-pci [ 2.705382] usb 1-1: new high-speed USB device number 2 using ehci-pci [ 2.713229] be2net 0000:07:00.0: Max: txqs 16, rxqs 5, rss 4, eqs 16, vfs 0 [ 2.713383] be2net 0000:07:00.0: Max: uc-macs 30, mc-macs 64, vlans 64 [ 2.713574] be2net 0000:07:00.0: enabled 8 (out of 8) MSI-x vector(s) for NIC [ 2.767227] be2net 0000:07:00.0: created 4 TX queue(s) [ 2.787226] be2net 0000:07:00.0: created 5 RX queue(s) [ 2.803224] be2net 0000:07:00.0: FW version is 11.1.183.23 [ 2.813324] be2net 0000:07:00.0: Emulex OneConnect(be3): 10Gbps NIC "NC552SFP" PF port 1 [ 2.813521] be2net 0000:07:00.1: be2net version is 11.2.1193.91 [ 2.813741] be2net 0000:07:00.1: PCIe error reporting enabled [ 2.840578] Got empty serial number. Generate serial number from product. [ 2.840756] Got empty serial number. Generate serial number from product. [ 2.840908] drivers/usb/core/hub.c (2940) Same device found. Change serial to ffffffd1ffffffb2ffffffdbffffffa0 [ 2.841253] hub 2-1:1.0: USB hub found [ 2.841366] hub 1-1:1.0: USB hub found [ 2.841459] hub 2-1:1.0: 6 ports detected [ 2.841953] hub 1-1:1.0: 6 ports detected [ 2.930227] be2net 0000:07:00.1: adapter not in advanced mode [ 2.938226] be2net 0000:07:00.1: FW config: function_mode=0x2003, function_caps=0xf [ 2.962228] be2net 0000:07:00.1: Max: txqs 16, rxqs 5, rss 4, eqs 16, vfs 0 [ 2.962381] be2net 0000:07:00.1: Max: uc-macs 30, mc-macs 64, vlans 64 [ 2.962562] be2net 0000:07:00.1: enabled 8 (out of 8) MSI-x vector(s) for NIC [ 3.016230] be2net 0000:07:00.1: created 4 TX queue(s) [ 3.036226] be2net 0000:07:00.1: created 5 RX queue(s) [ 3.052227] be2net 0000:07:00.1: FW version is 11.1.183.23 [ 3.060350] be2net 0000:07:00.1: Emulex OneConnect(be3): 10Gbps NIC "NC552SFP" PF port 2 -

Problème Installation dva1622 sur HP Gen8 + 10Gb/s

Bulok replied to Bulok's topic in Compatibilité Hardware & Installation

Déjà essayé en incluant tout les modules mais ça ne règle pas le problème. -

Problème Installation dva1622 sur HP Gen8 + 10Gb/s

Bulok replied to Bulok's topic in Compatibilité Hardware & Installation

J'ai tenté de l'inclure en "add-on" dans Arpl, mais à chaque fois ça me dit le format de fichier n'est pas correct. Je m'y prend mal c'est sûr ! Je dois bien prendre le lien LINK qu'il mentionne pour le copier dans la boîte de dialogue "add add-on" ? -

Problème Installation dva1622 sur HP Gen8 + 10Gb/s

Bulok replied to Bulok's topic in Compatibilité Hardware & Installation

-

Problème Installation dva1622 sur HP Gen8 + 10Gb/s

Bulok replied to Bulok's topic in Compatibilité Hardware & Installation

Merci à tous pour vos réponses aussi rapides !!! Faire plusieurs VM ne me semble pas une option viable. Je suis en utilisation normale à 13go utilisés sur 16 niveau ram (serveur Minecraft, Ark, Valheim, Unifi Controller + Surveillance Station et Plex qui tournent h24). (charge cpu dans les 30% au grand max sauf lorsque docker se lance au boot du NAS ^^) ... J'ai fouillé dans ce sens au niveau driver, le chipset de ma carte réseau est un Emulex Blades-Engine 3 (be3) et je n'ai rien trouvé dans le rep-ext de pocopico qui ressemble à ce nom. Je lancerai la commande dans 1 petite heure (je peux pas tout couper comme ça pour tester malheureusement ^^). Une solution pour cette histoire de log igpu manquant ? Si le fichier reste de taille correct c'est pas trop un problème (au pire je lance un cron toutes les heures pour le vider...). J'aurais bien voulu passer à plus gros mais toujours en DVA, malheureusement rien d'autre de compatible avec mon Xeon E3-1240 v2. Merci encore en tout ça pour vos messages 😁👍🏻 -

Bonjour à toutes et à tous . Je suis actuellement en dsm 6.1.7 basé sur un ds3615xs, avec 4 hdd ainsi qu'une carte réseau 10gb/s sfp (une NC552sfp. Une de mes utilisations de celui-ci est en tant qu'NVR, mais ne pouvant acheter et valider de licence pour plus de 2 caméras je magouille un peu afin d'avoir plus de possibilités (y'a quelques topics sur ce forum chez les russes en ce sens....) Actuellement tout tourne correctement à par que je suis cantonné à une vieille version de Surveillance Station . Je souhaiterais passer sur une version 7.1.x de DSM sur un DVA1266 afin d'avoir de base 8 caméras inclues dans SS et ce qui me permettrais enfin de pouvoir mettre à jour ce paquet !! Mais voilà ,malgré avoir testé pendant des jours l'installation via tinycore ou Arpl , ma carte réseau sfp n'est jamais reconnue lors du build (aucun pb en passant par le rj45 de la cm en mettant 1 seule adresse MAC... Par contre ,le 2ème port réseau n'est pas reconnu non plus)... Si vous aviez des idées pour que ma carte sfp soit reconnue , je suis preneur ^^ .. Merci d'avance ! Cordialement , Cédric. Ps : j'ai bien évidemment tenté en déclarant les 4 adresses mac, même avec 1 seule de la carte sfp c'est toujours le rj45 qui est activé.

-

Besoin de conseil pour un passage à DSM 7.x

Bulok replied to youann's topic in Compatibilité Hardware & Installation

Mince, t'as même pas eu à rentrer les adresses mac ?? -

Besoin de conseil pour un passage à DSM 7.x

Bulok replied to youann's topic in Compatibilité Hardware & Installation

Bonsoir, je me permet de vous embêter un peu sur votre post, j'ai moi aussi un Gen8 (mais équipé d'un Xeon e3-1240v2) et d'une carte réseau 10G NC552SFP qui tourne actuellement en version 6.xxx. J'ai tenté de passer sur un dsm 7.1.1 ,via le superbe outil Arpl mais sur un Dva1622 et non pas un DSxxxxx ... Je n'arrive pas à avoir plus d'une interface réseau.. J'ai toujours le 1er port rj45 qui fonctionne, mais jamais le 2ème, ni même ceux de la carte 10G.. J'ai beau renseigner les 4 mac, puis mettre "netif_num=1" à 4, ça ne fonctionne jamais.. Qu'avez vous mis / fait comme modif pour pouvoir passer en 7.1 avec le réseau fonctionnel ? Merci d'avance pour vos réponses !! (Ps : je suis deg que la version dva3221 ne fonctionne aps sur le Gen8 .. Cpu trop vieux 😭) -

Bonjour , J'ai suivi ce poste avec attention car je voudrais faire exactement la même chose . J'ai juste une question un peu bête , qu'utilise tu pour relier la box au nas ? Est-ce qu'il faut choisir un câble particulier ou ce genre là suffirait : QSFPTEK SFP+ Câble DAC 10 GB/s https://amzn.eu/d/4WgQQ2K ?? Merci d'avance pour ta réponse

-

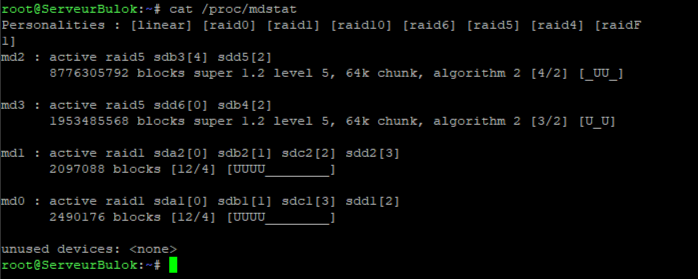

Je n'étais pas au courant de cette particularité ^^ .. Grâce à ça, j'ai pu enfin changer l'UUID de sdd5 pour le faire correspondre aux autres.. malgré tout, il me le comptait séparément sans pouvoir y faire quoi que ce soit.. J'avais toujours ce message : mdadm: superblock on /dev/sdd5 doesn't match others - assembly aborted Avec tout ça, il met toujours impossible de monter sdd5 dans un /dev/mdX . Quand aux 3 autres, même si je tente avec du resync ça ne fonctionne pas ... J'ai donc tenté l'inverse ... Ajouter /dev/sd[abc]5 à /dev/md127 qui contenait /dev/sdd5 .. Je m'attendais déjà à ce que ça ne fonctionne pas. Mais pas pour les raison qu'il m'a donné : Impossible de les ajouter car ils ne font pas la taille minimum (sdd5 faisant en 7To, et les autres 2.7 .. ). Dans tout les cas, pour le moment, impossible de retrouver mes données ... du coup je tente ceci : mdadm --create /dev/md2 -v -l 5 -n 4 /dev/sd[abcd]5 Réponse du bazar : mdadm: layout defaults to left-symmetric mdadm: chunk size defaults to 512K mdadm: /dev/sda5 appears to be part of a raid array: level=raid5 devices=4 ctime=Fri Jul 14 00:28:46 2017 mdadm: /dev/sdb5 appears to be part of a raid array: level=raid5 devices=4 ctime=Fri Jul 14 00:28:46 2017 mdadm: /dev/sdc5 appears to be part of a raid array: level=raid5 devices=4 ctime=Fri Jul 14 00:28:46 2017 mdadm: /dev/sdd5 appears to be part of a raid array: level=raid1 devices=1 ctime=Wed Feb 17 11:13:05 2021 mdadm: size set to 2925304320K mdadm: automatically enabling write-intent bitmap on large array mdadm: largest drive (/dev/sdd5) exceeds size (2925304320K) by more than 1% Ce qui est logique on va dire ... j'ai hésité pendant 20 mn avant de mettre Y :/ ( le temps d'aller faire la vaiselle 😅 ).. Un petit cat /proc/mdstat Personalities : [raid6] [raid5] [raid4] md2 : active raid5 sdd5[4] sdc5[2] sdb5[1] sda5[0] 8775912960 blocks super 1.2 level 5, 512k chunk, algorithm 2 [4/3] [UUU_] [>....................] recovery = 1.7% (49997740/2925304320) finish=325.4min speed=147240K/sec bitmap: 0/22 pages [0KB], 65536KB chunk et ensuite lsblk -f NAME FSTYPE LABEL UUID FSAVAIL FSUSE% MOUNTPOINT sda ├─sda1 linux_raid_member fecd3204-82f8-65da-3017-a5a8c86610be ├─sda2 linux_raid_member e3045bdc-4fcf-0ef3-7da4-9ce7f43eed39 [SWAP] ├─sda5 linux_raid_member ubuntu:2 c6f9494f-ec08-65e4-0659-b5790913c2f1 │ └─md2 └─sda6 linux_raid_member ServeurBulok:3 90318d27-94e7-eb14-07e5-21bbbdc21f46 sdb ├─sdb1 linux_raid_member fecd3204-82f8-65da-3017-a5a8c86610be ├─sdb2 linux_raid_member e3045bdc-4fcf-0ef3-7da4-9ce7f43eed39 [SWAP] └─sdb5 linux_raid_member ubuntu:2 c6f9494f-ec08-65e4-0659-b5790913c2f1 └─md2 sdc ├─sdc1 linux_raid_member fecd3204-82f8-65da-3017-a5a8c86610be ├─sdc2 linux_raid_member e3045bdc-4fcf-0ef3-7da4-9ce7f43eed39 [SWAP] ├─sdc5 linux_raid_member ubuntu:2 c6f9494f-ec08-65e4-0659-b5790913c2f1 │ └─md2 └─sdc6 linux_raid_member ServeurBulok:3 90318d27-94e7-eb14-07e5-21bbbdc21f46 sdd ├─sdd1 linux_raid_member fecd3204-82f8-65da-3017-a5a8c86610be ├─sdd2 linux_raid_member e3045bdc-4fcf-0ef3-7da4-9ce7f43eed39 [SWAP] └─sdd5 linux_raid_member ubuntu:2 c6f9494f-ec08-65e4-0659-b5790913c2f1 └─md2 Comme je m'en doutais, le raid a été recréé complet ... je pense pour cette fois, avoir définitivement écarté la possibilité de récupérer mes données ... Si jamais tu as des solutions pour après ( si ça existe) .. je suis preneur ^^ En tout cas, un enorme merci pour m'avoir déjà aiguillé jusque là :)

-

Ne réussissant pas a démonter md127 j'ai tout simplement reboot ^^ .. Du coup, j'avais déjà survolé le lien que tu m'as donné. Chaque fois que j'essaie quelque chose qui prend en compte sdd5 il me repond ça : root@ubuntu:~# mdadm --assemble /dev/md2 --update=uuid --uuid=7db29d47-2855-5582-f5b4-af6ddfd0692f /dev/sd[abcd]5 mdadm: superblock on /dev/sdd5 doesn't match others - assembly aborted J'ai aussi tenté un assemblage sans celui-ci .. du coup, je rencontre le 2ème problème qui fait que mon raid ne fonctionne pas : root@ubuntu:~# mdadm -A -v -U resync -f /dev/md2 /dev/sd[abc]5 mdadm: looking for devices for /dev/md2 mdadm: /dev/sda5 is identified as a member of /dev/md2, slot 2. mdadm: /dev/sdb5 is identified as a member of /dev/md2, slot 3. mdadm: /dev/sdc5 is identified as a member of /dev/md2, slot 0. mdadm: Marking array /dev/md2 as 'clean' mdadm: no uptodate device for slot 1 of /dev/md2 mdadm: added /dev/sda5 to /dev/md2 as 2 mdadm: added /dev/sdb5 to /dev/md2 as 3 (possibly out of date) mdadm: added /dev/sdc5 to /dev/md2 as 0 mdadm: /dev/md2 assembled from 2 drives - not enough to start the array. le slot 3 (sdb5) est (possibly out of date) ... De nouveau à patauger avec ce soucis où j'ai tenté pas mal de chose trouvé ça et là sur le net sans que ça fonctionne... Resultats de la commande mdadm -E /dev/sd[abcd]5 /dev/sda5: Magic : a92b4efc Version : 1.2 Feature Map : 0x0 Array UUID : 7db29d47:28555582:f5b4af6d:dfd0692f Name : ServeurBulok:2 Creation Time : Fri Jul 14 00:28:46 2017 Raid Level : raid5 Raid Devices : 4 Avail Dev Size : 5850870912 (2789.91 GiB 2995.65 GB) Array Size : 8776305792 (8369.74 GiB 8986.94 GB) Used Dev Size : 5850870528 (2789.91 GiB 2995.65 GB) Data Offset : 2048 sectors Super Offset : 8 sectors Unused Space : before=1968 sectors, after=384 sectors State : active Device UUID : 8ff66057:6bfd3d3f:839d32d1:544a8e43 Update Time : Wed Feb 17 10:45:25 2021 Checksum : 683bca71 - correct Events : 212432 Layout : left-symmetric Chunk Size : 64K Device Role : Active device 2 Array State : .AA. ('A' == active, '.' == missing, 'R' == replacing) --------------------------------------------------------------------------------- /dev/sdb5: Magic : a92b4efc Version : 1.2 Feature Map : 0x2 Array UUID : 7db29d47:28555582:f5b4af6d:dfd0692f Name : ServeurBulok:2 Creation Time : Fri Jul 14 00:28:46 2017 Raid Level : raid5 Raid Devices : 4 Avail Dev Size : 5850870912 (2789.91 GiB 2995.65 GB) Array Size : 8776305792 (8369.74 GiB 8986.94 GB) Used Dev Size : 5850870528 (2789.91 GiB 2995.65 GB) Data Offset : 2048 sectors Super Offset : 8 sectors Recovery Offset : 325168136 sectors Unused Space : before=1968 sectors, after=384 sectors State : active Device UUID : 8fd03008:06cefdad:e63d4d85:e2d48743 Update Time : Mon Feb 15 19:39:00 2021 Checksum : 4f432592 - correct Events : 212296 Layout : left-symmetric Chunk Size : 64K Device Role : Active device 3 Array State : AAAA ('A' == active, '.' == missing, 'R' == replacing) --------------------------------------------------------------------------------- /dev/sdc5: Magic : a92b4efc Version : 1.2 Feature Map : 0x0 Array UUID : 7db29d47:28555582:f5b4af6d:dfd0692f Name : ServeurBulok:2 Creation Time : Fri Jul 14 00:28:46 2017 Raid Level : raid5 Raid Devices : 4 Avail Dev Size : 5850870912 (2789.91 GiB 2995.65 GB) Array Size : 8776305792 (8369.74 GiB 8986.94 GB) Used Dev Size : 5850870528 (2789.91 GiB 2995.65 GB) Data Offset : 2048 sectors Super Offset : 8 sectors Unused Space : before=1968 sectors, after=384 sectors State : clean Device UUID : 5a6fe851:b07eadc3:7f4d7a25:13177e3c Update Time : Sun Feb 14 20:08:03 2021 Checksum : 346ad099 - correct Events : 212432 Layout : left-symmetric Chunk Size : 64K Device Role : Active device 0 Array State : AAAA ('A' == active, '.' == missing, 'R' == replacing) --------------------------------------------------------------------------------- /dev/sdd5: Magic : a92b4efc Version : 1.2 Feature Map : 0x0 Array UUID : fe7238e7:074459d5:13781f3e:2d99f6c4 Name : ServeurBulok:2 Creation Time : Wed Feb 17 11:13:05 2021 Raid Level : raid1 Raid Devices : 1 Avail Dev Size : 15618390912 (7447.43 GiB 7996.62 GB) Array Size : 7809195456 (7447.43 GiB 7996.62 GB) Data Offset : 2048 sectors Super Offset : 8 sectors Unused Space : before=1968 sectors, after=0 sectors State : clean Device UUID : 4a1bfb12:7bda5602:44af046f:02bb0588 Update Time : Wed Feb 17 14:45:44 2021 Checksum : 9f789670 - correct Events : 10 Device Role : Active device 0 Array State : A ('A' == active, '.' == missing, 'R' == replacing)

-

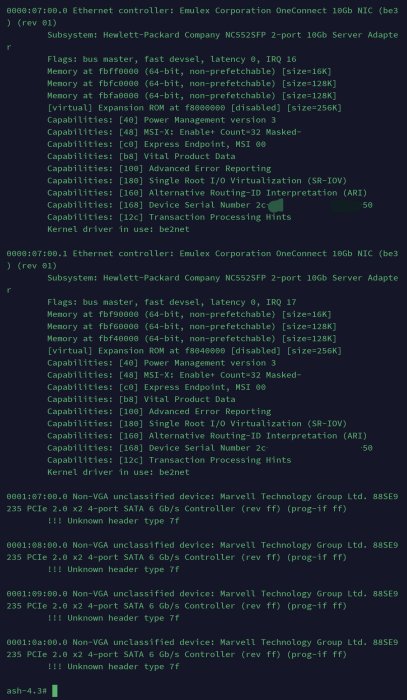

Hello Merci pour les infos que tu me donne.. Je pense que j'avance !!! Après montage avec un live CD, je pense avoir trouvé le pourquoi du comment !!... Si je ne me trompe pas, d'après mon screen. Mon hdd de 8To (qui est en fait le clone) n'a pas le même uuid pour la partition sdd5 que les autres... Donc pour lui, pas la même et donc planté !.. J'ai tenté de modifier l'uuid avec la commande "tune2fs -U <Mon UUID> /dev/sdd5" mais j'obtiens le message suivant : Numéro magique invalide dans le super-bloc lors de la tentative d'ouverture de /dev/sdd5 /dev/sdd5 contient un système de fichiers linux_raid_member étiqueté << ServeurBulok:2 >> Avec gparted je n eoeux pas modifier ce fameux Uuid, l'option est grisé. J'ai essayé aussi de démonté le point de montage /dev/md127 qui fait référence à sdd5.. J'ai comme résultat : Cannot get exclusive access to /dev/md127: Perhaps a running process, mounted fikesystem or active volume group. Pour le moment j'en suis là.. Je reste persuadé qu'en modifiant cet UUID qui ne correspond pas aux autres j'ai moyen d'avoir accès au raid !

-

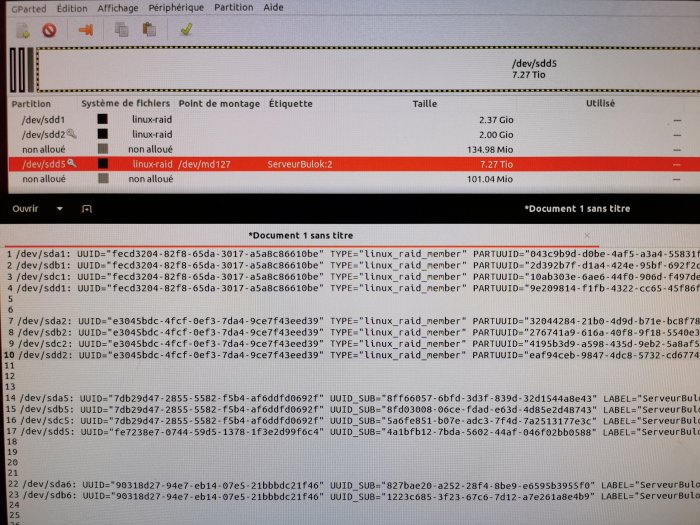

Je m'en suis douté un peu quand j'ai fais la fameuse commande cat /proc/mdstat... J'ai obtenu l'image que je joint. Si je comprend bien, c'est dans md2 et md3 que c'est le bordel, pour lui, il me manque 2 disque sur 4 pour l'un, et 1 sur les 3 pour l'autre (par contre, j'ai toujours eu 4 hdd dedans donc c'est bizarre ^^). Est-il possible de "combler" manuellement les trous manquants et de lui dire ou chercher les infos pour réformer le raid (et les 2 volumes présent dessus du coup).

-

Un énorme merci pour les explications !!! Au moins je comprend déjà mieux comment c'est rangé et à quoi ça correspond ^^.. Je vais regarder ce que ça donne et essayer de me débrouiller je reviendrais pour dire si j'ai réussi ou pas ^^

-

Quelqu'un de plus calé que moi avec l'outil mdadm pour m'aiguiller ou me dire si les données présentes sur mes hdd sont non récupérables ? Merci d'avance ^^

-

Petite news pour cette nuit, j'ai essayer de monter mon raid avec un Live-Ubuntu sur clé usb.. Après avoir suivi scrupuleusement le tuto Synology, j'arrive sur cette erreur lors de montage : mdadm: Duplicate MD device names in conf file where found. Du coup ça bloque là. Quand je vais dans le fichier /mdadm/mdadm.conf ça me donne ça : (c'est du copié /collé du net.. Les UUID n'étaient pas les mêmes).. # definitions of existing MD arrays ARRAY /dev/md/2 metadata=1.2 UUID=xxxxxxxxxxxxx name=ServeurBulok:2 ARRAY /dev/md/2 metadata=1.2 UUID=xxxxxxxxxxxxx name=ServeurBulok:2 ARRAY /dev/md/3 metadata=1.2 UUID=xxxxxxxxxxxxx name=ServeurBulok:3 Si je comprend bien, mon 1er hdd n'est plus visible (md/0) et le 2eme (md/1) est considéré comme le 3ème (md/2). À ce niveau, je n'ai pas trouvé comment faire pour lui donner le bon ordre des hdd 😕

-

Je n'ai pas encore osé installer windows dessus pour tester.. mais j'ai pas eu de plantage depuis hier avec 1 seul HDD dedans... Pour les températures, c'est sur que ce n'est pas ça. J'attends de voir si je peux récupérer mers données et je remet les autres disque dur dedans.

-

Merci pour ta réponse. D'après les tests ils sont bons aussi ... News : le serveur à planté même après avoir enlevé tout les HDD et laissé le neuf de 8To fraichement formaté ... Coup de sang, j'ai tout viré, nouvelle clé usb, nouvelle installation... j'ai eu du mal, .. je serais bien passé sur un 918+ avec le loader 1.04 mais impossible de le trouver sur le réseau ... J'ai récréé un raid ainsi que des volumes neufs avec mon HDD reçu il y a quelques jours ... Actuellement en vérification du disque... J'espère ça va passer ! Je testerais de récup mes données quand j'aurais fini de télécharger l'iso d'ubuntu (avec l'adsl, c'est long ^^ )...

-

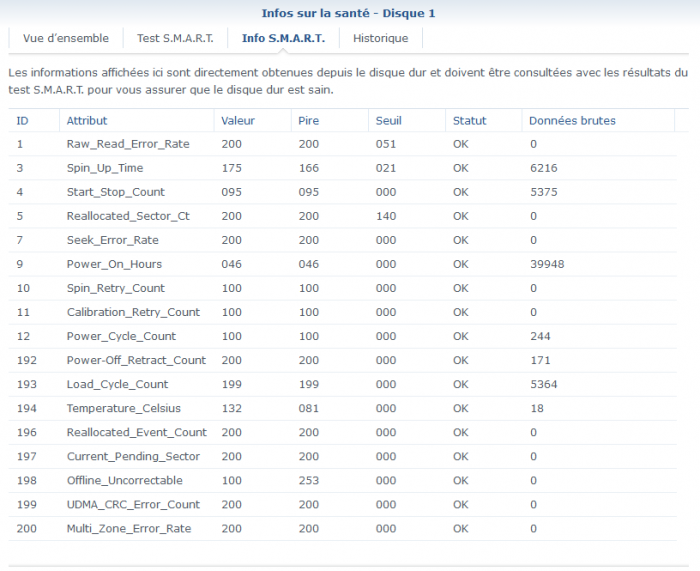

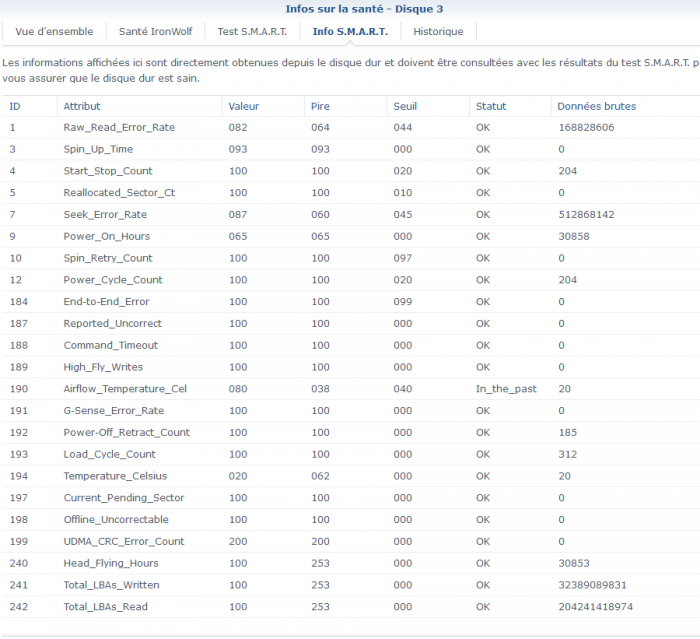

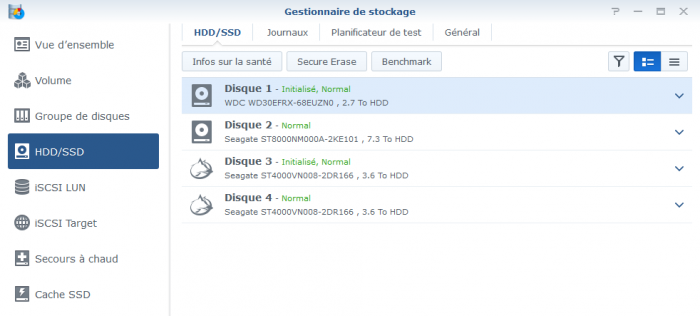

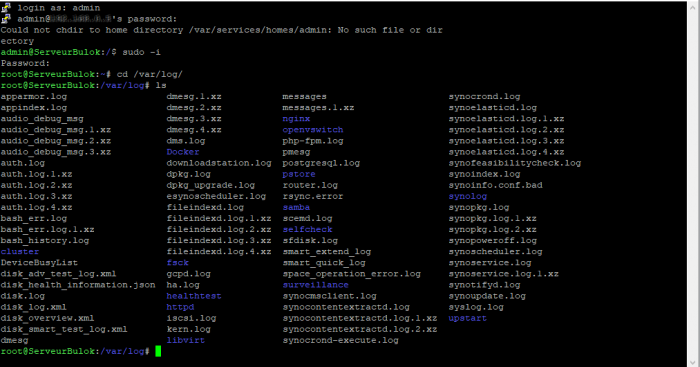

Voici les données que j'ai réussi à avoir ( j'ai voulu faire un test étendu mais le serveur à de nouveau crash ( il a tenu 5h51mn tout de même ^^ )... Les infos S.M.A.R.T. : (le disque 2 est tout neuf, reçu hier, clone du disque initialement monté à sa place). J'ai tenté plusieurs recherche sans trop comprendre ( même avec google trad j'ai du mal ^^ ) .. Voici d'autres captures :

-

Bonjour à toi ! C'était, avant de le dépoussiéré, dû au serveur de jeu Ark (avec une certaine map en mémoire).. Car lorsque je changeait celle-ci, ou que j'arrêtais ce paquet là en particulier je n'avais plus aucuns problèmes. Depuis, il plante à répétition, de jours comme de nuit ... C'était également lui qui jouait le rôle de serveur DHCP.... du coup, c'est un peu plus problématique dans la maison ^^. Pour le moment, vu que mon groupe raid est HS , je n'ai plus de plantage... (la reconstruction du groupe RAID SHR ne se fait pas )... Pour ce qui est des logs, je pense malheureusement qu'ils pourront rien nous apprendre : C'est pas tout récent 😕 Encore 4h de clonage pour mon hdd n°2 et je test ... mais je pense que je peut dire au revoir au groupe raid et le recréer... Une possibilité de récupérer les fichiers dedans quand même ? EDIT : 35mn après ce message, il me fait mentir ... De nouveau planté et plus accessible 😕