eviledeath

-

Posts

10 -

Joined

-

Last visited

Posts posted by eviledeath

-

-

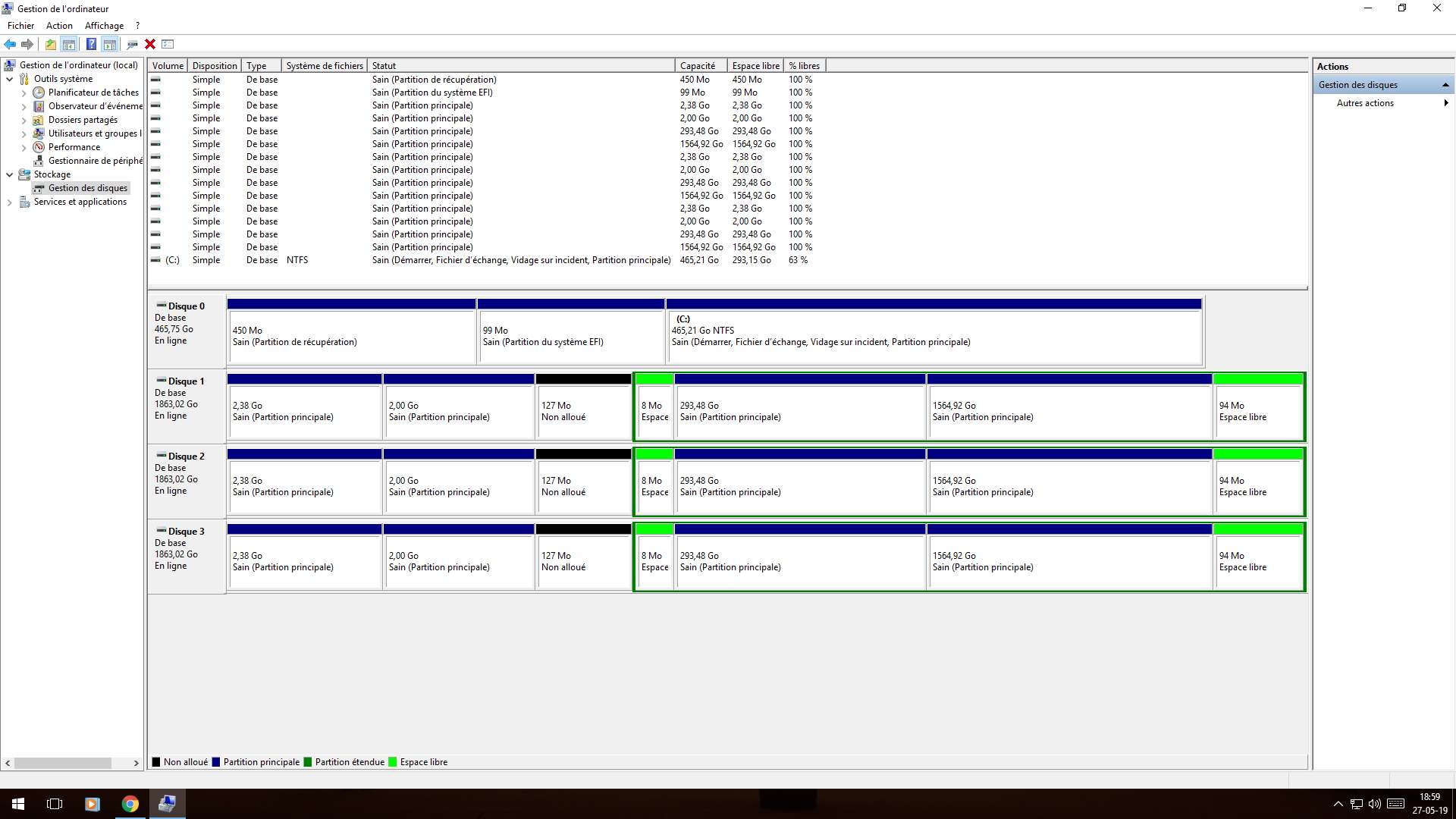

Voici sous le gestionnaire de disque de windows ce que cela donne

La structure est identique sur les 3.

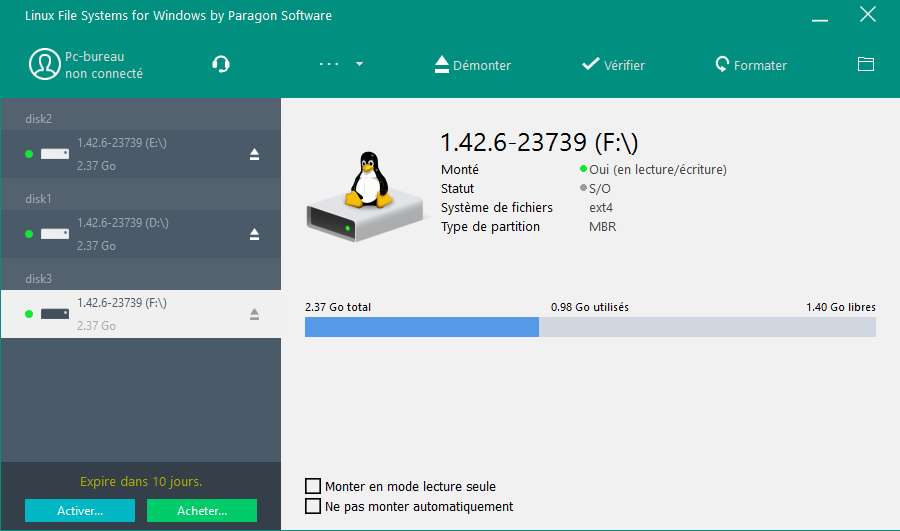

Avec LFS je n'accède cas la partition de DSM , cela rejoint ce que nicoueron disais plus haut , partition non active.

Je vais tester avec le disque qui était HS ce que cela donne.

-

Le pronostique me semble mal engagé.

J'espère qu'une personne qui sais donc comment activer une partition passe par mon topic.

Sinon j'essaie sur le côté de lire une partition Btrfs sous windows car en principe les données doivent ce trouver sur chaque disque durs.

-

Non pas accès ces exactement comme sur ta capture ces grisé.

Ces l'option que j'ai utilisé quand j'ai remplacé mon disque de 2TO qui était HS par le nouveau car a ce moment la j'y avais accés.

La réparation a duré 10h mais visiblement cela n'as pas fonctionné?

D'après mes logs l’opération de réparation a été un succès.

Mais le volume1 reste en statué crashé et aucuns dossier visible dans file station.

-

En effet étrange , ces peut-être cela le raid SHR?? un mélange de raid1 + un raid5?

J'ai bien 3 disques de 2TO dans ce raid.

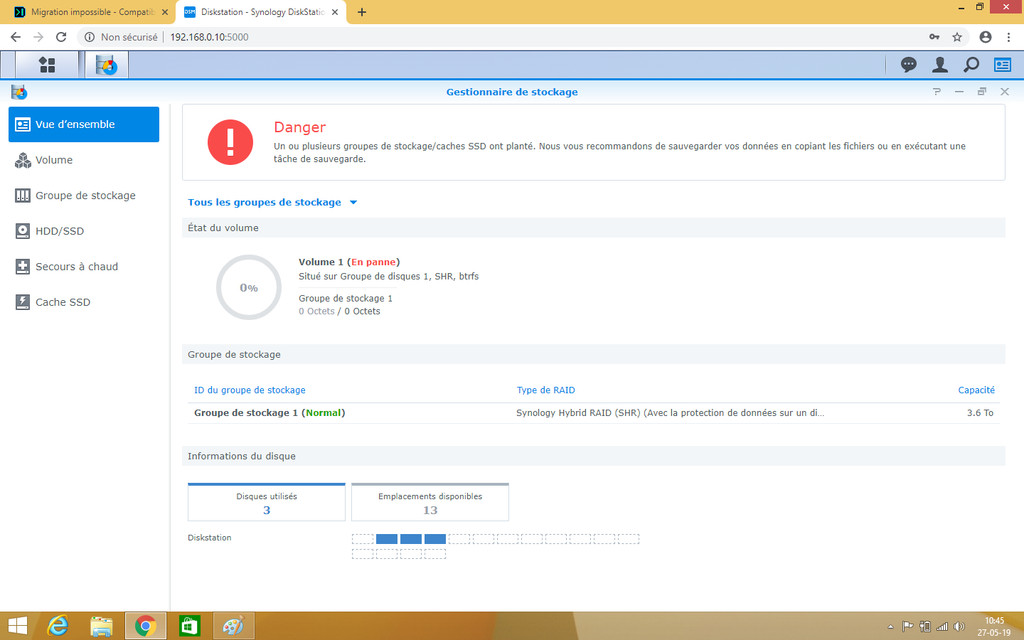

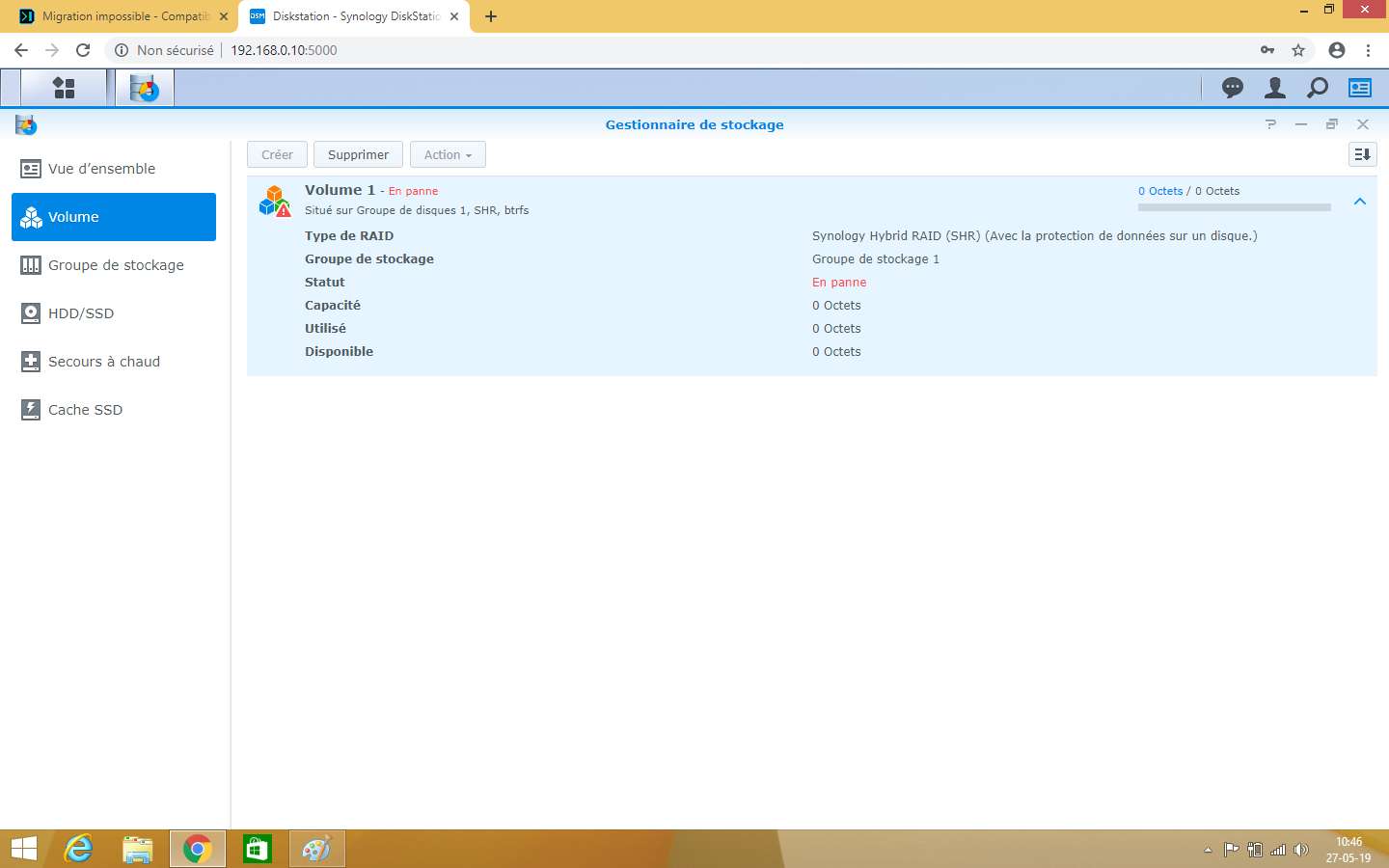

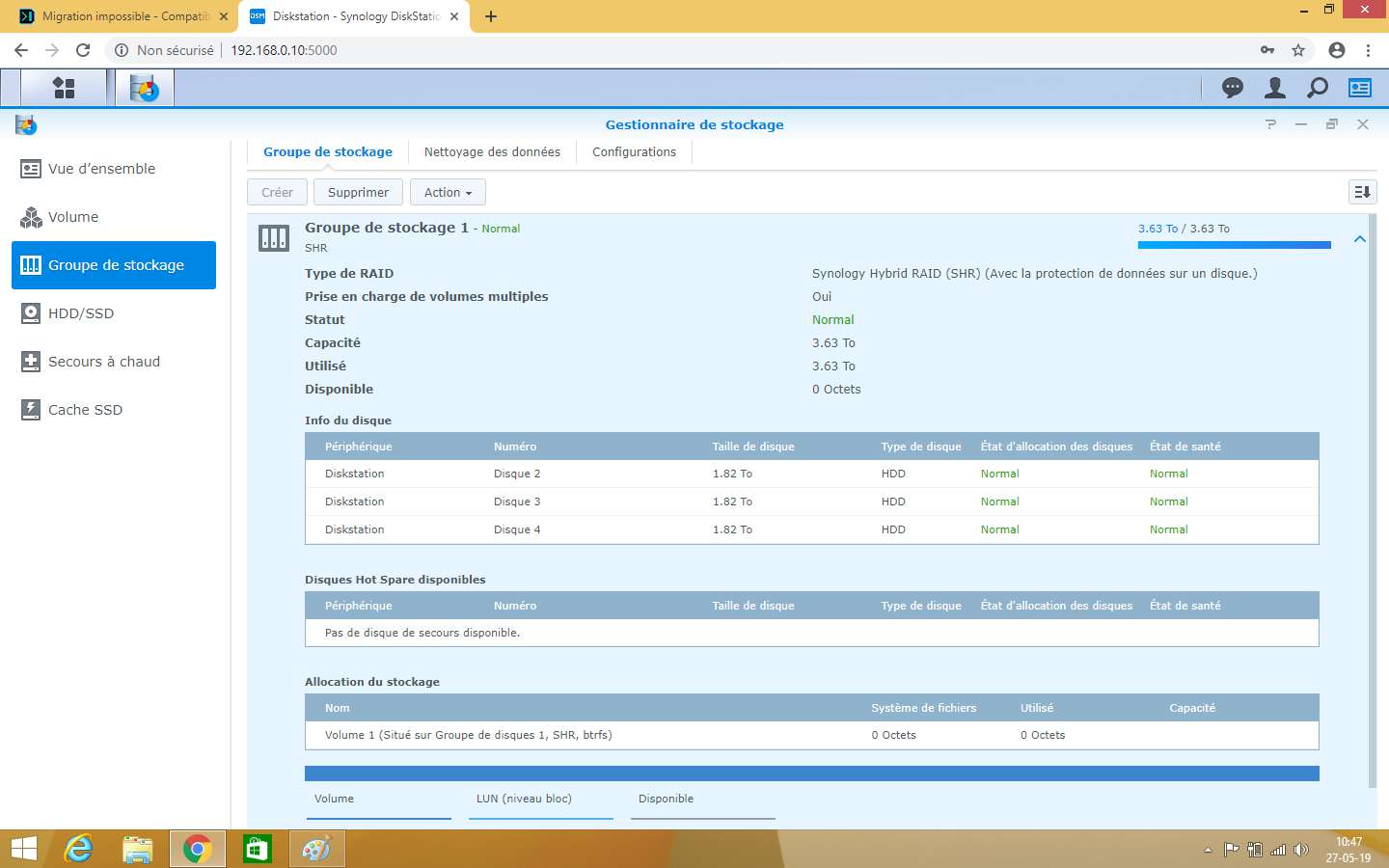

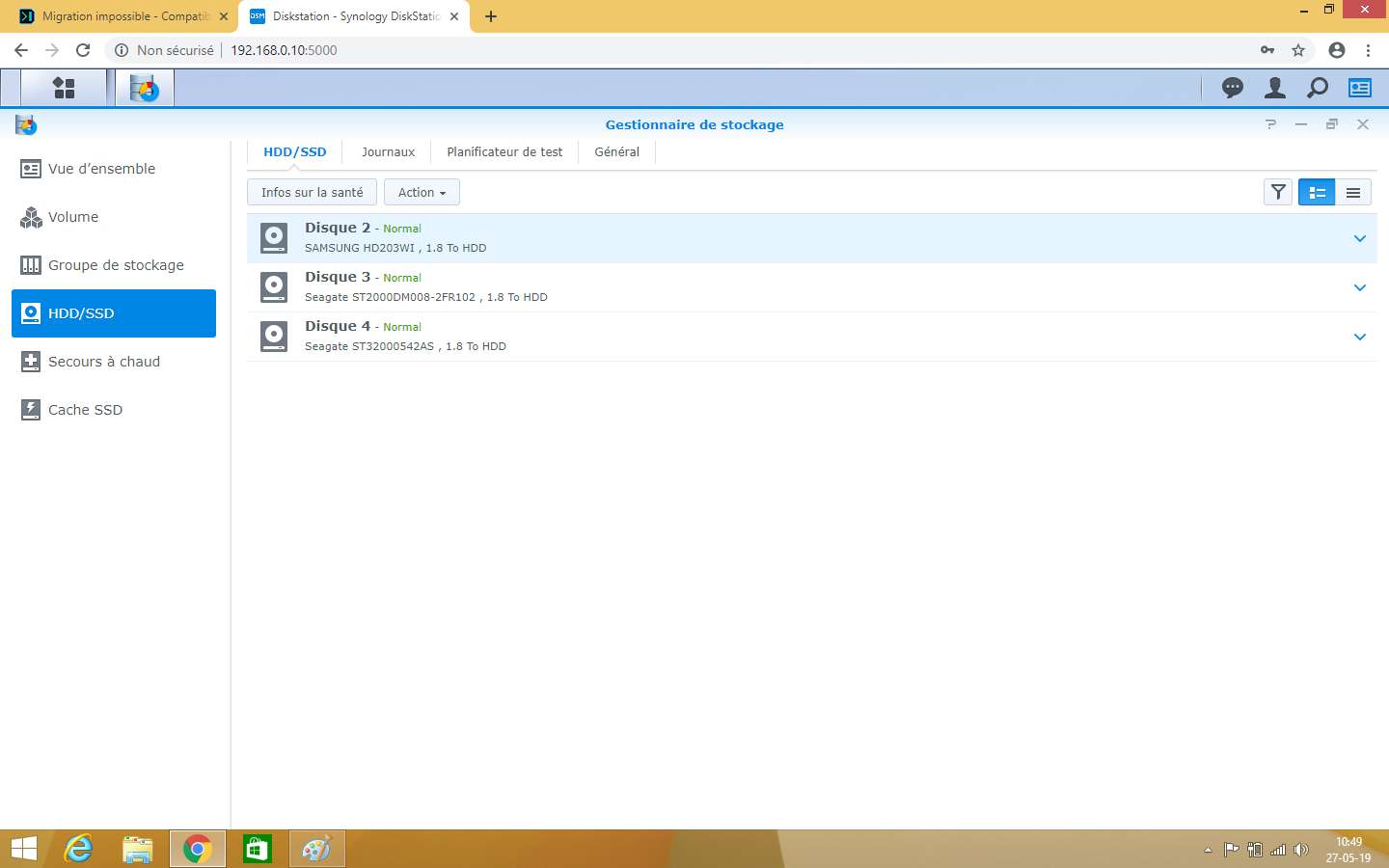

Voici les captures demandée.

Je ne sais pas si ces captures peuvent vous être utile.

Au niveau de l'interface DSM je ne sais plus rien faire a part supprimer le volume pour en créer un nouveau ce que je ne vais bien évidement pas faire.

-

Voilà j'ai placé un nouveau disque de 2TO a place du disque HS et j'ai lancé la réparation du raid.

Celui ci vient de terminer ( 10h au total ) mais le volume 1 reste toujours en statut en panne que faire??

Voici ce que me donne la commande cat /proc/mdstat

admin@Diskstation:/$ cat /proc/mdstat Personalities : [linear] [raid0] [raid1] [raid10] [raid6] [raid5] [raid4] md2 : active raid5 sdc5[3] sdb5[2] sdd5[1] 615480192 blocks super 1.2 level 5, 64k chunk, algorithm 2 [3/3] [UUU] md3 : active raid5 sdd6[0] sdc6[3] sdb6[1] 3281868544 blocks super 1.2 level 5, 64k chunk, algorithm 2 [3/3] [UUU] md1 : active raid1 sdb2[1] sdc2[0] sdd2[2] 2097088 blocks [16/3] [UUU_____________] md0 : active raid1 sdb1[1] sdc1[0] sdd1[2] 2490176 blocks [16/3] [UUU_____________]lvdisplay

admin@Diskstation:/$ sudo lvdisplay Password: --- Logical volume --- LV Path /dev/vg1/syno_vg_reserved_area LV Name syno_vg_reserved_area VG Name vg1 LV UUID BGfRWM-A18v-ppnn-MKUA-Yh2D-232D-dqxpvO LV Write Access read/write LV Creation host, time , LV Status available # open 0 LV Size 12.00 MiB Current LE 3 Segments 1 Allocation inherit Read ahead sectors auto - currently set to 512 Block device 252:0 --- Logical volume --- LV Path /dev/vg1/volume_1 LV Name volume_1 VG Name vg1 LV UUID rKPiVZ-NZHQ-4Lrw-BSOQ-pIW5-mn1S-rgzLqH LV Write Access read/write LV Creation host, time , LV Status available # open 0 LV Size 3.63 TiB Current LE 951497 Segments 3 Allocation inherit Read ahead sectors auto - currently set to 4096 Block device 252:1pvdisplay

admin@Diskstation:/$ sudo pvdisplay --- Physical volume --- PV Name /dev/md2 VG Name vg1 PV Size 586.97 GiB / not usable 2.31 MiB Allocatable yes (but full) PE Size 4.00 MiB Total PE 150263 Free PE 0 Allocated PE 150263 PV UUID QKR628-jSA3-vM1y-e0o1-96uJ-LsjV-QXLDMN --- Physical volume --- PV Name /dev/md3 VG Name vg1 PV Size 3.06 TiB / not usable 1.19 MiB Allocatable yes (but full) PE Size 4.00 MiB Total PE 801237 Free PE 0 Allocated PE 801237 PV UUID meTjFW-l23c-qq9i-iVp3-s1I6-P1wf-zaDIYYMerci pour votre aide.

-

Bonjour,

Merci pour votre aide précieuse , en effet les 3 disques sont strictement différents ce sont principalement des disques de récupération.

Je vais cette après midis acheter un nouveau disque de 4TO tant cas faire et effectuer la réparation du raid.

Un amis est passé hier en allant en ssh le volume1 est bien la mais ces mit en protection.

Je revient vers vous pour vous dire si cela a marcher.

-

J'ai choisis la solution la plus appropriée a mes compétences , j'ai transformé mon pc en nas.

Cela a bien fonctionné le nas est relancé avec une nouvelle installation en 6.2.23739

Par contre pas accès a mes données ça ces pas cool malgré un raid5

Mais mon volume est en statut "Danger Volume planté" a cause de l'un de mes 3 disques qui est HS.

Ma dernière question étant la suivante , si je remplace le disque défectueux que le répare le raid j'aurais de nouveau accés a mes données??

Merci encore pour votre aide.

-

Merci pour ta réponse.

Très bonne question je ne savais pas qu'il y avait les deux.

J'ai téléchargé le fichier DSM_DS3615xs_8451.pat qui correspond a la dernière version supportée par le loader 1.1

A cette adresse https://archive.synology.com/download/DSM/release/6.0.2/8451/

Downgrader sur qu'elle version??

Après annalyse des disques sur mon pc sous windows 10 l'un de mes 3 disques est HS étrange que cela n'aie pas été détecté.

J'avais donc dans l'idée de monter mes disques sur mon pc de bureau qui dispose d'un cpu intel plus récent et de passer sur le loader 1.4 juste pour récupérer mes données.

Ou via un linux bootable?? mais je n'y connais rien en linux.

Sous windows les partitions ne sont pas accessibles.

-

Bonjour à tous,

Tout d'abord un énorme merci a votre communauté pour le travail que vous avez accomplit.

Mon Nas est sous expenology 6.0.2-8451 a la base avec loader v1.1

Suite a une mauvaise manipulation de ma part je me suis retrouver a faire une mise à jours vers la dernière version oupsss

J'ai bien évidement essayé de refaire la clés usb avec le dernier loader en date v1.4 mais impossible de détecter mon nas sur mon réseau.

A priori le seul loader qui soit supporter par mon cpu AMD A4-3400 est le 1.1 avec l'option AMD.

Après des heures a tester différentes clés j'ai réussis a retrouver mon nas sur mon réseau.

Maintenant il me demander de migrer seulement voià j'ai une belle erreur 13 fichier endommagé vous avez des idées de la cause??

Quand j'essaie via synology manager la j'ai une erreur 21?? ouvrir le port 23.

J'ai des données importantes a récupérer sur les disques raid ( 3x 2TO).

D'avance un tout grand merci.

Migration impossible

in Compatibilité Hardware & Installation

Posted

Merci JacquesF pour ton intérêt.

Effectivement ces le btrfs qui pose soucis dans mon cas , je vais repasser en ext4 pour la prochaine fois.

J'ai essayé plusieurs commandes hier avec un amis sous linux live.

Il ne veux rien savoir /dev/vg1/volume_1 reste inaccessible , les données sont pourtant belle et bien présentes.

Je crois que je vais jeter l'éponge , 5 jours que je suis dessus.