use-nas

Member-

Posts

514 -

Joined

-

Last visited

-

Days Won

4

Everything posted by use-nas

-

Переход на 7.Х.Х с помощью Automated Redpill loader

use-nas replied to Olegin's topic in Програмное обеспечение

а почему md2? нужно смотреть fdisk -l по всем дискам -

Переход на 7.Х.Х с помощью Automated Redpill loader

use-nas replied to Olegin's topic in Програмное обеспечение

Ну не совсем так... Мы не меняем тип рейда, а меняем кол-во дисков в нем... В 5 райде мин. дисков - 3, у тебя будет 4)) Т.к данные и коды четности есть. -

Переход на 7.Х.Х с помощью Automated Redpill loader

use-nas replied to Olegin's topic in Програмное обеспечение

SHR или SHR2? Первый это Райд5, и какой диск (по объёму) нужно выкинуть? Пункт деактивировать доступен на нем? -

Переход на 7.Х.Х с помощью Automated Redpill loader

use-nas replied to Olegin's topic in Програмное обеспечение

Фокус с изменением SHR в Basic прошёл успешно 🙄 Задача - переехать на другой диск без потери данных и системных приложений. (одиночный диск) 1. Подключаем новый диск и добавляем в наш массив SHR (будет создан RAID1 из 2-х дисков) 2. Деактивируем наш старый диск в диспетчере хранения (система будет сильно ругаться, но не беда ) 3. Заходим по SSH 4. sudo -i cat /proc/mdstat смотрим номер нашего массива обычно md2, если наш пул хранения 1 (первые два это системные) mdadm --grow --raid-devices=1 --force /dev/md2 команда переведет наш массив из 2-х дисков в массив из 1 диска. Радуемся )) -

Переход на 7.Х.Х с помощью Automated Redpill loader

use-nas replied to Olegin's topic in Програмное обеспечение

И к чему этот геморрой ....куча дешёвых беспроблемных. -

Переход на 7.Х.Х с помощью Automated Redpill loader

use-nas replied to Olegin's topic in Програмное обеспечение

Судя по даташиту AHCI Inbox Driver Support Yes... должен заводиться без доп драйвера. -

Переход на 7.Х.Х с помощью Automated Redpill loader

use-nas replied to Olegin's topic in Програмное обеспечение

Для него не потребуется драйвер... если не использовать режим райд1. Воткни и проверь прям в ARPL. -

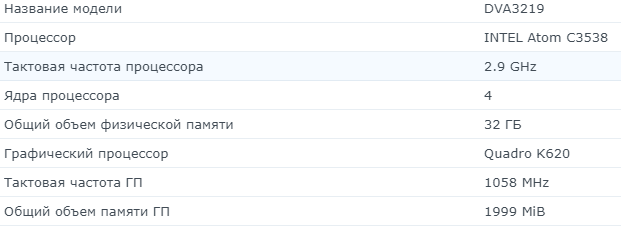

Первый диск можно 10Гб (загрузчик) оставить, а вот второй минимум 22Гб (система и SS). Оба диска SATA. Одно ядро и 1 Гб памяти. Это для DVA 3219.

-

Переход на 7.Х.Х с помощью Automated Redpill loader

use-nas replied to Olegin's topic in Програмное обеспечение

-

Задачу для начала определить ... https://www.synology.com/ru-ru/support/RAID_calculator?hdds= в помошь..

-

Помогите завести видеядро на g6400

use-nas replied to bobval's topic in Аппаратное обеспечение и совместимость

В докер прокидывается видио .. в чем прикол )) уж и не помню сколько лет назад это было.. Только зачем докер если и так работает.. -

Никак )) можно только заменить на такой же или больше

-

Помогите завести видеядро на g6400

use-nas replied to bobval's topic in Аппаратное обеспечение и совместимость

UHD-графика Intel® 610 Можно попробовать свежие драйвера для i915 (10поколение) в ARPL. -

Переход на 7.Х.Х с помощью Automated Redpill loader

use-nas replied to Olegin's topic in Програмное обеспечение

Валидная пара ... -

восстанови оригинал /root/libsynonvme.so

-

sudo -i curl -L "https://github.com/PeterSuh-Q3/rp-ext/raw/main/nvme-cache/src/nvme-cache.sh" -O chmod +x nvme-cache.sh ./nvme-cache.sh для DVA**** нужно еще В synoinfo.conf добавить: supportnvme="yes"

-

На 920 заработает HW на процессоре, если драйвер i915 загрузился ... про нвидиа можно забыть .. Если сильно нужно Нвидиа тогда DVA3221.

-

-

Где смотрим? Может 100Мбайт/сек.

-

Переход на 7.Х.Х с помощью Automated Redpill loader

use-nas replied to Olegin's topic in Програмное обеспечение

Можно вручную, даже перезагрузки не потребуется. -

Переход на 7.Х.Х с помощью Automated Redpill loader

use-nas replied to Olegin's topic in Програмное обеспечение

7.1.1-42962-3 Исправлены многочисленные уязвимости безопасности. -

-

Переход на 7.Х.Х с помощью Automated Redpill loader

use-nas replied to Olegin's topic in Програмное обеспечение

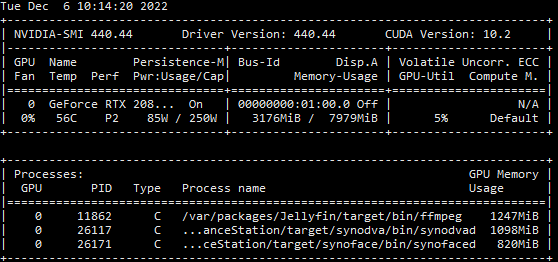

+-----------------------------------------------------------------------------+ | NVIDIA-SMI 440.44 Driver Version: 440.44 CUDA Version: 10.2 | |-------------------------------+----------------------+----------------------+ | GPU Name Persistence-M| Bus-Id Disp.A | Volatile Uncorr. ECC | | Fan Temp Perf Pwr:Usage/Cap| Memory-Usage | GPU-Util Compute M. | |===============================+======================+======================| | 0 Quadro K620 On | 00000000:01:00.0 Off | N/A | | 34% 48C P0 3W / 30W | 456MiB / 1999MiB | 20% Default | +-------------------------------+----------------------+----------------------+ +-----------------------------------------------------------------------------+ | Processes: GPU Memory | | GPU PID Type Process name Usage | |=============================================================================| | 0 927 C ...anceStation/target/synodva/bin/synodvad 374MiB | | 0 1129 C ...ceStation/target/synoface/bin/synofaced 70MiB | +-----------------------------------------------------------------------------+ Работает только обнаружение вторжения 😐 -

Переход на 7.Х.Х с помощью Automated Redpill loader

use-nas replied to Olegin's topic in Програмное обеспечение

fdisk -l /dev/nvme0n1 Disk /dev/nvme0n1: 232.9 GiB, 250059350016 bytes, 488397168 sectors Disk model: Samsung SSD 970 EVO Plus 250GB Units: sectors of 1 * 512 = 512 bytes Sector size (logical/physical): 512 bytes / 512 bytes I/O size (minimum/optimal): 512 bytes / 512 bytes Disklabel type: dos Disk identifier: 0x955fdf89 Device Boot Start End Sectors Size Id Type /dev/nvme0n1p1 256 4980735 4980480 2.4G fd Linux raid autodetect /dev/nvme0n1p2 4980736 9175039 4194304 2G fd Linux raid autodetect /dev/nvme0n1p3 9437184 488392064 478954881 228.4G fd Linux raid autodetect cat /proc/mdstat Personalities : [raid1] md4 : active raid1 nvme0n1p3[0] 239476416 blocks super 1.2 [1/1] [U] md2 : active raid1 sata1p5[0] 477659584 blocks super 1.2 [1/1] [U] md1 : active raid1 sata1p2[0] 2097088 blocks [5/1] [U____] md0 : active raid1 sata1p1[0] 8388544 blocks [5/1] [U____] Только первые 2 раздела 4.5Гб не используются 🙁 -

Переход на 7.Х.Х с помощью Automated Redpill loader

use-nas replied to Olegin's topic in Програмное обеспечение